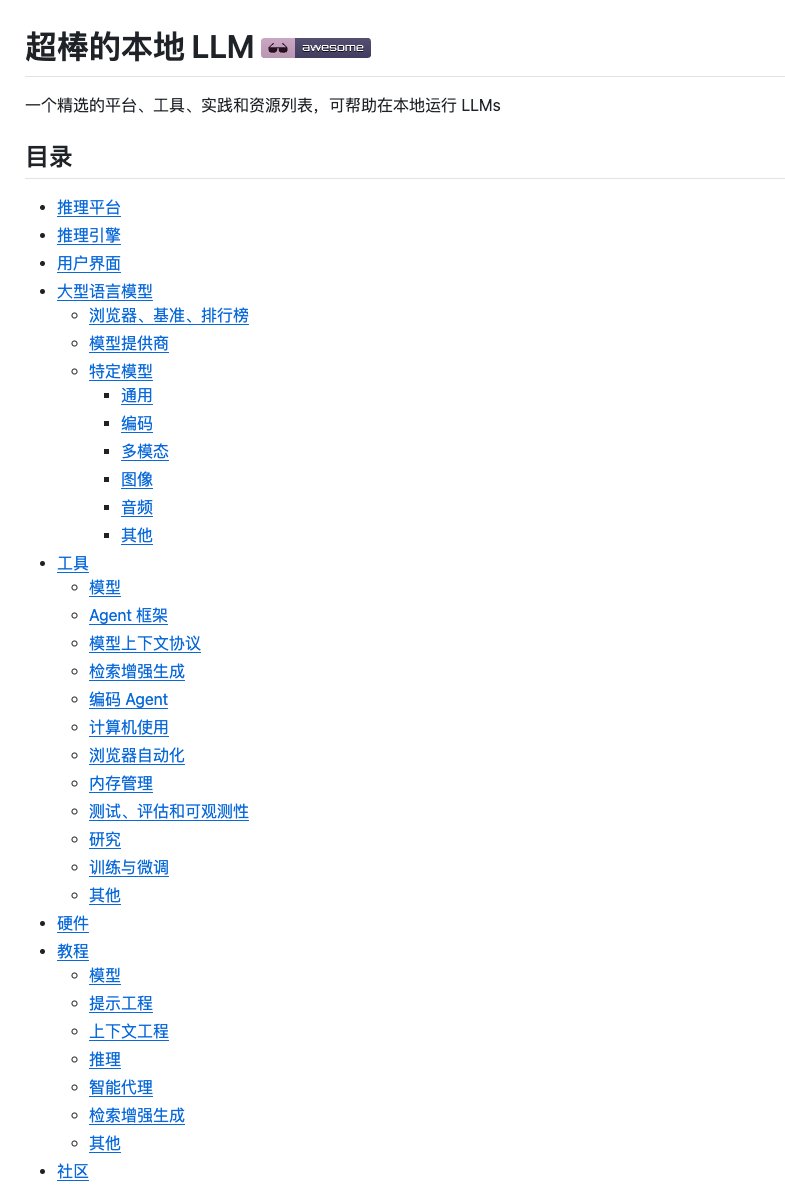

Implantar modelos grandes localmente pode ser uma tarefa árdua devido à enorme quantidade de ferramentas e tutoriais disponíveis. Num instante é Ollam, no seguinte é vLLM, e existem todos os tipos de frameworks de ajuste fino. Encontrar uma solução confiável pode ser um desafio. Me deparei com o incrível projeto local LLM no GitHub, que é como uma "enciclopédia" para executar grandes modelos localmente. Além de ser abrangente, sua lógica de classificação é muito clara, o que nos ajuda a entender rapidamente a pilha de tecnologias. Abrange mais de uma dúzia de categorias, incluindo plataformas de inferência, mecanismos de inferência, interfaces de usuário, grandes modelos de linguagem e ferramentas de desenvolvimento, além de dicas para seleção de hardware e tutoriais práticos. GitHub: https://t.co/9OJw4ll84L Cada projeto é identificado pela sua classificação no GitHub Stars e uma breve descrição, facilitando a identificação da sua popularidade e finalidade. Inclui também recursos de aprendizagem, como tutoriais do YouTube e análises de hardware. Se você deseja construir um ambiente de modelagem local em larga escala ou está procurando por ferramentas de código aberto com funções específicas, vale a pena salvar esta coleção para referência futura.

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.