Um novo membro foi adicionado ao modelo de código aberto de grande porte desenvolvido internamente. Hoje mesmo, a Baidu disponibilizou em código aberto mais um modelo de pensamento multimodal: ERNIE-4.5-VL-28B-A3B-Thinking. Com apenas 3 bilhões de parâmetros de ativação, suas capacidades de compreensão e raciocínio multimodal se aproximam das dos modelos GPT-5-High e Gemini-2.5-Pro. O grande destaque desta vez é a sua capacidade de "pensamento visual", que permite aos usuários ampliar e reduzir o zoom das imagens, observar cuidadosamente os detalhes e, em seguida, refletir e responder a perguntas. Assim como as pessoas, quando veem uma imagem, elas pensam, a compreendem e depois contam a todos o que ela contém. Abaixo estão os casos de teste oficiais. Vamos dar uma olhada:

Um meme clássico que retrata a carga de trabalho real dos trabalhadores (Figura 1). O modelo consegue compreender o humor na imagem e explica detalhadamente como a imagem atinge com precisão os pontos problemáticos dos trabalhadores modernos (Figura 2).

Foto de um bolo da lua vencido, com a data de validade borrada (Figura 1). Mesmo que uma pessoa dê zoom na foto ao seu tamanho máximo, ela mal conseguirá vê-la com clareza, mas ainda assim poderá perceber corretamente que "o bolo da lua expirou" (Figura 2).

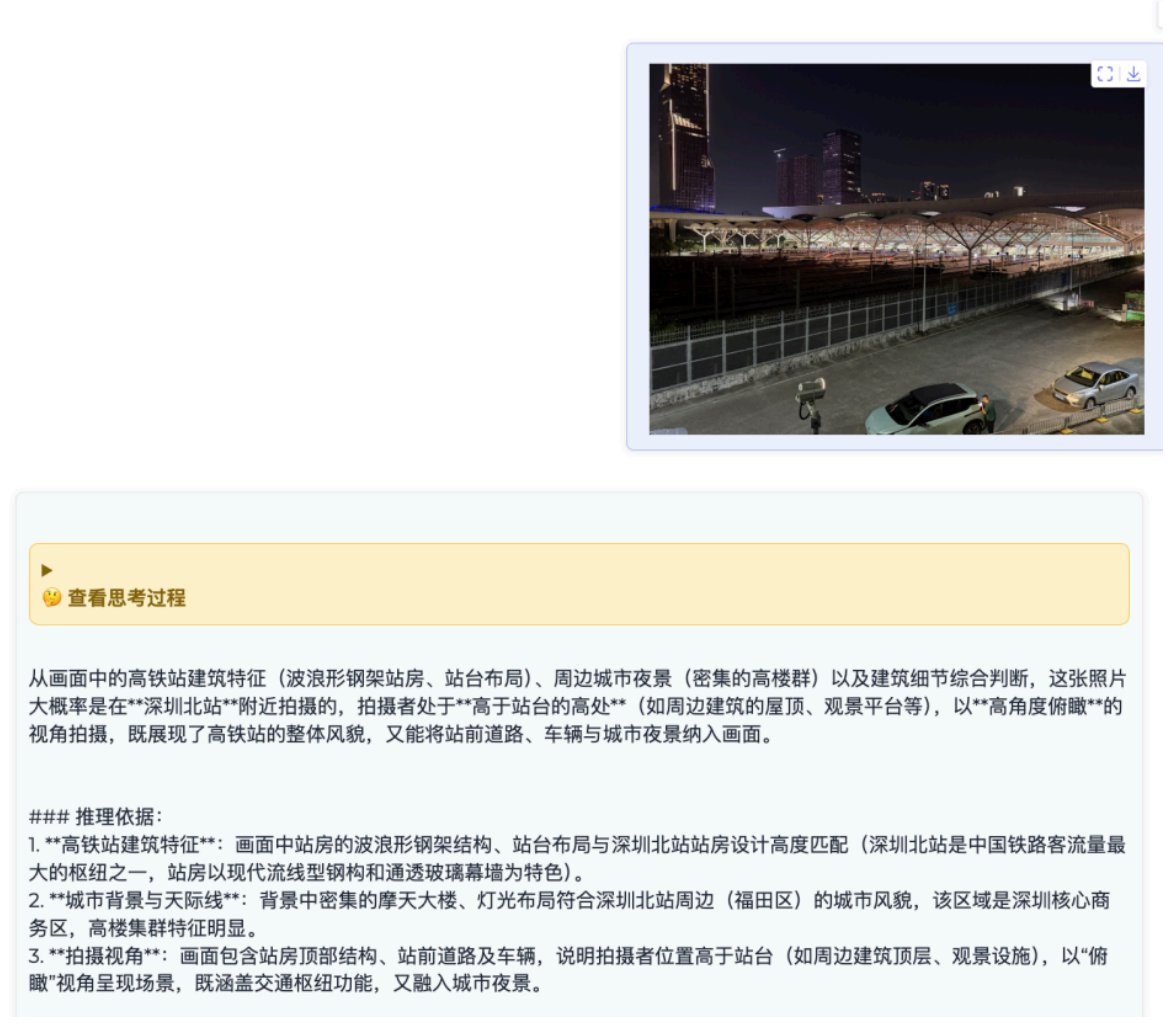

Além disso, uma foto noturna tirada no norte de Shenzhen (Figura 1). Sem qualquer instrução, ele consegue determinar o local específico da filmagem com base nas características arquitetônicas da imagem (Figura 2). E é baseado em raciocínio e evidências sólidas, o que é realmente impressionante.

De modo geral, a capacidade de "pensamento imagético" introduzida por estehuggingface.co/baidu/ERNIE-4.…nte forte; parece ser capaz de realmente ver e compreender informações visuais. Ainda não há uma demonstração online disponível, mas o modelo é de código aberto. Download do modelo: https://t.co/WOYawrwuZL