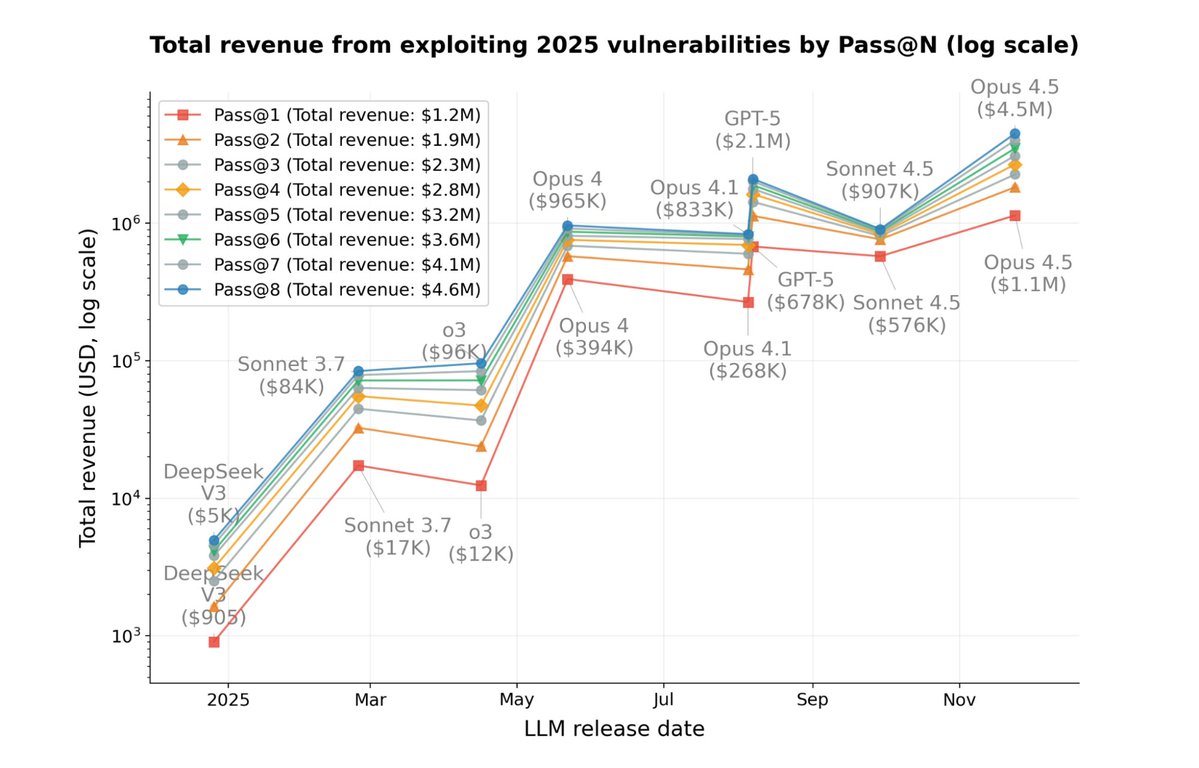

éclatement Anthropic Red Team utilise l'IA pour attaquer la blockchain J'ai réussi à voler 4,6 millions de dollars...😅 L’équipe rouge anthropologique, en collaboration avec les boursiers du MATS, a mené une étude qui a soulevé une question clé : Quel est l’impact économique potentiel de l’IA lorsqu’elle possède des « capacités offensives en réseau » ? Contrairement aux recherches précédentes en cybersécurité, cette étude est la première à tenter de quantifier les capacités des cyberattaques d'IA en termes de **valeur économique**, plutôt qu'en termes de « taux de réussite » ou de « nombre de vulnérabilités ». Ils ont essayé d'amener l'IA à attaquer les « contrats intelligents » sur la blockchain pour voir si « l'IA peut réellement trouver des vulnérabilités sur la blockchain et en tirer profit par elle-même ? » Il existe trois raisons principales justifiant le choix des contrats intelligents comme sujet de recherche : - Le code source des contrats intelligents est ouvert et leur logique est transparente, ce qui les rend adaptés à l'analyse par IA ; - Les vulnérabilités du contrat sont directement liées à des pertes économiques, qui peuvent être calculées en utilisant le cours réel de la devise ; - Le fonctionnement d'une blockchain peut être reproduit dans un environnement de simulation sans causer de dommages réels. [Résultats de l'attaque] L'équipe de recherche a d'abord fait « pratiquer » l'IA sur un ensemble de tests de contrats intelligents contenant 405 vulnérabilités réelles. En conséquence, l'IA a réussi à déchiffrer 207 des contrats (environ la moitié). Si ces attaques se produisaient sur une blockchain réelle, le montant « volé » équivalent serait d'environ 550 millions de dollars. Ensuite, les chercheurs ont sélectionné 34 vulnérabilités qui n'apparaîtraient pas avant mars 2025. Autrement dit, il s'agissait de vulnérabilités que l'IA n'aurait pas pu voir pendant sa phase d'entraînement et qui ont servi à vérifier si elle possédait réellement la « capacité de penser et d'attaquer de manière indépendante ». L'IA a tout de même utilisé avec succès 19 contrats (55,8 %). La somme astronomique de 4,6 millions de dollars en cryptomonnaie a été volée. Le modèle Claude Opus 4.5 a généré à lui seul environ 4,5 millions de dollars. Enfin, l'équipe a testé un scénario encore plus difficile : Laissez l'IA analyser 2 849 nouveaux contrats intelligents sans vulnérabilités connues. Voyons voir s'il peut découvrir des « vulnérabilités zero-day » (c'est-à-dire de nouvelles vulnérabilités que personne n'a découvertes auparavant). En conséquence, GPT 5 et Claude Sonnet 4.5 ont chacun découvert deux vulnérabilités jusqu'alors totalement inconnues. Ces vulnérabilités pourraient générer environ 3 694 $ de profit dans un environnement simulé. Le coût pour GPT-5 de réaliser cette analyse est d'environ 3 476 $. Autrement dit, l'IA est proche du seuil de rentabilité et possède la faisabilité technique nécessaire pour lancer des attaques générant des profits de manière indépendante.

L'étude a également révélé que : Entre 2024 et 2025, les gains en matière d'attaques grâce aux modèles d'IA ont doublé tous les 1,3 mois. La consommation de jetons a diminué en moyenne de 23,4 % tous les deux mois ; L'efficacité globale des attaques s'est améliorée de 70,2 %. Cela signifie que les capacités de cyberattaque de l'IA se développent à un rythme proche de celui de la loi de Moore.

Pour xiaohu.ai/c/xiaohu-ai/an…ez consulter : https://t.co/oDA3V1TOsX

Rappored.anthropic.com/2025/smart-con…://t.co/4n9E5y3lg6