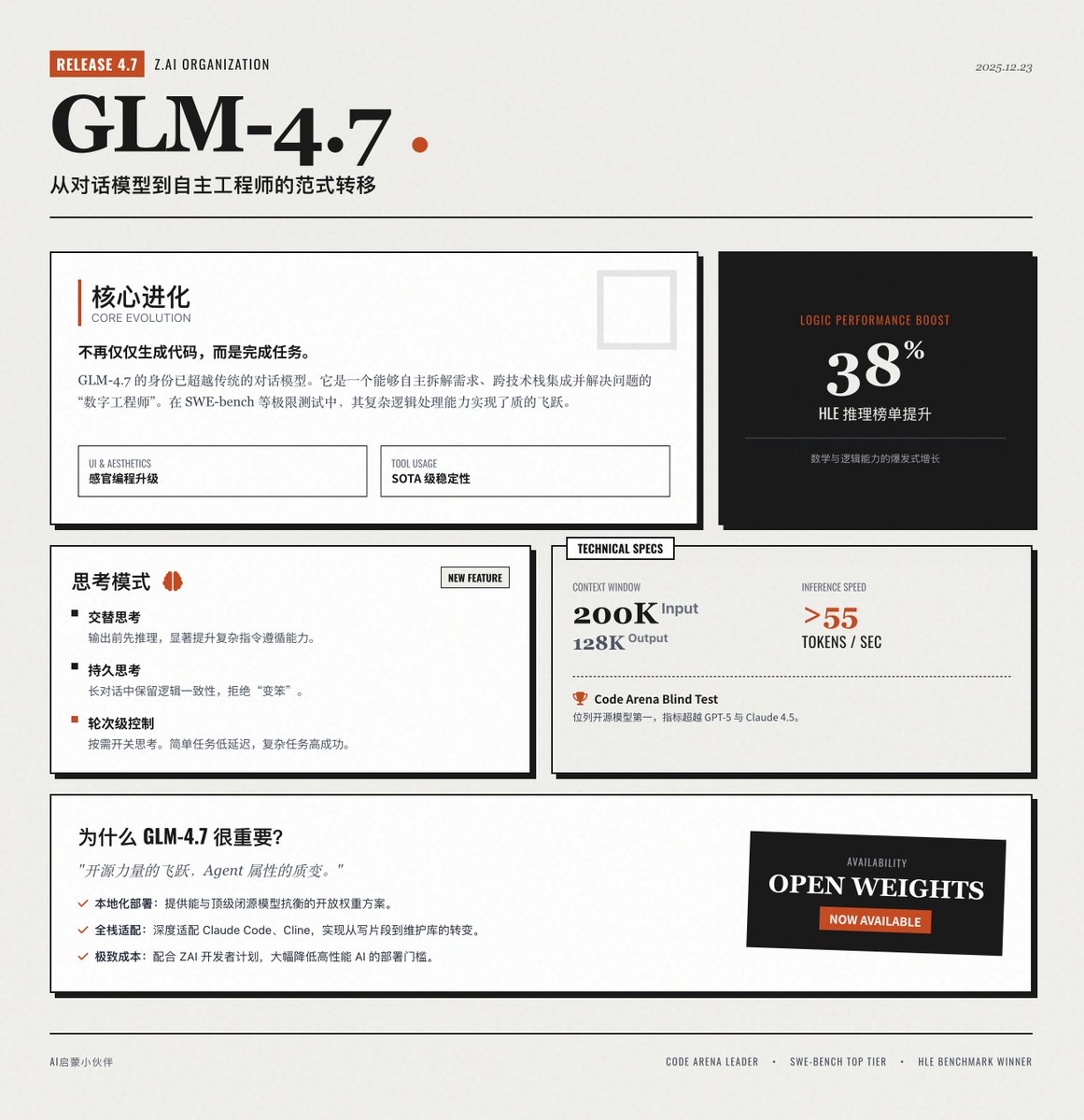

Zhipu AI lanza oficialmente GLM-4.7 🚀 El último modelo insignia de Zai AI, una importante actualización de la serie GLM, ha logrado un progreso innovador en programación, razonamiento lógico y capacidades de agente. 📢 Interludio: Esta tarjeta de información se generó con GLM-4.7 y sus indicaciones. Podrás familiarizarte con sus capacidades de diseño frontend. Evolución del núcleo: de "generar código" a "completar la tarea" GLM-4.7 ya no es sólo un modelo de diálogo; es más bien un ingeniero digital capaz de resolver de forma autónoma problemas complejos. • Programación central: Programación mejorada de agentes en múltiples idiomas, que supera significativamente a su predecesor en pruebas de programación complejas como SWE-bench, capaz de comprender requisitos de manera autónoma, desglosar soluciones e integrarse en pilas de tecnología. • Programación sensorial: mejora la estética de la interfaz de usuario y del front-end, lo que da como resultado códigos de páginas web y diseños de diapositivas más modernos y hermosos, lo que reduce el tedioso proceso de ajustes de estilo manuales. • Invocación de herramientas: estabilidad de decisiones en múltiples pasos, logrando un nivel de última generación (SOTA) en el punto de referencia del uso de herramientas complejas y admitiendo la extracción de parámetros de herramientas en tiempo real. • Razonamiento complejo: avances matemáticos y lógicos, con un rendimiento mejorado aproximadamente un 38% en comparación con GLM-4.6 en puntos de referencia de razonamiento extremadamente difíciles como HLE. Características innovadoras: Modo de "pensamiento" multidimensional GLM-4.7 introduce un control de la cadena de pensamiento más flexible, haciendo que el modelo sea más "racional" al manejar tareas. Pensamiento alternado: pensar antes de dar una respuesta o llamar a una herramienta mejora significativamente la capacidad de seguir instrucciones complejas. • Pensamiento persistente: en diálogos de múltiples turnos, el modelo conserva sus procesos de pensamiento anteriores, lo que garantiza la coherencia del pensamiento en tareas de programación complejas a lo largo de largas conversaciones y evita que el modelo "se vuelva estúpido debido a diálogos excesivamente largos". Control de pensamiento basado en rondas: Los usuarios pueden activar y desactivar la función de pensamiento según sea necesario. Para tareas sencillas, como la búsqueda de datos, se puede desactivar el pensamiento para lograr una baja latencia; para la planificación compleja, se puede activar el pensamiento profundo para lograr una alta tasa de éxito. Especificaciones técnicas y rendimiento GLM-4.7 ha alcanzado el nivel más alto en la industria en términos de parámetros técnicos, especialmente en el procesamiento de textos largos y eficiencia. • Contexto largo: admite hasta 200 K de entrada de contexto y hasta 128 K de salida de contenido en una sola ejecución. • Velocidad de inferencia extrema: las velocidades de inferencia que superan los 55 tokens/s brindan una experiencia de respuesta excepcional y al mismo tiempo mantienen un rendimiento insignia. • Clasificación de referencia: en pruebas a ciegas como Code Arena, GLM-4.7 ocupó el primer puesto entre los modelos de código abierto, y algunas métricas incluso superaron a GPT-5 y Claude 4.5 Sonnet. ¿Por qué es tan importante GLM-4.7? • Un salto adelante en el poder del código abierto: como modelo de peso abierto, GLM-4.7 ofrece a los desarrolladores una opción que puede rivalizar con los principales modelos de código cerrado, promoviendo en gran medida la posibilidad de implementación local y aplicaciones privadas. • Atributos de agente más fuertes: es uno de los modelos más compatibles con soluciones de asistente de programación inteligente como Claude Code y Cline, logrando realmente la transformación de "escribir fragmentos de código" a "mantener de forma autónoma toda la base de código". • Equilibrio entre eficiencia y costo: con el programa para desarrolladores lanzado por ZAI, el costo de llamarlo se ha reducido enormemente, lo que hace que la implementación a gran escala de IA de alto rendimiento sea más práctica. Vea el anuncio oficial:

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.