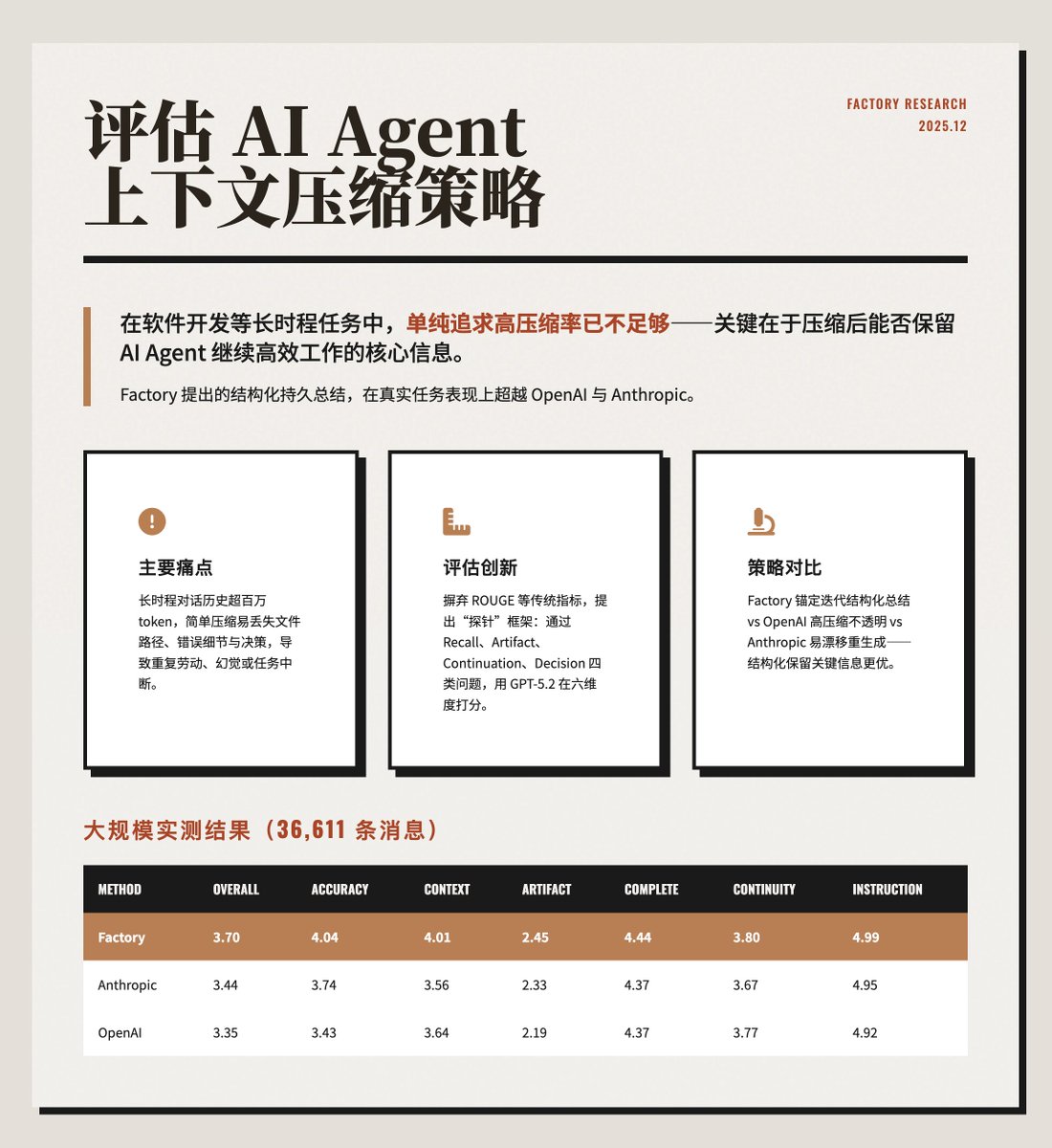

Evaluar la estrategia de compresión de contexto del agente de IA Al abordar tareas que requieren continuidad, como el desarrollo de software, sfactory.ai/news/evaluatin…lta tasa de compresión de contexto no es suficiente. Más importante aún, el proceso de compresión debe retener información crucial para que el agente de IA siga funcionando eficazmente. El método de resumen estructurado propuesto por @FactoryAI supera a OpenAI y Anthropic en tareas prácticas. https://t.co/ZsCDxoVO3Q Problemas principales Cuando los agentes de IA se ejecutan durante periodos prolongados, generan cantidades masivas de historial de diálogo (más de 1 millón de tokens), superando el límite de la ventana de contexto del modelo. Una simple compresión puede perder fácilmente detalles cruciales, como rutas de archivos modificadas, mensajes de error o decisiones previas, lo que provoca que el agente de IA realice tareas repetitivas, experimente alucinaciones o interrupciones en las tareas. El artículo enfatiza que optimizar el consumo de tokens por tarea, en lugar de la reducción de tokens por compresión, es crucial para lograr un funcionamiento eficiente y continuo. El método de evaluación innova con respecto a las métricas tradicionales (como ROUGE o la similitud de incrustación), que solo miden la similitud del texto y no pueden evaluar si el contexto comprimido facilita la continuación de la tarea. Este artículo propone un marco de evaluación basado en sondeos: • Después de la compresión, haga preguntas específicas al agente de IA para probar su retención. • Las sondas se clasifican en cuatro categorías: recuperación, artefacto, continuación y decisión. • Utilice GPT-5.2 como evaluador de LLM y califíquelo en seis dimensiones (de 0 a 5 puntos): precisión, conocimiento del contexto, seguimiento de la pieza de trabajo, integridad, continuidad y cumplimiento de las instrucciones. Comparación de tres estrategias de compresión: Factory: Emplea un resumen iterativo anclado, manteniendo un resumen estructurado y persistente que incluye la intención, las modificaciones del documento, las decisiones y los próximos pasos. El nuevo contenido se fusiona gradualmente, en lugar de regenerarse cada vez. • OpenAI: utiliza la interfaz `/responses/compact`, logrando la tasa de compresión más alta (99,3%), pero su resumen es opaco y a menudo descarta contenido de baja entropía, como rutas de archivos. • Antrópico: genera resúmenes estructurados detallados (incluidos análisis, documentos, tareas, etc.), pero se regenera completamente cada vez que se comprime, lo que puede provocar desviaciones en el resumen. El ejemplo y los resultados lo ilustran con un caso específico de depuración de un error 401: Factory, después de la compresión, recuerda con precisión los detalles del error y la causa raíz, mientras que OpenAI y Anthropic pierden cierta especificidad técnica. Los resultados de una prueba a gran escala con datos de producción reales (36.611 mensajes) se muestran en la imagen a continuación. Factory es líder en precisión y conocimiento del contexto. Si bien OpenAI ofrece la mayor tasa de compresión, presenta la peor calidad, lo que puede generar costos de recuperación adicionales debido a la pérdida de información. Conclusión clave: Estructura por encima de compresión extrema: Los resúmenes segmentados explícitamente preservan mejor la información clave. La relación de compresión no es la única métrica: una compresión alta puede sacrificar la eficiencia de la tarea; el consumo total de tokens es más importante. • El seguimiento de la pieza de trabajo es un desafío: todos los métodos obtienen una puntuación baja en esta dimensión, lo que requiere mecanismos de indexación adicionales. • La evaluación de la sonda es más confiable: refleja la usabilidad real mejor que las métricas de PNL tradicionales.

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.