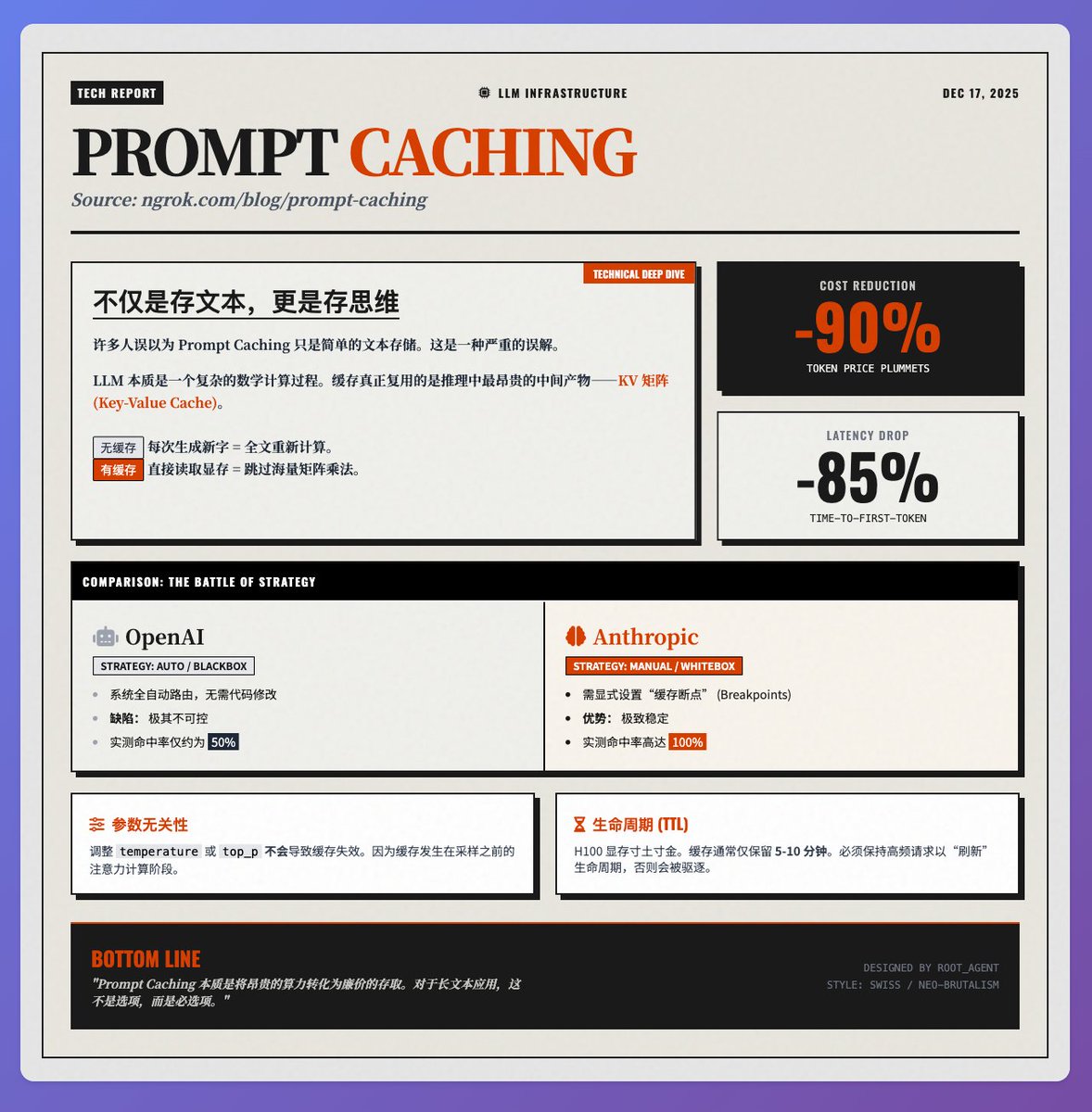

Costes reducidos en un 90%, latencia reducida en un 85%: análisis en profundidad de los principios de la tecnología Prompt Caching En el blog técnico de @samwhoo sobre Prompt Caching en el equipo de @ngrokHQ, Sam revela claramente cómo esta tecnología se ha convertido en una "aplicación revolucionaria" para la reducción de costos y la mejora de la eficiencia en aplicaciones LLM, desde los principios subyacentes hasta las pruebas reales de los proveedores. Principio fundamental: lo que se almacena en caché no es "texto", sino "mentalidad". Mucha gente cree erróneamente que el almacenamiento en caché de indicaciones simplemente almacena el texto de entrada. En realidad, reutiliza el producto intermedio más costoso del proceso de inferencia del modelo: las matrices K (Clave) y V (Valor) (es decir, la caché KV). Al procesar cada token, LLM necesita calcular su relación con el contexto a través de un mecanismo de atención. • Sin almacenamiento en caché: para cada nuevo carácter generado, el modelo tiene que volver a calcular la matriz K/V de todo el texto, lo que genera un enorme desperdicio de potencia informática. • Con almacenamiento en caché: lee la matriz calculada previamente directamente desde la memoria de vídeo, omitiendo la engorrosa multiplicación de matrices. Por eso ofrece un doble beneficio: ahorra alrededor del 90% de las tarifas de tokens y reduce la latencia de la primera palabra en escenarios de texto largo en un 85%. Pruebas de proveedores: las diferencias entre OpenAI y las estrategias antrópicas En las implementaciones reales, las estrategias de estos dos proveedores principales son drásticamente diferentes y afectan directamente la estabilidad del sistema: 1. OpenAI (Caja negra totalmente automatizada): El sistema intenta enrutar automáticamente las solicitudes para que coincidan con la caché, sin necesidad de modificaciones de código por parte de los desarrolladores. Sin embargo, esto conlleva la imprevisibilidad: en pruebas reales, la tasa de aciertos de la caché fue inestable, rondando el 50 %. 2. Antrópico (caja blanca manual): Los desarrolladores pueden establecer explícitamente "puntos de interrupción en caché". Si bien esto aumenta el umbral de desarrollo, con una configuración adecuada, la tasa de éxito alcanza el 100 % en pruebas reales. Para entornos de producción que exigen una estabilidad extrema, Anthropic actualmente ofrece un rendimiento aún mejor. Detalles técnicos que los desarrolladores deben tener en cuenta: Independencia de parámetros: Ajustar parámetros de muestreo como la temperatura o top_p no invalidará la caché. Esto se debe a que el almacenamiento en caché se realiza durante la fase de cálculo de atención, antes del muestreo, lo que proporciona una gran flexibilidad para la depuración de aplicaciones. • Duración: Debido al alto costo de la memoria H100, la caché generalmente solo se conserva de 5 a 10 minutos. Para reutilizarla durante un tiempo prolongado, se requiere una alta frecuencia de solicitudes para refrescar su vida útil. Resumir La esencia del almacenamiento en caché de indicaciones es transformar recursos informáticos costosos en una recuperación de almacenamiento relativamente económica. Para aplicaciones RAG, análisis de documentos extensos o diálogos multiturno, esta tecnología es clave y no solo ahorra dinero, sino que también mejora significativamente la experiencia del usuario. Texto original de referencia

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.