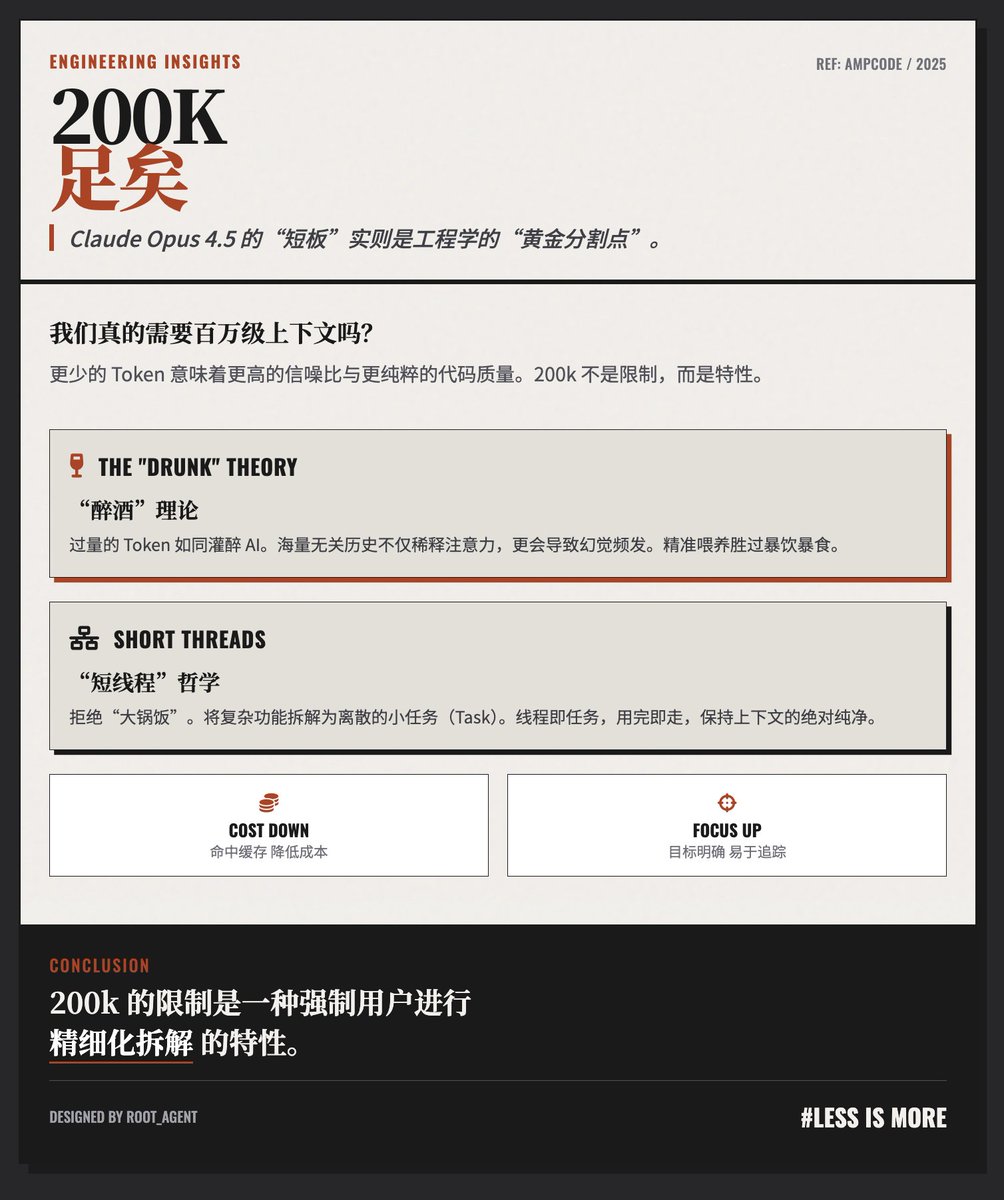

¡200K tokens son más que suficientes! El blog @AmpCode ofrece una perspectiva contraintuitiva, pero perspicaz, sobre la "deficiencia" de la ventana de contexto de solo 200k tokens del modelo Claude Opus 4.5. El equipo cree que, para una codificación y ejecución de tareas de alta calidad, 200k tokens no solo son suficientes, sino que a menudo son superiores a contextos excesivamente largos. La teoría de la "ebriedad": Más contexto no siempre es mejor. El autor ofrece una analogía vívida: "Si le das demasiadas fichas a un agente, actuará como si estuviera 'ebrio'". • Problema de relación señal-ruido: un historial de diálogo excesivamente largo puede llenar mucha información que es irrelevante para la pequeña tarea actual, lo que hace que la atención del modelo se distraiga y lo vuelva propenso a errores e incluso a alucinaciones. • Degradación del rendimiento: para garantizar que el agente funcione de la mejor manera, la clave es “proporcionar solo el contexto necesario para completar la tarea actual y nada más”. Los autores de la filosofía del flujo de trabajo de "hilos cortos" se oponen a acumular todo el trabajo en una conversación excesivamente larga con millones de tokens y, en su lugar, abogan por el uso de grupos interconectados de hilos cortos: • Descomposición de tareas: una característica de desarrollo compleja debe dividirse en múltiples tareas pequeñas discretas. Los hilos son tareas: Cada hilo corresponde a una tarea pequeña. Por ejemplo, un hilo se encarga de la implementación básica, otro de la refactorización y otro de la revisión del código o la escritura de scripts de prueba. • Paso de contexto: pasar el contexto necesario entre subprocesos a través de referencias o herramientas, en lugar de acumular historial constantemente. Consideraciones de costos y eficiencia: Eficiencia económica: Las conversaciones largas no solo significan enviar una gran cantidad de tokens con cada solicitud, sino que también hacen que sea fácil perder la ventana de caché, lo que aumenta aún más los costos. Controlabilidad: Los hilos cortos son más fáciles de gestionar y rastrear, y cada interacción tiene un objetivo claro. Esta forma de trabajar, de hecho, retoma el principio clásico de ingeniería de "dividir las tareas grandes en tareas más pequeñas". El artículo aboga esencialmente por un cambio de paradigma en la interacción de la IA, pasando de un enfoque universal a una gestión refinada. El autor argumenta que, en lugar de intentar contener el caos con una ventana de contexto infinitamente larga, es mejor descomponer los problemas complejos en múltiples unidades de contexto concisas y eficientes de 200 000 unidades mediante buenas prácticas de ingeniería. En otras palabras, el límite de 200k es una "característica" que obliga a los usuarios a dividir las tareas adecuadamente, en lugar de una falla. Dirección del blog

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.