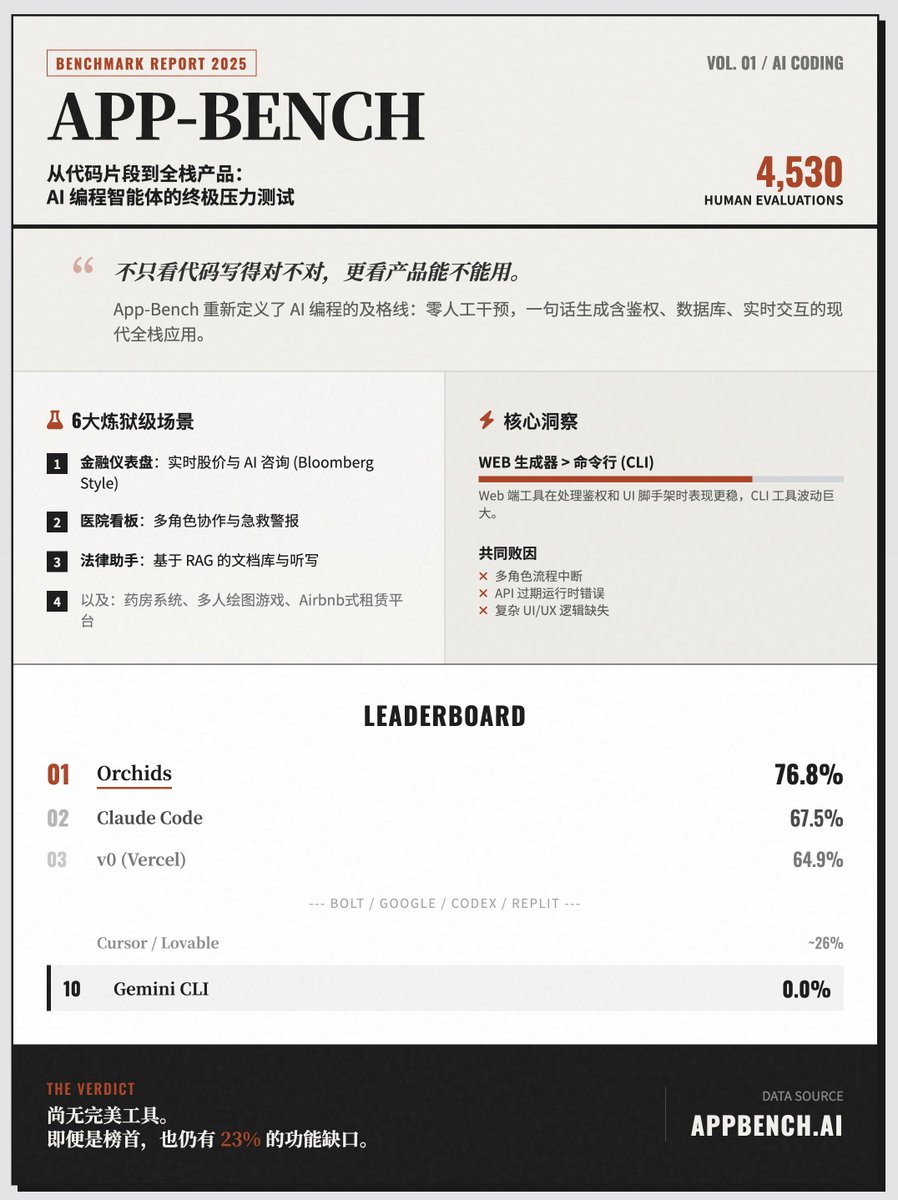

La prueba definitiva de la "generación de un solo clic" de aplicaciones full-stack de IA, "App-Bench", clasifica a Orchids en primer lugar, a Claude Code en segundo, a Cursor en octavo, a Lovable en noveno y a Gemini CLI en cero. App-Bench es un sofisticado marco de evaluación comparativa con un objetivo central muy claro: evaluar si un agente de programación de IA tiene la capacidad de generar una aplicación web moderna, completa y utilizable a partir de una única indicación en lenguaje natural sin ninguna intervención humana. Principios básicos de evaluación: de la escritura de código a la creación de productos App-Bench ya no solo evalúa la capacidad de una IA para escribir fragmentos de funciones, sino que examina su capacidad general para crear aplicaciones completas. Estas aplicaciones deben contener las características principales del software real: • Asistente de IA integrado • Sincronización de datos en tiempo real • Lógica de roles multiusuario • Activadores automatizados y procesos de autenticación Para simular el valor económico real, App-Bench seleccionó seis aplicaciones complejas de diferentes campos para realizar pruebas, empleando seis escenarios de prueba desafiantes: • Panel financiero: similar a la Terminal Bloomberg, incluye precios de acciones en tiempo real, gráficos interactivos, análisis impulsado por IA y foros en vivo. • Panel de gestión del hospital: involucra múltiples roles, incluidos médicos, enfermeras y administradores, y requiere el manejo del estado de las camas, las alarmas de emergencia y la comunicación en tiempo real. • Asistente Legal: Una biblioteca de documentos basada en RAG, que admite la transcripción de voz y la citación de documentos. • Sistema de Farmacia: Conecta pacientes y farmacéuticos, manejando inventario, pedidos y mensajes privados. • Juego Pictionary: un juego multijugador en línea que requiere soluciones de lógica por turnos, sincronización de lienzo en tiempo real y funcionalidad de repetición. Plataforma de reserva de alquileres: similar a Airbnb, incluye filtrado de búsqueda, proceso de pago y carga de medios. Método de puntuación riguroso: las puntuaciones las otorgan manualmente los desarrolladores full-stack senior, no las otorgan máquinas automatizadas. • Escala: Abarca 151 ítems de puntuación, con un total de 4.530 evaluaciones realizadas. • Mecanismo: A cada herramienta se le dan tres oportunidades y se registra el mejor resultado. Hallazgos y perspectivas clave: Situación actual del sector: Ni siquiera las herramientas de gama alta pueden lograr resultados perfectos. Las herramientas con mejor rendimiento actualmente solo cubren alrededor del 77 % de las funciones esenciales, y la mayoría presenta deficiencias significativas en la gestión de tareas complejas (como interacciones multirrol y lógica de interfaz de usuario compleja). Comparación de tipos de herramientas: Los generadores web generalmente superan a las herramientas de línea de comandos. Las herramientas web son más estables en el manejo de la autenticación y los marcos de interfaz de usuario básicos, mientras que las herramientas CLI presentan mayores fluctuaciones de rendimiento. • Principales causas de falla: características faltantes, interrupción de procesos multi-rol, errores de tiempo de ejecución causados por API vencidas y problemas de UI/UX que afectan la usabilidad. Clasificación de rendimiento (Top 10) 1. Orquídeas 76,8% 2. Claude Code 67,5% 3. v0 (Vercel) 64,9% 4. Bolt 53,6% 5. Google AI Studio 50,3% 6. Códice 38,4% 7. Replit 35,1% 8. Cursor 27,8% 9. Adorable 25,8% 10. Géminis CLI 0.0% Visita el sitio web

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.