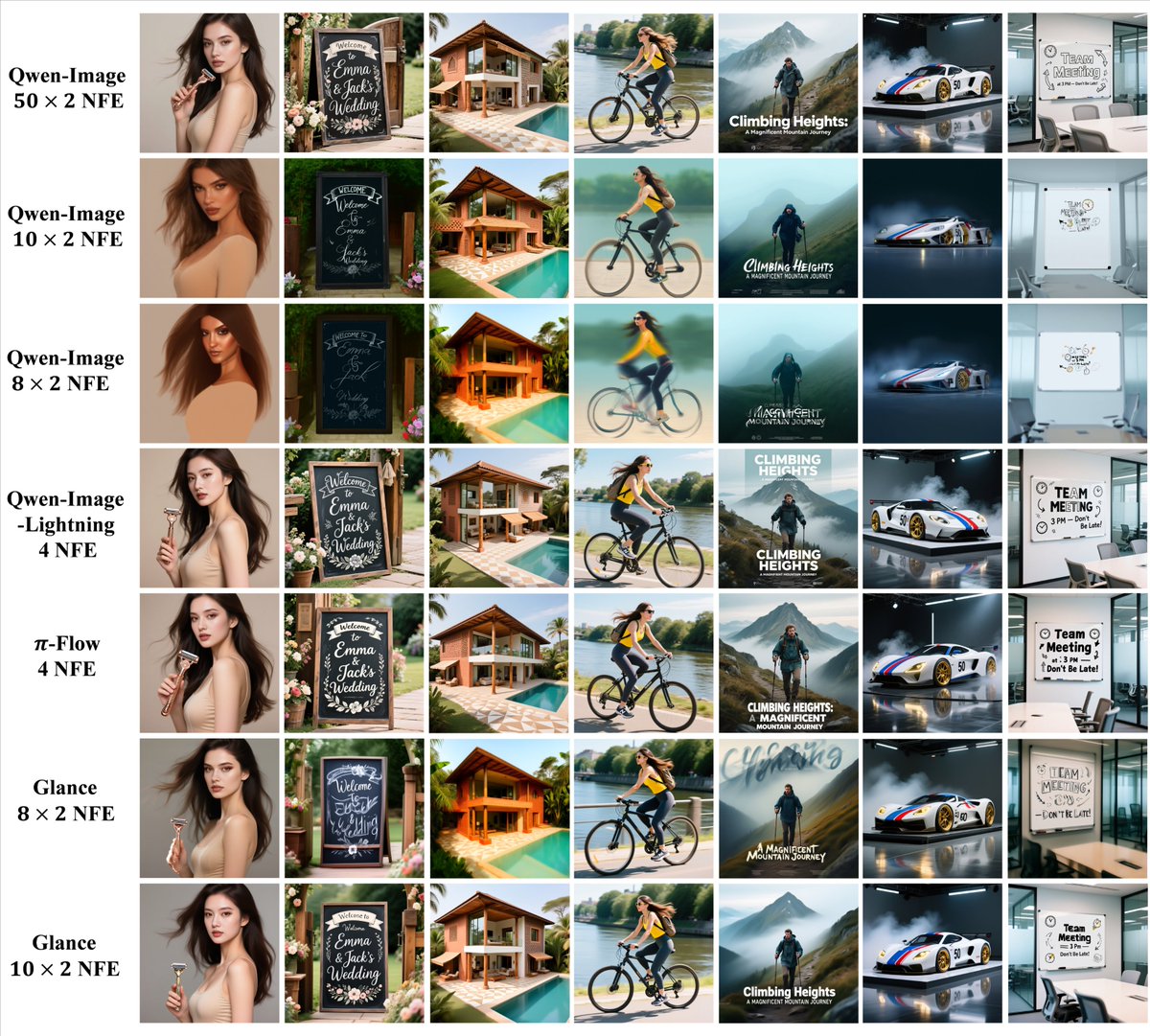

Este proyecto es interesante. Glance es un método de aceleración basado en etapas que puede acelerar significativamente la inferencia de modelos de difusión (hasta 5 veces) con muy pocos datos (una muestra) y un coste de entrenamiento muy bajo mediante "expertos LoRA de dos etapas", manteniendo prácticamente la calidad de la generación. Puedes pensar en los modelos de mapeo de difusión actuales (como Difusión Estable) de la siguiente manera: "Empieza con ruido puro, límpialo lentamente y borra gradualmente la pintura". El caso es: Para crear una buena imagen, normalmente hay que borrarla decenas o incluso cientos de veces, ejecutando un modelo grande cada vez. Esto consume mucho tiempo y consume mucha tarjeta gráfica, por lo que mucha gente piensa: «La calidad generada es muy buena, pero demasiado lenta». Las estrategias de aceleración anteriores implicaban principalmente: Reentrenar a un "modelo de estudiante" para que aprenda a dibujar en menos pasos requiere una gran cantidad de datos de entrenamiento y potencia computacional, y también es propenso a la "fuga de cerebros" (generalización deficiente). Glance adoptó un enfoque diferente: En lugar de comprimir todos los pasos de manera uniforme, observamos: Los pasos iniciales son cruciales para definir la estructura y el contenido general. Los pasos posteriores se centran más en refinar los detalles y eliminar las pequeñas distracciones; gran parte de esto es redundante. Así que implementaron un enfoque de "aceleración gradual": Agregue dos complementos LoRA livianos al modelo: Slow-LoRA: Utilizado en la primera mitad, permite un enfoque "lento y constante", minimizando los saltos y garantizando que la composición y la semántica permanezcan intactas. Fast-LoRA: se utiliza en la segunda mitad del juego, ahorra tiempo y permite realizar saltos audaces para reducir los cálculos. Estos dos algoritmos LoRA se pueden entrenar en una sola imagen V100 usando solo una imagen de muestra en aproximadamente una hora, lo que hace que el costo de entrenamiento sea insignificante. apagar: En comparación con el modelo original, la velocidad de inferencia se puede aumentar hasta cinco veces, pero la calidad de los gráficos generados en varios conjuntos de pruebas es básicamente la misma que la del modelo original, sin una disminución evidente.

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.