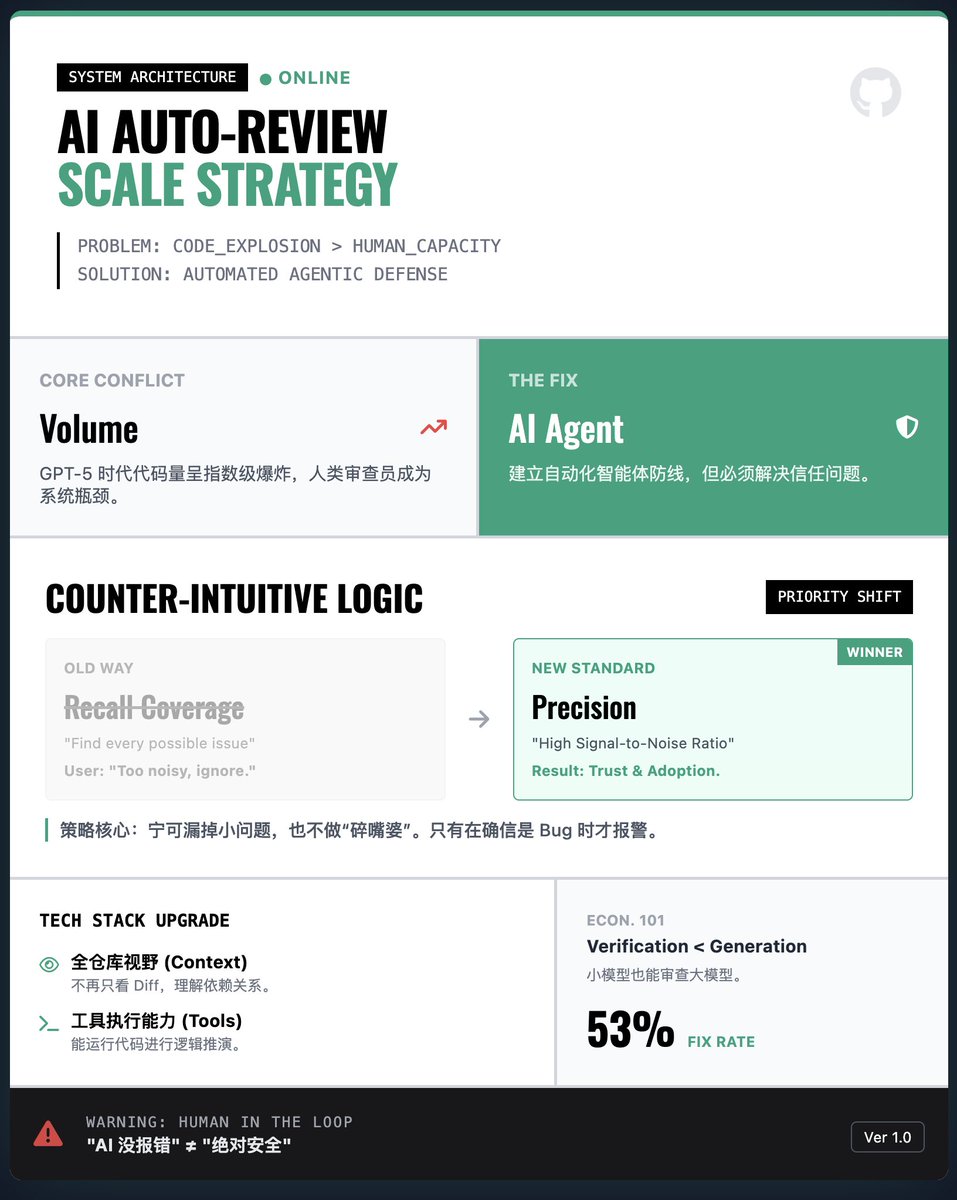

¿Cómo construye OpenAI un sistema de revisión de código automatizado por IA a gran escala? Desafíos principales: Explosivo volumen de código vs. cuellos de botella en recursos humanos. Con el crecimiento exponencial del código generado por IA (como GPT-5-Codex), los humanos no pueden revisarlo línea por línea. Confiar únicamente en la generación de IA sin verificación dificultará el control de vulnerabilidades y errores. Por lo tanto, OpenAI propone establecer un agente de revisión de código automatizado como línea de defensa. Estrategia clave: Precisión antes que cobertura (¡contrario a la intuición!) • La lógica habitual es: esperaríamos que la IA encontrara todos los problemas potenciales. • Descubrimientos de OpenAI: En la ingeniería del mundo real, si la IA informa muchos problemas triviales o irrelevantes como un "parlanchín", los desarrolladores simplemente abandonarán la herramienta. Solución: Para ganar la confianza de los desarrolladores, el sistema fue diseñado para priorizar "calidad sobre cantidad", priorizando una alta relación señal-ruido y emitiendo alertas solo cuando es seguro que un error es crítico, incluso a costa de pasar por alto algunos problemas menores. Avance tecnológico: contexto de repositorio completo y uso de herramientas • Los primeros modelos de validación generalmente solo miraban las diferencias de código y carecían de contexto. El nuevo agente de revisión tiene una vista completa de todo el repositorio y la capacidad de ejecutar código. Esto significa que no solo ve el código, sino que también puede realizar deducciones lógicas basadas en las dependencias de todo el proyecto, mejorando así significativamente la precisión de la revisión. Perspectiva económica: La validación es más económica que la generación. El artículo hace una observación interesante: generar código correcto requiere muchos recursos informáticos, pero validarlo suele requerir muy pocos. Incluso con un presupuesto computacional relativamente bajo, los agentes de censura pueden capturar eficazmente la mayoría de los errores generados por modelos potentes. Esto proporciona una base económica para una implementación a gran escala. Aplicaciones prácticas y advertencias: Resultados reales: Este sistema se ha utilizado ampliamente en OpenAI y en GitHub. Los datos muestran que aproximadamente el 53 % de los comentarios de las revisiones de IA fueron adoptados por los desarrolladores y utilizados para modificar su código, lo que demuestra el gran valor de sus sugerencias. • Riesgo de dependencia excesiva: La revisión de la IA es solo una "asistencia", no un "reemplazo". Los equipos deben evitar la complacencia de equiparar "que la IA no reporte ningún error" con "seguridad absoluta". Informe de lectura

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.