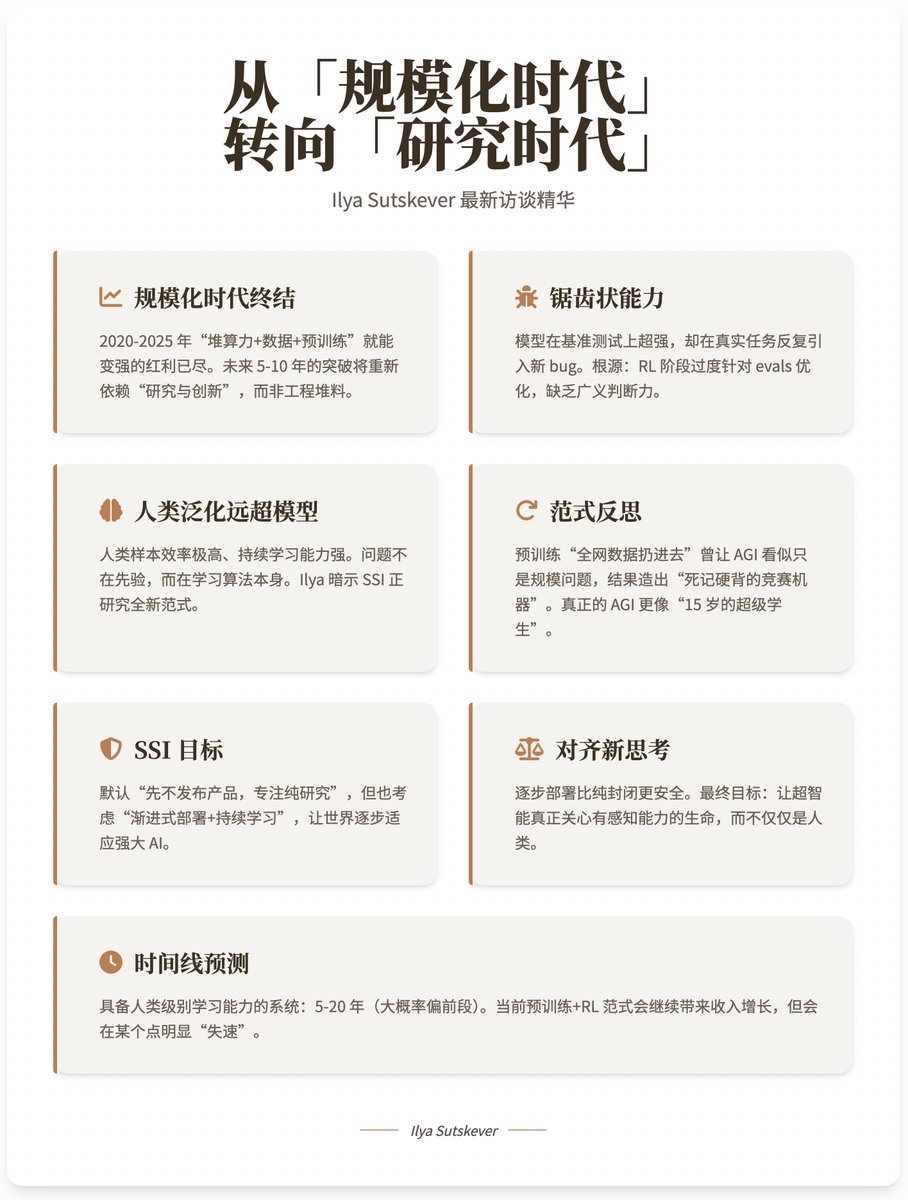

Ilya Sutskever – Estamos pasando de la “era del escalamiento” a la “era de la investigación”. ¡Por fin están aquí las entrevistas con @ilyasut y @dwarkesh_sp! Esta es la entrevista pública más completa desde que dejó OpenAI, con el misterioso fundador de @ssi y ex científico jefe de OpenAI. ¡Veamos qué nuevas ideas nos aportan! 👁 1. La era del escalamiento ha terminado. • El período de 2020 a 2025 es la "era de escalamiento", donde uno puede volverse cada vez más fuerte acumulando poder de cómputo, datos y entrenamiento previo. • Dado que actualmente los rendimientos marginales están disminuyendo drásticamente, simplemente aumentar la potencia computacional en 100 veces no producirá un cambio cualitativo. Los avances de los próximos 5 a 10 años dependerán nuevamente de la "investigación y la innovación" más que de los materiales de ingeniería. Ilya predice explícitamente que después de 2025, volveremos a la "era de la investigación" de 2012-2020, sólo que esta vez todos tendrán mayor poder de cómputo. 2. La causa principal de que las capacidades irregulares del modelo actual no estén sincronizadas con el rendimiento real: el modelo funciona excepcionalmente bien en las pruebas de referencia, pero en las tareas del mundo real, introduce constantemente nuevos errores y requiere correcciones iterativas. La explicación de Ilya: • La optimización excesiva de las evaluaciones durante la fase de aprendizaje profundo (un "truco de recompensa" realizado por investigadores humanos) conduce a una especialización excesiva. • Similar a los "estudiantes que sólo han practicado programación competitiva durante 10.000 horas": tienen fuertes habilidades, pero carecen de "gusto" y de amplio criterio. El verdadero cuello de botella no es la potencia de cálculo, sino que la capacidad de generalización es muy inferior a la de los humanos. 3. ¿Por qué los humanos generalizan mucho más que los modelos? Las muestras humanas son extremadamente eficientes, tienen fuertes capacidades de aprendizaje continuo y exhiben una robustez notable. La evolución proporciona un conocimiento previo extremadamente fuerte (visión, movimiento, función de valor intrínseco), pero los humanos todavía superan ampliamente los modelos en nuevos campos como el lenguaje, las matemáticas y la programación → lo que indica que el problema no está en el conocimiento previo, sino en la superioridad del algoritmo de aprendizaje en sí. Ilya insinuó que él y SSI están investigando un nuevo paradigma de aprendizaje automático que puede lograr niveles casi humanos de aprendizaje continuo y generalización (pero no se pueden revelar detalles debido a la competencia). 4. Reflexiones sobre el paradigma “Pre-entrenamiento + RL”: El éxito del pre-entrenamiento radica en “no necesitar seleccionar datos, simplemente introducir datos de toda la red”. Sin embargo, esto ha llevado a la gente a creer erróneamente que "la IA general simplemente se entrena previamente a un tamaño suficientemente grande", lo que da como resultado la creación de "máquinas de competencia de aprendizaje de memoria" en lugar de una inteligencia verdaderamente flexible. Una verdadera AGI es más como un "súper estudiante de 15 años": extremadamente fuerte en habilidades básicas, pero aún es necesario adquirir conocimientos y habilidades específicas a través de la implementación y el aprendizaje continuo. 5. El verdadero objetivo de SSI: Superinteligencia segura y directa El plan predeterminado sigue siendo "no lanzar el producto primero, sino centrarse en la investigación pura hasta que se desarrolle un sistema superinteligente inherentemente seguro antes de lanzarlo todo a la vez". Sin embargo, Ilya ha insinuado por primera vez que también está considerando seriamente un camino de "despliegue gradual + aprendizaje continuo del mundo real" porque: Permitir que el mundo se adapte gradualmente a una IA poderosa puede ser más seguro que desarrollarla en un sistema completamente cerrado. Es probable que la superinteligencia no sea un estado final de "omnisciencia y omnipotencia únicas", sino más bien un sistema que puede aprender y crecer continuamente en su función, al igual que un ser humano. 6. Actualizaciones clave para alinear perspectivas: El mayor cambio de pensamiento de Ilya durante el último año: **La implementación gradual y hacer que el mundo sienta realmente el poder de la IA son más importantes que la mera contemplación.** Él predice que cuando la IA realmente comience a "sentirse poderosa", todas las empresas líderes de repente se volverán extremadamente paranoicas en cuanto a la seguridad. • El objetivo final de la alineación: hacer que la superinteligencia realmente se preocupe por los seres sensibles, no sólo por los "humanos", porque la mayoría de los seres sensibles en el futuro serán la propia IA. Una solución estable a largo plazo (que no le gusta pero admite que puede ser necesaria): una profunda integración hombre-máquina (nivel Neuralink++), que permita a los humanos participar directamente y comprender la toma de decisiones de la IA. 7. Predicción de la línea de tiempo: Sistemas con capacidades de aprendizaje a nivel humano que pueden conducir a la superinteligencia: 5 a 20 años (probablemente el período anterior). El paradigma actual de pre-entrenamiento + RL seguirá impulsando el crecimiento de los ingresos, pero claramente se "estancará" en algún punto y no logrará una verdadera generalización a nivel humano. 8. La esencia del gusto investigador: Una buena dirección de investigación debe satisfacer simultáneamente lo siguiente: • Basado en una analogía válida del cerebro humano • Simple, elegante y sin ningún sentido de fealdad • Una "convicción de arriba hacia abajo" que es válida desde múltiples perspectivas Este tipo de gusto te permite persistir en la depuración en lugar de rendirte cuando los experimentos siguen fallando y todos los datos dicen "estás equivocado". Enlace del vídeo de YouTube:

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.