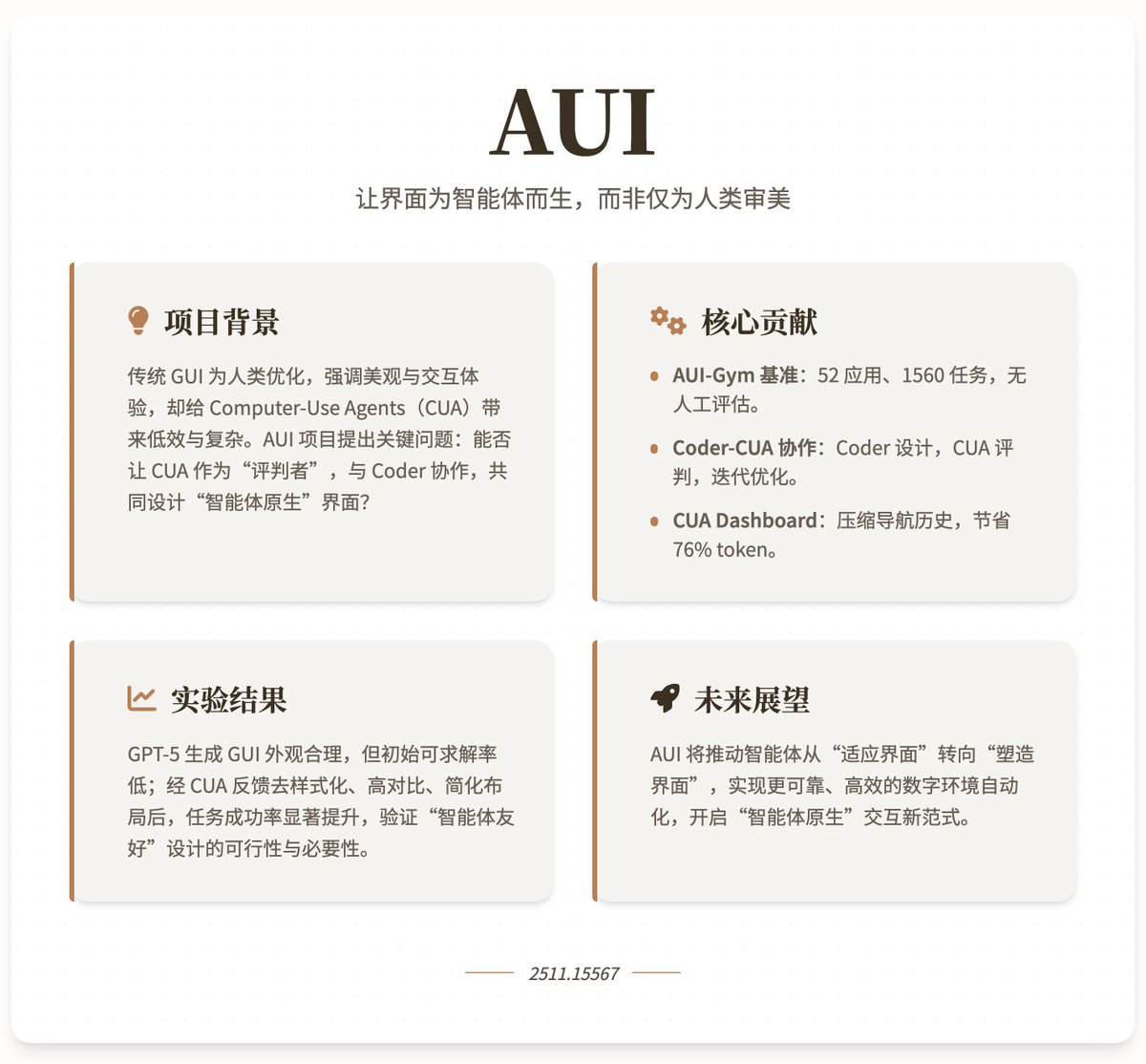

Con Gemini 3.0 Pro y Claude Opus 4.5 continuando mejorando sus capacidades de generación de UI, ¿hay futuro para los desarrolladores front-end? 😂 Es broma 😄 Los modelos de IA son tan buenos generando interfaces de usuario que son muy fáciles de usar, pero ¿las interfaces de usuario que generan son fáciles de usar para los agentes de IA? La última investigación, "AUI", de la Universidad de Oxford, la Universidad Nacional de Singapur y Microsoft, explora cómo utilizar agentes de uso de computadora (CUA) y modelos de lenguaje de codificación para generar y optimizar automáticamente las GUI, haciendo que la interfaz sea más adecuada para agentes inteligentes que para humanos. Antecedentes y motivación del proyecto: Las GUI tradicionales están optimizadas principalmente para humanos, priorizando la estética, la usabilidad y el atractivo visual (como animaciones y diseños coloridos). Esto obliga a las CUA a imitar el comportamiento humano durante su funcionamiento, lo que aumenta la complejidad y la ineficiencia. Con los avances en los modelos de lenguajes de programación para la generación automática de sitios web funcionales, el proyecto AUI plantea una pregunta clave: ¿Pueden las CUA actuar como "jueces" para ayudar a los programadores a diseñar GUI automáticamente? Esta colaboración busca crear interfaces nativas de agente, priorizando la eficiencia de las tareas sobre la estética. A través de la retroalimentación de los agentes, el proyecto espera lograr una automatización más fiable y eficiente de los entornos digitales, impulsando una transición en los agentes de una adaptación pasiva a una configuración activa de sus entornos. Contribuciones fundamentales 1. Plataforma de referencia AUI-Gym: Esta plataforma de referencia está diseñada específicamente para el desarrollo y las pruebas automatizadas de GUI, y abarca 52 aplicaciones en 6 dominios (App, Landing, Game, Interactive, Tool y Utility). El proyecto utiliza GPT-5 para generar 1560 tareas que simulan escenarios reales (30 por aplicación) y garantiza la calidad mediante verificación humana. Estas tareas priorizan la integridad funcional y la interactividad, como la creación de hábitos y la visualización de gráficos en la aplicación "Micro Habit Tracker". Cada tarea cuenta con un validador basado en reglas que, mediante JavaScript, verifica si la tarea es ejecutable en una interfaz determinada, lo que permite una evaluación fiable sin intervención humana. Las métricas de referencia incluyen: • Completitud de funciones (FC): evalúa si la interfaz admite la tarea (es decir, si existe un verificador de funciones), como una medida básica de usabilidad. • Tasa de éxito de CUA (SR): evalúa la tasa de finalización promedio de CUA durante las tareas de navegación, lo que refleja la eficiencia de ejecución real. 2. Marco de colaboración entre el codificador y la CUA: Este marco posiciona al codificador (modelo de lenguaje de programación) como el "diseñador", responsable de inicializar y revisar iterativamente la interfaz gráfica de usuario (GUI); la CUA actúa como el "juez", proporcionando orientación mediante la resolución de tareas y retroalimentación sobre la navegación. Flujo de trabajo específico: El codificador genera un sitio web HTML inicial a partir de las consultas del usuario (incluido nombre, objetivo, función y tema). • Sitio web de prueba de CUA: primero, verifique la capacidad de solución de la tarea (recopile tareas inviables como retroalimentación funcional) y luego realice la navegación (a través de acciones atómicas como clics y entradas). • Bucle de retroalimentación: las tareas sin solución se resumen en un resumen de lenguaje para que los codificadores mejoren la funcionalidad; las trayectorias de navegación se comprimen en retroalimentación visual a través del Tablero CUA para ayudar a los codificadores a optimizar el diseño. 3. Panel de CUA: Se utiliza para condensar el historial de navegación de varios pasos de CUA (incluyendo capturas de pantalla, acciones y resultados) en una sola imagen de 1920×1080. Al recortar de forma adaptativa las áreas clave de interacción, reduce los tokens visuales en un promedio del 76,2 %, conservando las claves necesarias (como los objetivos de la tarea, los pasos y los puntos de error). Esto facilita la interpretación de los comentarios, lo que permite a los programadores identificar problemas (como bajo contraste o diseños complejos) y realizar revisiones específicas, como eliminar estilos, aumentar el contraste o simplificar la estructura. Los resultados experimentales muestran que los programadores avanzados (como GPT-5) pueden generar interfaces gráficas de usuario visualmente atractivas, pero su integridad funcional inicial es baja (muchas tareas son irresolubles). Esto se puede mejorar rápidamente mediante la retroalimentación de fallos. La navegación CUA es el principal obstáculo; incluso con funcionalidad completa, la tasa de éxito inicial es baja. Sin embargo, mediante la iteración colaborativa (como la desestilización, el alto contraste y la simplificación del diseño), la tasa de éxito mejora significativamente, lo que demuestra que la retroalimentación del agente mejora la robustez y la eficiencia de la interfaz gráfica de usuario. El proyecto enfatiza que los agentes prefieren interfaces simples y orientadas a la función en lugar de una complejidad visual similar a la humana. Dirección del proyecto de investigación

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.