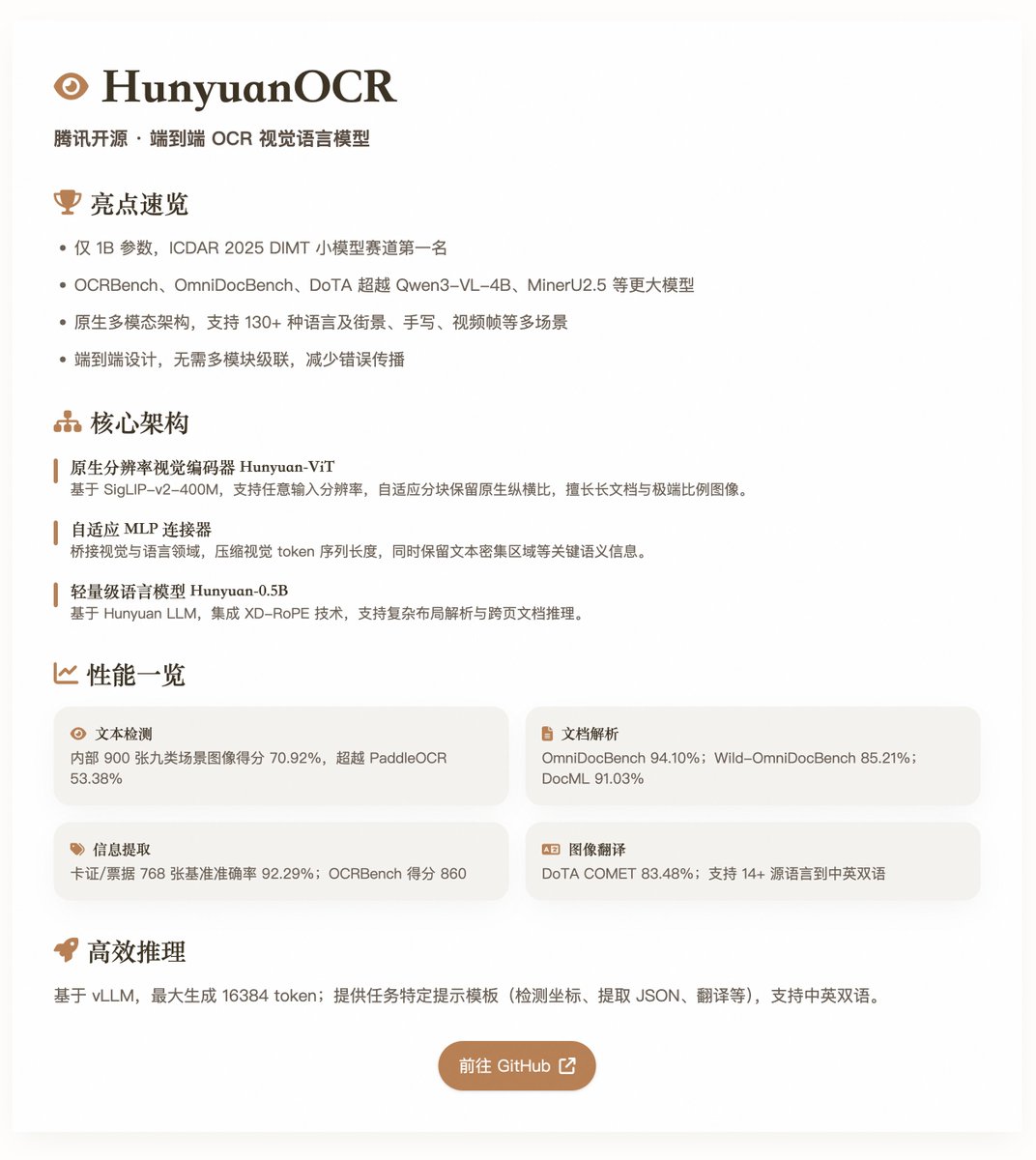

HunyuanOCR: el modelo de lenguaje visual de OCR de extremo a extremo de código abierto de Tencent HunyuanOCR, con un tamaño de parámetro de tan solo 1B, ha logrado un rendimiento líder en múltiples pruebas de referencia de OCR. Basado en una arquitectura multimodal nativa, está optimizado para tareas de OCR y es adecuado para escenarios como detección de texto, análisis de documentos, extracción de información, respuesta visual a preguntas y traducción de texto a imagen. El modelo obtuvo el primer puesto en el Desafío ICDAR 2025 DIMT (sección de modelos pequeños) y superó a muchos modelos de mayor escala, como Qwen3-VL-4B y MinerU2.5, en pruebas de referencia como OCRbench, OmniDocBench y DoTA. Características principales y arquitectura HunyuanOCR emplea un diseño de modelo de lenguaje visual integral, evitando la cascada de múltiples módulos de los sistemas OCR tradicionales, lo que reduce la propagación de errores y los costos de mantenimiento. Su arquitectura consta de tres componentes principales: • Codificador visual de resolución nativa (Hunyuan-ViT): Basado en el modelo preentrenado SigLIP-v2-400M con aproximadamente 0.400 millones de parámetros, admite resoluciones de entrada arbitrarias. Conserva la relación de aspecto original de las imágenes mediante un mecanismo de división de bloques adaptativo y es excelente para procesar documentos extensos, imágenes con relaciones de aspecto extremas y documentos escaneados de baja calidad. • Conector MLP adaptativo: actúa como puente entre los dominios de la visión y el lenguaje, realiza una compresión de contenido espacial, reduce la longitud de las secuencias de tokens visuales y preserva información semántica clave, como regiones de texto denso. • Modelo de lenguaje ligero (Hunyuan-0.5B): basado en Hunyuan LLM, con aproximadamente 0.5B parámetros, integra tecnología XD-RoPE, descomponiendo RoPE en cuatro subespacios: texto, altura, ancho y tiempo, y admitiendo análisis de diseño complejo y razonamiento de documentos entre páginas. El modelo admite el modelado unificado en múltiples tareas, completando tareas desde la percepción hasta la semántica mediante instrucciones en lenguaje natural (como "detectar y reconocer texto en una imagen") sin necesidad de módulos de preprocesamiento adicionales. Abarca múltiples idiomas (más de 130, incluyendo idiomas de bajos recursos) y múltiples escenarios (como street view, escritura a mano y fotogramas de vídeo), y prioriza el uso de datos de alta calidad alineados con la aplicación y la optimización del aprendizaje por refuerzo (RL) durante el entrenamiento para mejorar la robustez en escenarios complejos. Capacitación y construcción de datos (2 minutos) Fase de preentrenamiento: Esta fase consta de cuatro pasos, con un total aproximado de 454 000 millones de tokens. Incluye la alineación visual-lingüística, el preentrenamiento multimodal, la expansión de contextos extensos (hasta 32 000 tokens) y el ajuste fino supervisado orientado a la aplicación. Los datos combinan conjuntos de datos de código abierto, datos sintéticos a nivel de elemento y datos de aplicaciones integrales, totalizando aproximadamente 200 millones de muestras de alta calidad que abarcan nueve escenarios, incluyendo Street View, documentos y escritura a mano. Fase posterior al entrenamiento: Se utiliza el algoritmo de aprendizaje por refuerzo en línea GRPO, combinado con mecanismos de recompensa específicos para cada tarea (como el basado en reglas y el LLM como juez). Esto mejora significativamente la precisión y la estabilidad del modelo en tareas complejas como el análisis y la traducción de documentos. El flujo de datos enfatiza la composición y la mejora: extiende el marco SynthDog para generar documentos largos y multilingües, compatible con diseños RTL y fuentes complejas; introduce un flujo de composición de distorsión para simular defectos del mundo real (como desenfoque, distorsión y cambios de iluminación); y un flujo de generación de control de calidad automatizado que reutiliza muestras de tareas cruzadas para garantizar la diversidad y la calidad. Evaluación del rendimiento: detección de texto (Spotting): puntuación del 70,92 % en un punto de referencia interno de 900 imágenes (nueve categorías de escenas), superando a PaddleOCR (53,38 %) y Qwen3-VL-235B (53,62 %). • Análisis de documentos: Puntuación general del 94,10 % en OmniDocBench, con una distancia de edición de texto de 0,042; Puntuación de Wild-OmniDocBench (captura de escena realista) del 85,21 %; Puntuación de DocML (multilingüe) del 91,03 %. • Extracción de información y VQA: 92,29 % de precisión en un punto de referencia de 768 tarjetas/tickets; extracción de subtítulos de vídeo del 92,87 %; puntuación de referencia OCR de 860. • Traducción de texto e imágenes: admite más de 14 idiomas de origen en chino/inglés, con una puntuación COMET del 83,48 % en DoTA y del 73,38 % (otros en inglés)/73,62 % (otros en chino) en DocML. Estos resultados resaltan la eficiencia del modelo a un nivel liviano, especialmente en escenarios del mundo real donde supera a los VLM modulares y las tuberías tradicionales. @vllm_project permite una inferencia eficiente, generando un máximo de 16 384 tokens. El informe proporciona plantillas de sugerencias específicas para cada tarea, como detección de coordenadas, extracción de JSON o traducción, y está disponible tanto en chino como en inglés. Modelo de código abierto:

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.