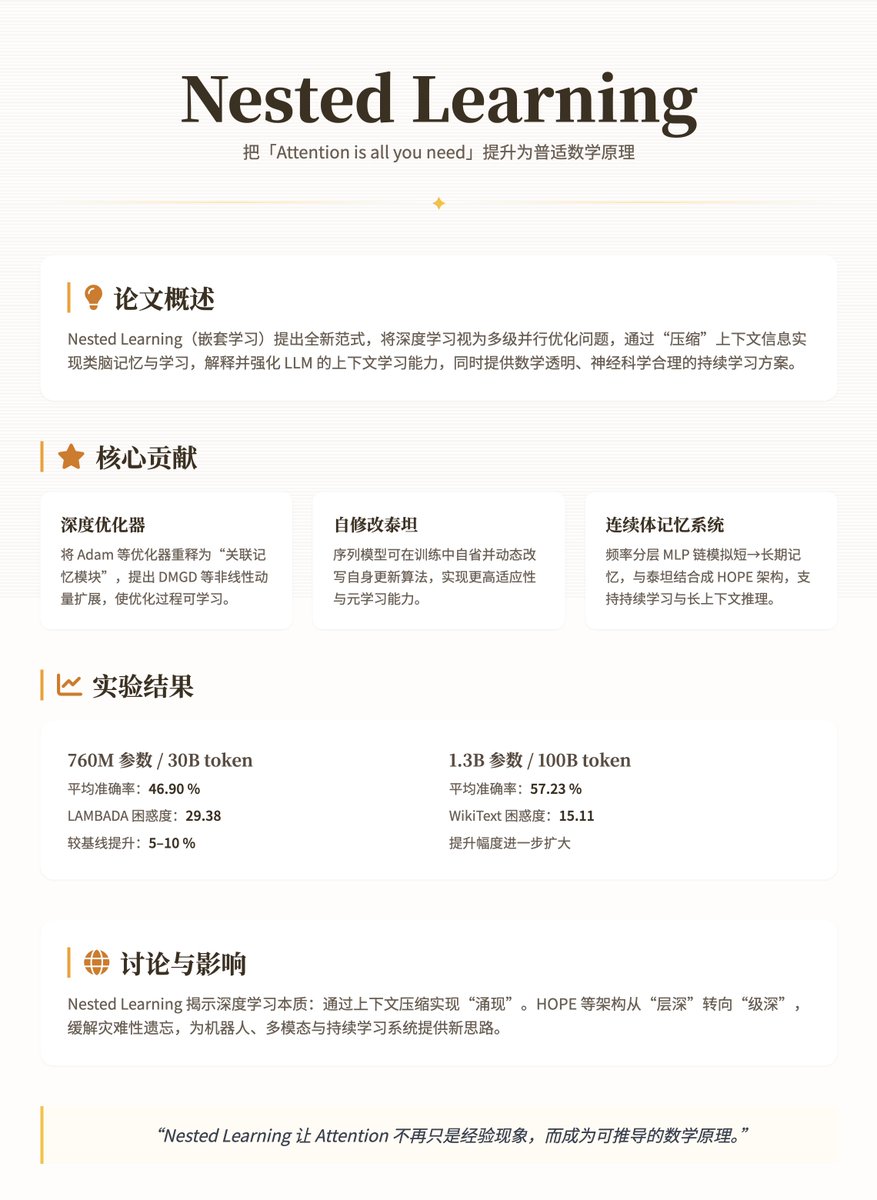

El último artículo de Google Research, "Nested Learning", se basa en el Transformer y eleva el lema "La atención es todo lo que necesitas" de un fenómeno empírico a un principio matemático más profundo y universal. Este artículo propone un nuevo paradigma de aprendizaje anidado para reexaminar y mejorar los modelos de aprendizaje profundo, en particular los LLM. El argumento principal es que el aprendizaje profundo tradicional no se limita a apilar capas, sino que comprime la información contextual mediante problemas de optimización multinivel anidados, logrando así un mecanismo de memoria y aprendizaje similar al del cerebro. Esto no solo explica las capacidades de aprendizaje contextual de los LLM, sino que también proporciona una solución matemáticamente transparente y neurocientíficamente sólida para superar sus problemas de estática y de olvido. Los conceptos y contribuciones centrales de este artículo modelan las redes neuronales como problemas de optimización paralela multinivel anidados, donde cada nivel corresponde a un flujo de contexto diferente y frecuencias de actualización que varían de altas a bajas (p. ej., memoria rápida a corto plazo y consolidación lenta a largo plazo). Esto se inspira en los procesos de consolidación de la memoria en neurofisiología: el cerebro procesa la información mediante la consolidación sináptica en línea (ajuste en tiempo real) y la consolidación del sistema fuera de línea (almacenamiento a largo plazo). El aprendizaje profundo tradicional suele considerarse una "ilusión": parece tener una arquitectura profunda, pero en realidad se basa en optimizaciones anidadas implícitas para comprimir gradientes o señales de atención. Las principales contribuciones de este trabajo incluyen tres aspectos: 1. Optimizadores profundos: Estos reinterpretan los optimizadores (como Adam o el SGD basado en momento) como "módulos de memoria asociados" que "recuerdan" información histórica al minimizar las pérdidas por compresión de gradiente (como la regresión ℓ₂). Los autores amplían estos optimizadores introduciendo, por ejemplo, el Descenso de Gradiente de Momento Profundo (DMGD), utilizando MLP multicapa para gestionar el momento no lineal o añadiendo precondicionadores para mejorar la expresividad. Esto hace que el proceso de optimización se asemeje más a un submódulo aprendible que a una regla fija. 2. Titanes automodificables: Un tipo de modelo de secuencia que puede modificar dinámicamente su propio algoritmo de actualización (similar al metaaprendizaje). Permite al agente realizar introspección y ajustar las actualizaciones de parámetros durante el entrenamiento, logrando una mayor adaptabilidad. 3. Sistema de Memoria Continua (CMS): Una cadena MLP con capas de frecuencia, donde cada capa se actualiza en diferentes ciclos (p. ej., cada C pasos), simulando el espectro continuo de la memoria a corto plazo a la memoria a largo plazo. La combinación del CMS con el sistema automodificable Titan forma la arquitectura HOPE, un modelo de lenguaje eficiente que facilita el aprendizaje continuo y el razonamiento a largo plazo. Estas contribuciones se definen rigurosamente a través de fórmulas matemáticas (como el objetivo de optimización de la memoria asociativa min_M ˜L(M(K); V), o la actualización del momento m_{t+1} = α m_t - η ∇L), lo que garantiza la transparencia y la escalabilidad. Métodos y detalles técnicos El núcleo de la Normalización (NL) son las actualizaciones multiescala: el modelo se descompone en capas lineales o mecanismos de atención, cada uno con su propio flujo de gradiente. Por ejemplo: • El entrenamiento MLP simple se puede ver como una optimización de una sola etapa, que utiliza señales sorpresa locales (LSS, desajuste entre la salida y el objetivo) para impulsar el descenso del gradiente. El mecanismo de atención lineal es de dos etapas: la capa interna actualiza la memoria a través de la similitud del producto escalar y la capa externa optimiza la matriz de proyección. • El optimizador, como el momento, se expande a la memoria clave-valor: la clave es el gradiente histórico y el valor es el preacondicionador P_i, logrando una compresión más robusta. La arquitectura HOPE integra CMS (cadena MLP multinivel: y_t = MLP^{(f_k)}(...MLP^{(f_1)}(x_t)...)) y un mecanismo de automodificación, lo que permite el cálculo paralelo y evita la complejidad cuadrática del Transformador. Durante el entrenamiento, las capas internas se actualizan rápidamente para capturar patrones inmediatos, mientras que las capas externas integran lentamente el conocimiento a largo plazo para mitigar el olvido catastrófico. Los autores probaron modelos con entre 340 millones y 1300 millones de parámetros en tareas de modelado lingüístico (WikiText, LAMBADA) y razonamiento lógico (PIQA, HellaSwag, etc.), utilizando datos preentrenados con entre 30 000 millones y 100 000 millones de tokens. Las líneas de base incluyeron Transformer++, RetNet, DeltaNet y Titans. Los resultados muestran que HOPE supera significativamente tanto en perplejidad como en precisión. • Con parámetros de 760M/configuraciones de token de 30B, HOPE logró una precisión promedio de 46,90% y una perplejidad LAMBADA de 29,38, superando la línea de base en aproximadamente un 5-10%. • Con 1.3 mil millones de parámetros/100 mil millones de tokens, la precisión promedio es del 57,23 % y la perplejidad de WikiText es del 15,11, lo que muestra una mejora más significativa. Discusión e impacto El paradigma del aprendizaje profundo (NL) revela la esencia del aprendizaje profundo: lograr capacidades emergentes mediante la compresión del contexto, como el aprendizaje de pocos disparos en los LLM. Sin embargo, también presenta limitaciones: los modelos son susceptibles a cambios en la distribución tras una implementación estática. Innovaciones como HOPE mitigan este problema mediante la anidación multinivel, inspirando a futuras arquitecturas a cambiar de la profundidad de capa a la profundidad de nivel, con posibles aplicaciones en robótica o sistemas multimodales. Dirección en papel

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.