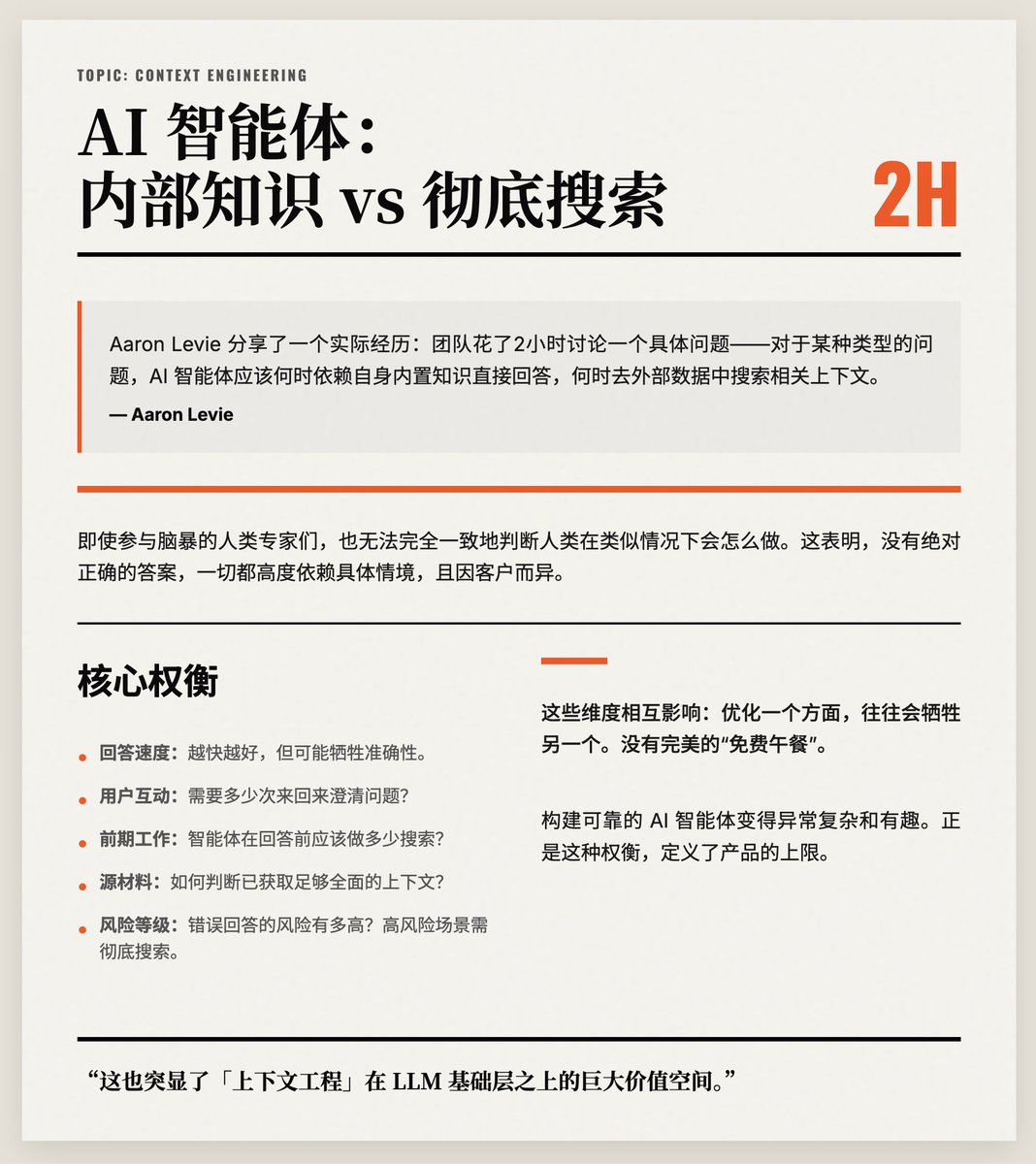

2小時辯論2個案例:AI 智能體要依賴內部知識還是徹底搜尋?這沒有標準答案,正是「情境工程」能夠成為AI 模型之上最大價值層的原因! Aaron Levie 分享了一個實際經驗:團隊花了2小時討論一個具體問題——對於某種類型的問題,AI 智能體應該何時依賴自身內置知識直接回答,何時去外部數據中搜索相關上下文。結果只討論了數百個測試案例中的2個。即使參與腦暴的人類專家們,也無法完全一致地判斷人類在類似情況下會怎麼做。這表明,沒有絕對正確的答案,一切都高度依賴具體情境,且因客戶而異。 Levie 的核心觀點是:情境工程本質上充滿權衡。需要同時考慮多個維度,例如: · 智能體回答的速度(越快越好,但可能犧牲準確性); · 用戶需要多少互動來澄清問題; · 智能體在回答前應該做多少前期工作(如搜尋資料); · 如何判斷已取得足夠全面的來源資料; · 錯誤回答的風險有多高(在高風險場景中,更傾向於徹底搜尋)。 這些維度相互影響:優化一個面向,往往會犧牲另一個。沒有完美的“免費午餐”。這使得建構可靠的AI 智能體變得異常複雜和有趣。 最後,他強調,這也突顯了「情境工程」在LLM 基礎層之上的巨大價值空間。正確處理這些權衡決策,直接決定了產品的核心價值和使用者體驗。

正在加载线程详情

正在从 X 获取原始推文,整理成清爽的阅读视图。

通常只需几秒钟,请稍候。