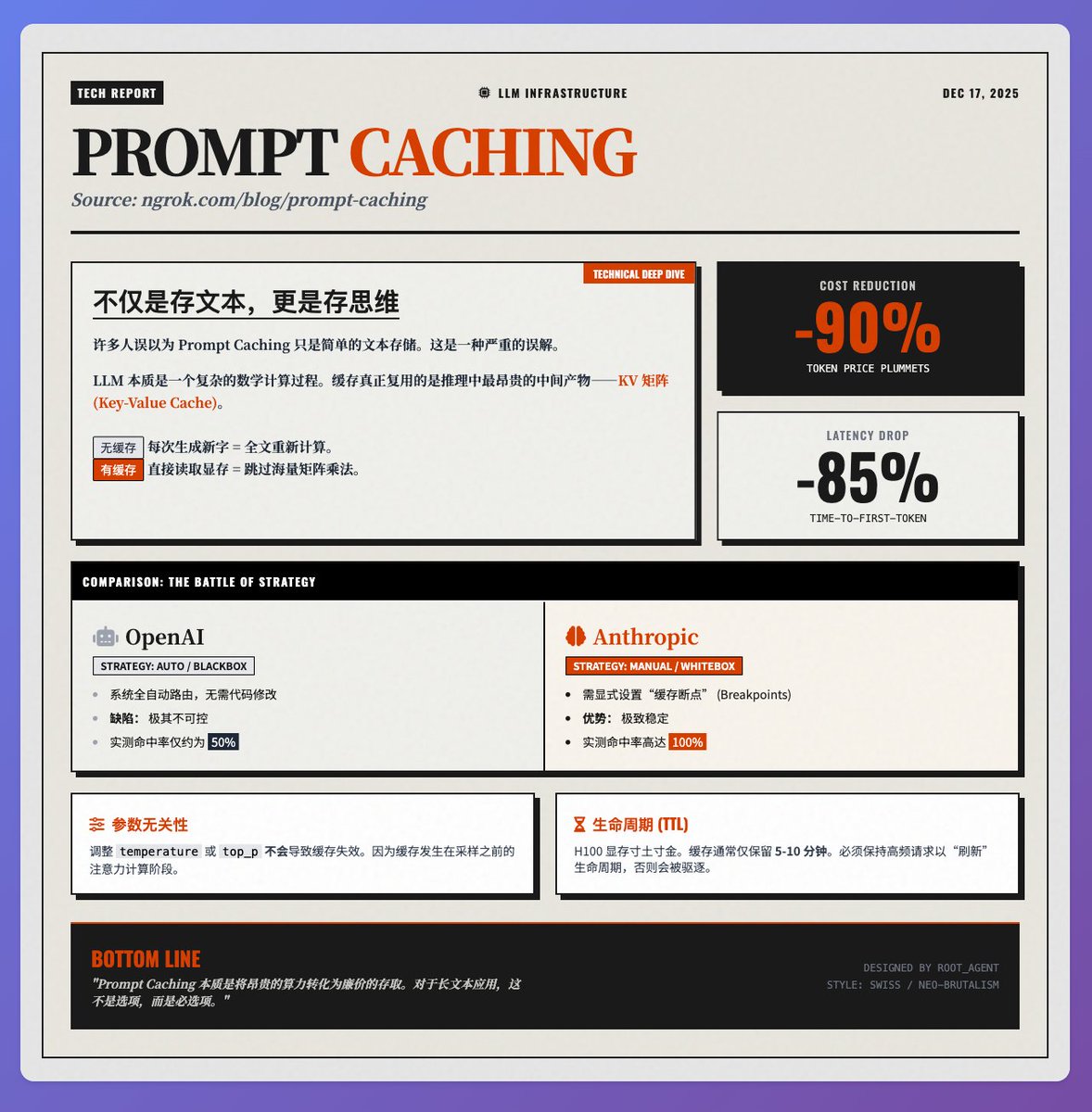

成本直降90%,延遲縮減85%:深度解讀Prompt Caching 技術原理 來自@ngrokHQ 團隊@samwhoo 關於Prompt Caching 的技術博客,Sam 從底層原理到廠商實測,非常清晰地揭示了這項技術如何成為LLM 應用降本增效的“殺手鐧”。 核心原理:快取的不是“文字”,是“思維狀態” 很多人誤以為Prompt Caching 只是簡單地儲存了輸入的文字。實際上,它重複使用的是模型推理過程中最昂貴的中間產物- K (Key) 和V (Value) 矩陣(即KV Cache)。 LLM 在處理每個Token 時,都需要透過注意力機制計算它與上下文的關係。 · 無快取時:每產生一個新字,模型都要重新計算全文的K/V 矩陣,造成巨大的算力浪費。 · 有快取時:直接從顯存讀取先前算好的矩陣,跳過繁重的矩陣乘法。 這就是為什麼它能帶來雙重紅利:既節省了約90% 的Token 費用,又將長文本場景下的首字延遲降低了85%。 廠商實測:OpenAI vs. Anthropic 的策略差異在實際落地中,兩家主流廠商的策略截然不同,直接影響系統的穩定性: 1. OpenAI(全自動黑盒): 系統自動嘗試路由請求以匹配緩存,開發者無需更改代碼。但代價是不可控制——實測中快取命中率並不穩定,僅在50% 左右。 2. Anthropic(手動白盒): 允許開發者明確設定「快取斷點」。雖然增加了開發門檻,但在規格設定下,實測命中率高達100%。對於追求極致穩定性的生產環境,Anthropic 目前的表現更優。 開發者需要關注的技術細節· 參數無關性:調整temperature 或top_p 等採樣參數不會導致快取失效。因為快取發生在採樣之前的注意力計算階段,這讓應用程式調試留出了很大空間。 · 生命週期:由於H100 顯存極為昂貴,快取通常只保留5-10 分鐘。想要長期復用,需要保持高頻的請求來「刷新」快取的生命週期。 總結 Prompt Caching 的本質,是將昂貴的「運算資源」轉化為相對廉價的「儲存讀取」。對於RAG、長文件分析或多輪對話應用程式而言,這是一項不僅能省錢,更能顯著提升使用者體驗的關鍵技術。 參考原文

正在加载线程详情

正在从 X 获取原始推文,整理成清爽的阅读视图。

通常只需几秒钟,请稍候。