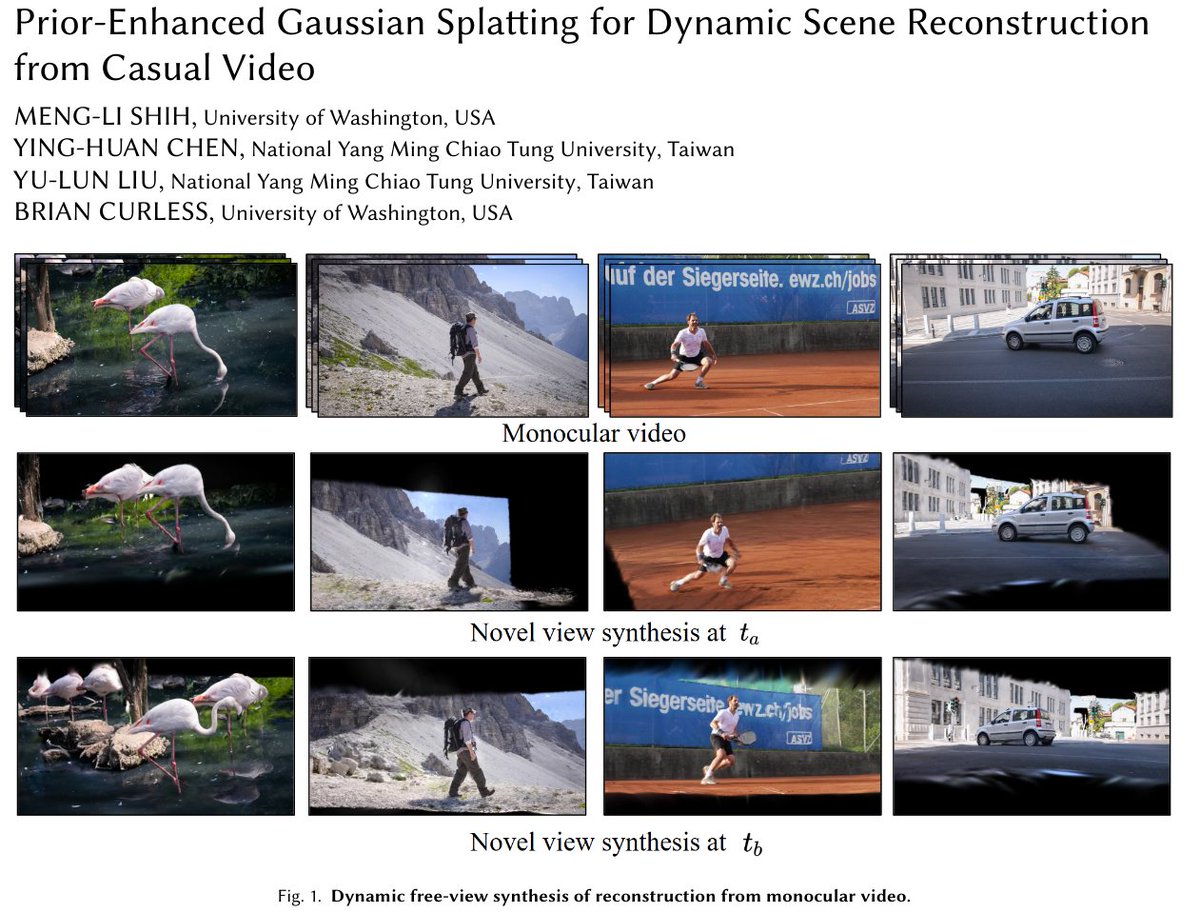

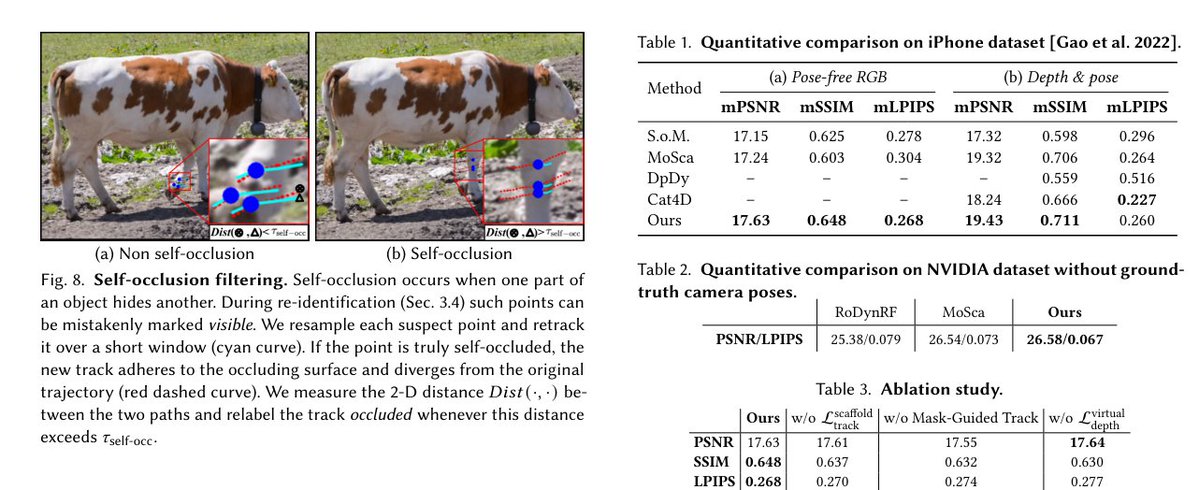

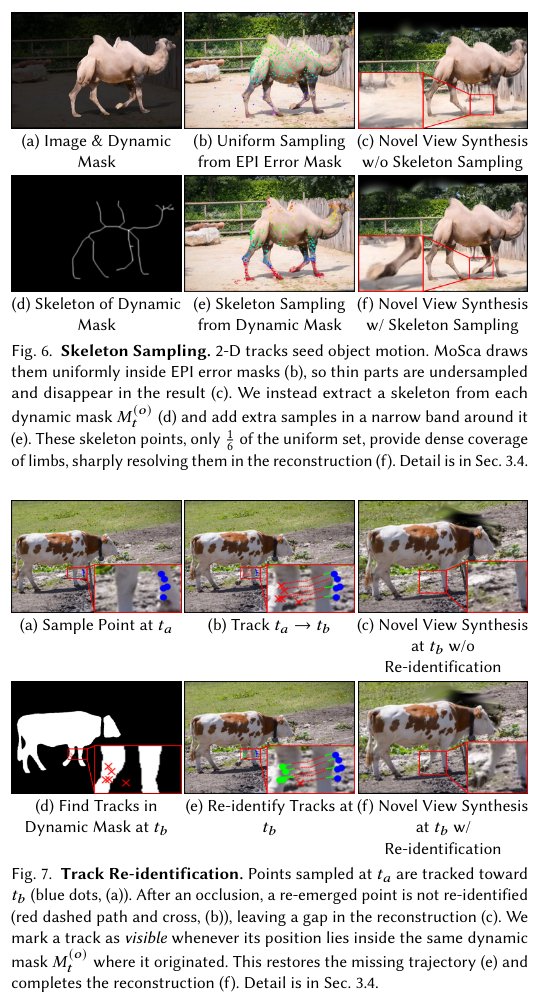

[SIGGRAPH Asia '25] 基于先验增强的高斯散射算法用于从日常视频中重建动态场景 抽象的: 我们提出了一种全自动流程,用于从随意拍摄的单目RGB视频中重建动态场景。我们没有设计新的场景表示,而是增强了驱动动态高斯散射的先验信息。 视频分割结合极线误差图可以生成与细小结构紧密贴合的对象级掩码。这些掩码 (i) 指导对象深度损失函数的计算,从而增强视频深度的一致性;(ii) 支持基于骨架的采样和掩码引导的重识别,以生成可靠、全面的二维轨迹。 在重建阶段,还融入了两个额外的目标,即改进后的先验信息: - 虚拟视图深度损失会消除漂浮物。 - 支架投影损失将运动节点与轨道连接起来,保持精细的几何形状和连贯的运动。 由此产生的系统超越了以往的单目动态场景重建方法,并提供了明显更优的渲染效果。

论文链接:htdl.acm.org/doi/10.1145/37…目链接:https://t.co/HQl6h9UgOm