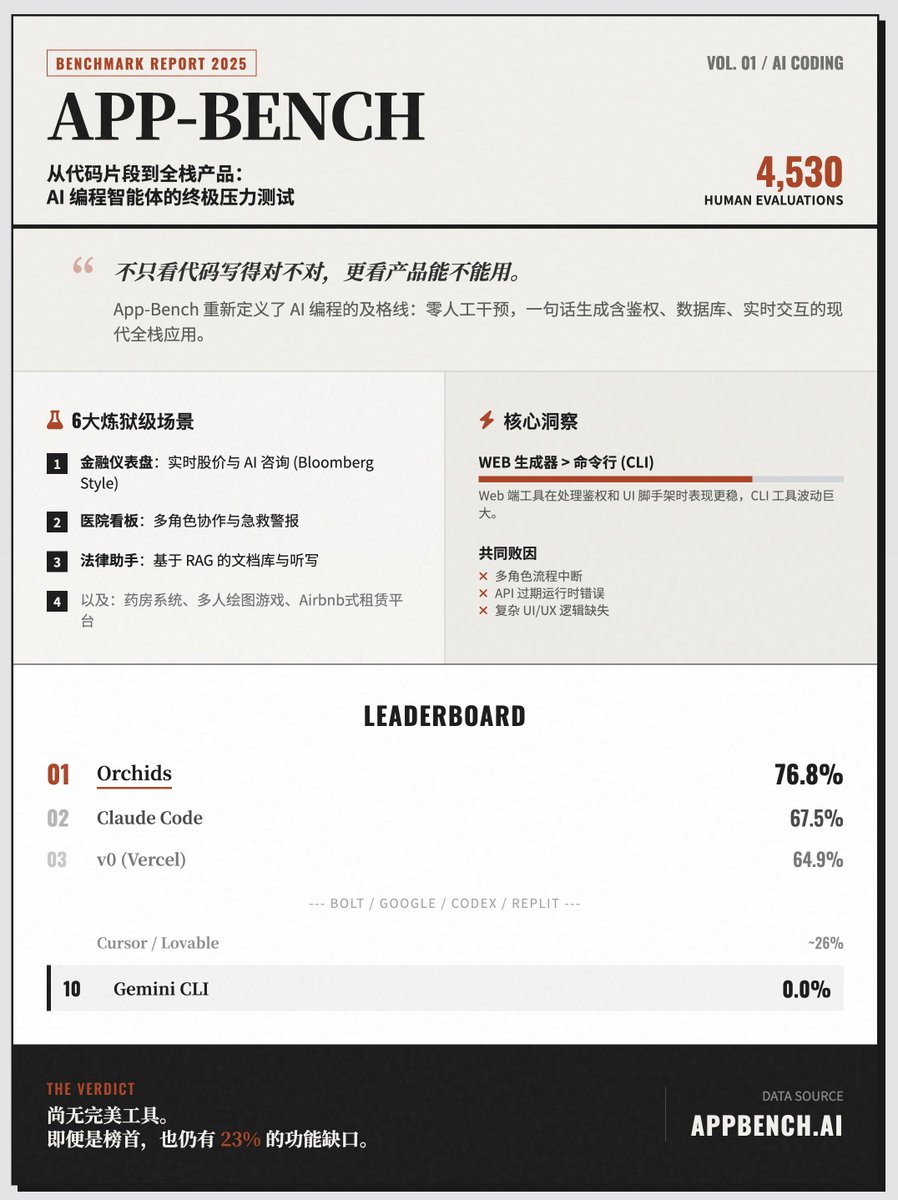

AI “一鍵生成”全端應用的終極考場“App-Bench”,Orchids 排名榜首,Claude Code 第二,Cursor 第八,Lovable 第九,Gemini CLI 零分? App-Bench 是一個高難度基準測試框架,它的核心目標非常明確:評估AI 程式設計智能體是否具備僅憑一句自然語言提示詞,在零人工幹預的情況下,產生完整、可用的現代Web 應用程式的能力。 評測核心:從“寫程式”到“做產品” App-Bench 不再滿足於測試AI 寫入函數片段的能力,而是檢視其建構全端應用的綜合實力。這些應用必須包含真實軟體的核心特徵: · 整合AI 助理· 即時資料同步· 多用戶角色邏輯· 自動化觸發器與鑑權流程 六大高難度測試場景為了模擬真實的經濟價值,App-Bench 選取了6 個不同領域的複雜應用程式進行測試: · 金融儀錶板: 類似彭博終端,含即時股價、互動圖表、AI 諮詢及即時論壇。 · 醫院管理看板: 涉及醫生/護士/管理員多角色,需處理床位狀態、急救警報及即時通訊。 · 法律助理: 基於RAG 的文件庫,支援語音聽寫和文件引用。 · 藥局系統: 連結病患與藥師,處理庫存、訂單及私密消息。 · 你畫我猜遊戲: 多人線上遊戲,需解決回合製邏輯、畫布即時同步和回放功能。 · 租賃預訂平台: 類似Airbnb,包含搜尋過濾、付款流程及媒體上傳。 嚴謹的評分方法· 評分者: 資深全端開發人員人工評分,非機器自動評分。 · 規模: 涵蓋151 個評分細項,累計進行了4,530 次評估。 · 機制: 每個工具給三次機會,取最好的一次成績。 關鍵發現與洞察· 產業現況: 即使是頂尖工具也無法完美通關。目前表現最好的工具也僅涵蓋了約77% 的必要功能,大多數工具在複雜任務(如多角色互動、複雜UI邏輯)上有顯著缺口。 · 工具形態比較: Web 端產生器的平均表現略優於命令列工具。 Web 工具在處理身分驗證和基礎UI 框架時更穩定,而CLI 工具的表現波動較大。 · 主要敗因: 功能缺失、多角色流程中斷、API 過期導致的執行階段錯誤,以及影響可用性的UI/UX 問題。 性能排行榜(Top 10) 1. Orchids 76.8% 2. Claude Code 67.5% 3. v0 (Vercel) 64.9% 4. Bolt 53.6% 5. Google AI Studio 50.3% 6. Codex 38.4% 7. Replit 35.1% 8. Cursor 27.8% 9. Lovable 25.8% 10. Gemini CLI 0.0% 造訪網站

正在加载线程详情

正在从 X 获取原始推文,整理成清爽的阅读视图。

通常只需几秒钟,请稍候。