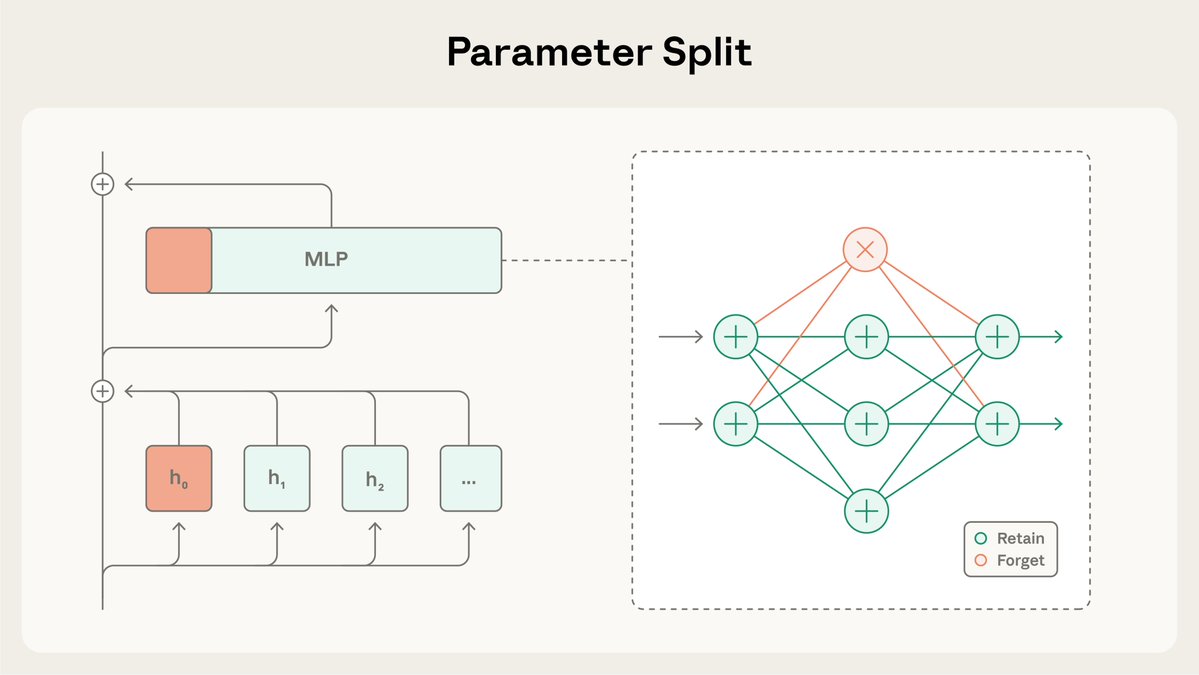

人类学研究员计划的最新研究:选择性梯度掩蔽(SGTM)。 我们研究如何训练模型,以便将高风险知识(例如关于危险武器的知识)隔离在一个较小的、单独的参数集中,这样就可以在不广泛影响模型的情况下将其移除。

SGTM 将模型的权重拆分为“保留”和“遗忘”子集,并在预训练期间将特定知识引导至“遗忘”子集。然后在部署到高风险环境之前,可以将其移除。 阅读更多:https://t.co/BfR4Kd86b0

在本研究中,我们测试了SGTM能否从基于维基百科训练的模型中移除生物学知识。数据过滤可能会泄露相关信息,因为非生物学维基百科页面也可能包含生物学内容。

在控制一般能力的情况下,使用 SGTM 训练的模型在不希望的“遗忘”知识子集上的表现不如使用数据过滤训练的模型。

与训练完成后发生的遗忘方法不同,SGTM 很难被撤销。 与之前的遗忘方法 RMU 相比,使用 SGTM 恢复遗忘的知识需要 7 倍的微调步骤。

该研究存在局限性:它是在一个简化的设置中进行的,使用了小型模型和代理评估,而不是标准基准。 此外,与数据过滤一样,SGTM 无法阻止由攻击者自行提供信息的上下文攻击。

请点击此处阅读SGTM的完整论文:https://t.co/Zfg2arxiv.org/abs/2512.05648Hub 上提供了相关代码:https://t.co/zRmJYy6bDE。

这项研究由 @_igorshilov 领导,是人类学研究员计划的一部分。