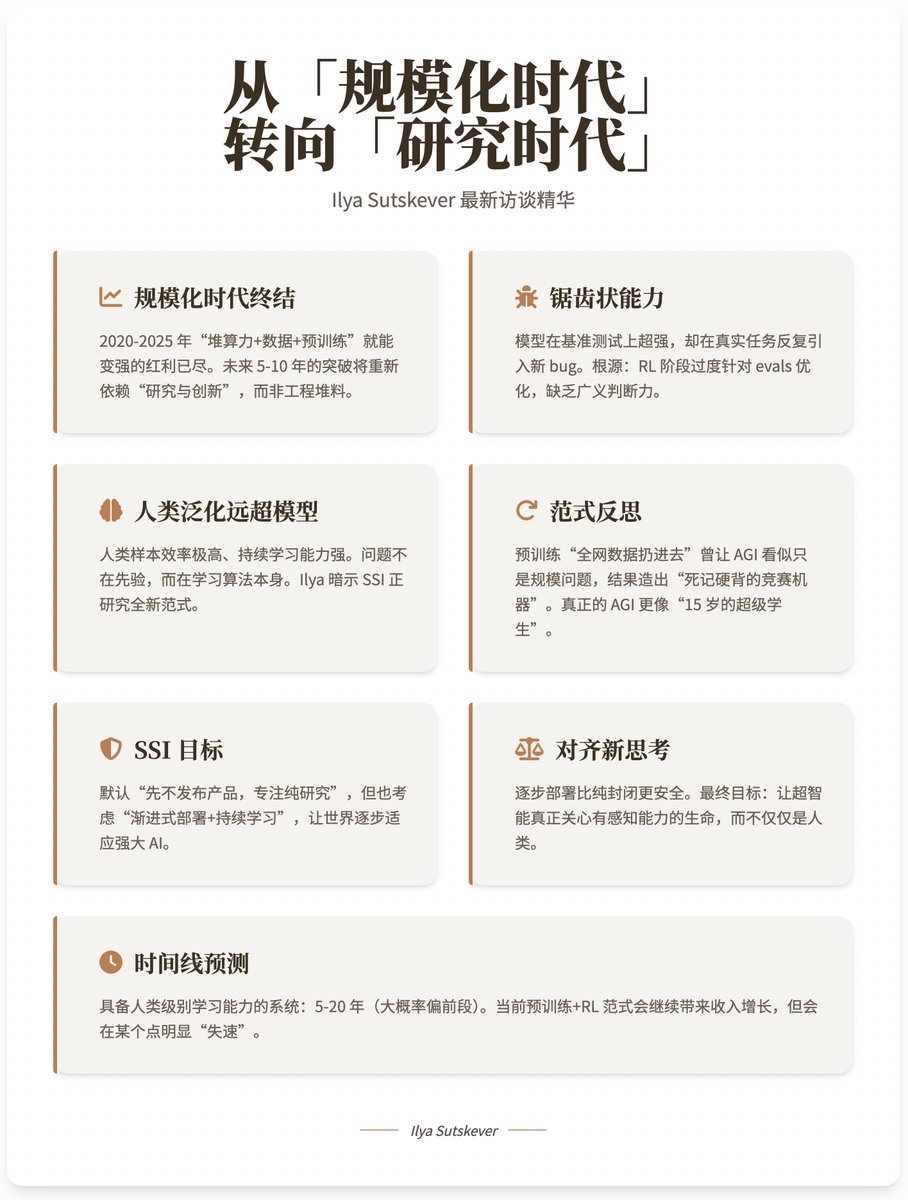

Ilya Sutskever – 我們正從「規模化時代」轉向「研究時代」 @ilyasut 和@dwarkesh_sp 的訪談終於來了!這位神秘的@ssi 創始人,前OpenAI 首席科學家,在離開OpenAI 後最完整的一次公開訪談,帶來了哪些最新觀點,咱們一起看看👁 1. 規模化時代已經結束(The age of scaling is over) · 2020-2025年是「規模化時代」(scaling era),靠堆算力+資料+預訓練就能穩定變強。 · 現在邊際報酬率急遽下降,單純100倍算力不會帶來質變。 · 未來5-10年的突破將重新依賴“研究與創新”,而不是工程堆料。 · Ilya 明確預測:2025年後,我們回到2012-2020年的“研究時代”,只是這次大家手裡有更大的算力。 2. 目前模型的「鋸齒狀」能力與真實世界表現脫節的根本原因· 模型在基準測試上超強,但在真實任務中反覆引入新bug、循環修復。 · Ilya 給出的解釋: · RL 階段過度針對evals 優化(人類研究員的「獎勵駭客」),導致過度特化。 · 類似「只練了1萬小時競技程式設計的學生」:技巧強,但缺乏「品味」與廣義判斷力。 · 真正的瓶頸不是算力,而是泛化能力遠不如人類。 3. 人類為什麼要泛化遠超模型? · 人類樣本效率極高、持續學習能力強、穩健性驚人。 · 演化給了極強的先驗(視覺、運動、內在價值函數),但語言、數學、程式設計這些新領域人類依然遠超模型→說明問題不在先驗,而在學習演算法本身更優。 · Ilya 暗示:他和SSI 正在研究一種全新的機器學習範式,能接近人類層面的持續學習與泛化(但因競爭原因無法公開細節)。 4. 對「預訓練+ RL」 範式的反思· 預訓練的成功在於「不用選數據,直接全網數據丟進去就行」。 · 但這也讓大家誤以為“AGI 就是預訓練到足夠大”,結果造出了“死記硬背的競賽機器”而不是真正靈活的智能。 · 真正的AGI 更像一個「15歲的超級學生」:基礎能力極強,但具體知識和技能仍需透過部署和持續學習來獲得。 5. SSI 的真正目標:直奔安全超智慧(Straight-shot Safe Superintelligence) · 預設計畫仍是「先不發布產品,專注純研究,直到做出本質安全的超智慧再一次發布」。 · 但Ilya 首次鬆口:也在認真考慮「漸進式部署+從真實世界持續學習」的路徑,因為: · 讓世界逐步適應強大AI,可能比完全封閉開發更安全。 · 超智能很可能不是「一次全知全能」的終態,而是一個能持續學習、像人類一樣在崗位上成長的系統。 6. 對齊觀點的重要更新· 過去一年Ilya 最大的思維轉變:**逐步部署和讓世界真實感受到AI 的力量,比純思考更重要**。 · 他預測:當AI 真正開始「感覺強大」時,所有前沿公司都會突然變得極度偏執對待安全。 · 最終對齊目標:讓超智能真正關心有感知能力的生命,而不僅僅是“人類”,因為未來的感知體大多數會是AI 自己。 · 長期穩定方案之一(他自己不喜歡但承認可能必要):人機深度融合(Neuralink++等級),讓人類直接參與並理解AI的決策。 7. 時間軸預測· 具備人類等級學習能力、從而能走向超智慧的系統:5-20年(大機率偏前段)。 · 目前預訓練+RL 範式會繼續帶來收入成長,但會在某個點明顯“失速”,無法達到真正的人類水平泛化。 8. 研究品味(Research Taste)的本質· 好的研究方向必須同時滿足: · 來自對人腦的正確類比· 簡潔、優美、無醜陋感· 多角度看都成立的「頂級信念」(top-down conviction) · 這種品味能讓你在實驗持續失敗、所有數據都說「你錯了」時,依然堅持調試而不是放棄。 Youtube 影片地址:

正在加载线程详情

正在从 X 获取原始推文,整理成清爽的阅读视图。

通常只需几秒钟,请稍候。