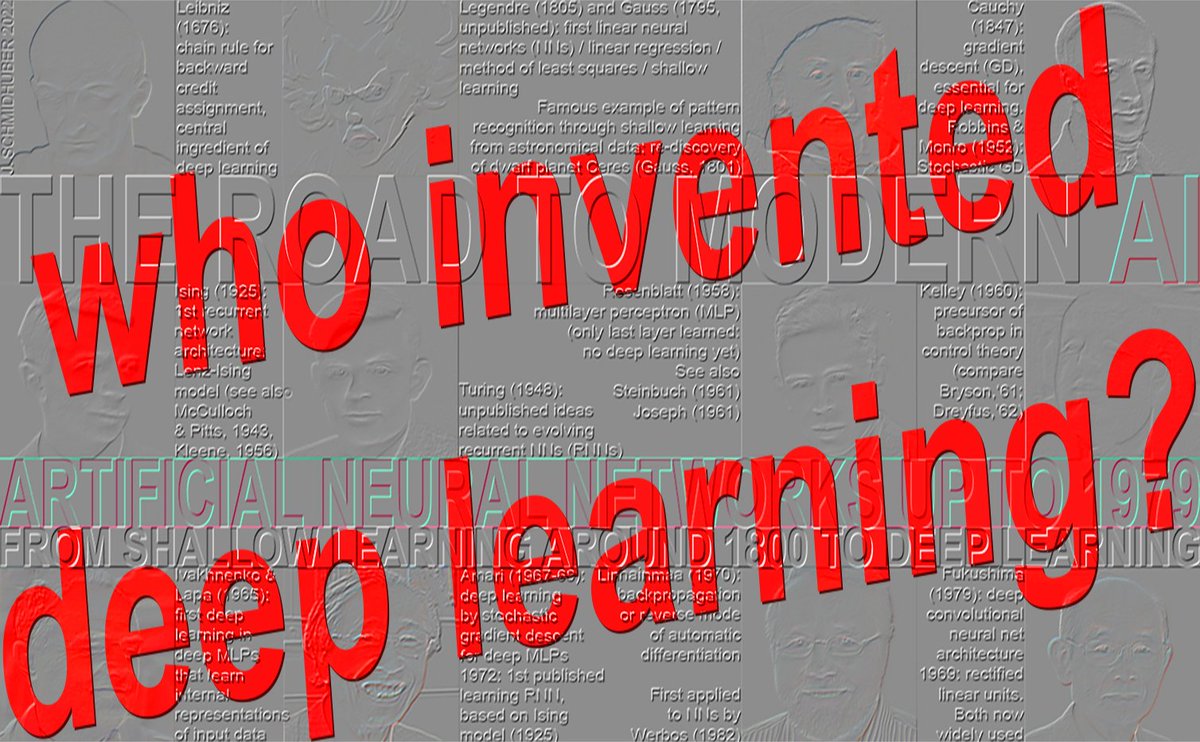

谁发明了深度学习? https://t.co/aJfpTpeople.idsia.ch/~juergen/who-i…学习模型(Ivakhnenko & Lapa,1971年达到8层) 1967-68 年:通过随机梯度下降实现端到端深度学习(Amari,5 层) 1970 年:反向传播算法(Linnainmaa,1970 年)应用于神经网络(Werbos,1982 年):很少超过 5 层(20 世纪 80 年代) 1991-93 年:深度神经网络的无监督预训练(Schmidhuber 等人,100 层以上) 1991-2015:深度残差学习(Hochreiter等人,100层以上) 1996年至今:无梯度深度学习(100层以上) ★ 1965年:第一个深度学习模型(Ivakhnenko & Lapa,1971年实现8层) 深度前馈网络架构的成功学习始于 1965 年的乌克兰(当时是苏联),当时 Alexey Ivakhnenko 和 Valentin Lapa 提出了第一个通用的、有效的深度多层感知器 (MLP) 或具有许多隐藏层的前馈神经网络 (FNN) 的学习算法(其中已经包含现在流行的乘法门)[DEEP1-2][DL1-2][DLH][WHO5]。 1971 年的一篇论文 [DEEP2] 描述了一个 8 层的深度学习网络,该网络通过他们被广泛引用的方法进行训练,该方法在新千年仍然很流行 [DL2]。 给定一个包含输入向量及其对应目标输出向量的训练集,网络层通过回归分析逐步增长和训练。在微调阶段,借助独立的验证集,利用正则化剪枝去除多余的隐藏单元[DEEP2][DLH]。这简化了网络结构,并提高了其在未见过的测试数据上的泛化能力。网络层数和每层单元数根据具体问题进行学习。这是对原始两层高斯-勒让德神经网络(1795-1805)[DLH]的有力推广。 也就是说,早在“连接主义”这个名称在20世纪80年代流行起来的二十年前,伊瓦赫年科及其同事就提出了带有自适应隐藏层的连接主义模型。与后来的深度神经网络类似,他的模型能够学习创建输入数据的分层、分布式内部表示。他当时并没有称它们为深度学习神经网络,但它们本质上就是深度学习神经网络。 伊瓦赫年科的开创性工作屡遭剽窃,一些研究人员后来还共同获得了图灵奖[DLP][NOB]。例如,伊瓦赫年科1971年提出的逐层训练方法[DEEP2]的深度与35年后辛顿和本吉奥于2006年发表的逐层训练方法[UN4][UN5]的深度相当,却未与伊瓦赫年科的原始工作进行比较[NOB]——而当时的计算成本是现在的数百万倍。同样,勒昆等人[LEC89]发表的神经网络剪枝技术也没有提及伊瓦赫年科关于深度神经网络剪枝的原始工作。即使在他们后来发表的深度学习“综述”[DL3][DL3a]中,这些获奖者也未提及深度学习的起源[DLP][NOB]。 Ivakhnenko 和 Lapa 还证明,仅使用局部可用信息即可学习隐藏单元的合适权重,而无需进行生物学上不合理的反向传播 [BP4]。六十年后,Hinton 将这一成就归功于自己 [NOB25a]。 伊瓦赫年科的神经网络与更早的、不涉及深度学习的多层前馈神经网络相比如何?1958年,弗兰克·罗森布拉特研究了多层感知器(MLP)[R58]。他的MLP具有一个权重随机且不学习的第一层和一个自适应的输出层。这还不是深度学习,因为只有最后一层会学习[DL1]。1961年,卡尔·斯坦布赫[ST61-95]和罗杰·大卫·约瑟夫[R61]也讨论了MLP。另见奥利弗·塞尔弗里奇的多层网络Pandemonium[SE59](1959)。1962年,罗森布拉特等人甚至在约瑟夫1961年关于训练隐藏单元的初步想法[R61]的基础上,撰写了关于带有隐藏层的MLP中“反向传播误差”的文章[R62],但约瑟夫和罗森布拉特当时还没有适用于深度MLP的深度学习算法。现在被称为反向传播的算法与此截然不同,它最早由 Seppo Linnainmaa 于 1970 年发表 [BP1-4]。 为什么深度学习会在20世纪60年代中期在苏联兴起?当时,苏联在许多重要的科技领域处于领先地位,尤其是在航天领域:第一颗人造卫星(1957年)、第一个人造物体登陆天体(1959年)、第一位宇航员进入太空(1961年)、第一位女性宇航员进入太空(1962年)、第一个机器人登陆天体(1965年)、第一个机器人登陆其他行星(1970年)。苏联还在1961年引爆了世界上威力最大的原子弹,并且拥有众多顶尖数学家,为基础数学研究提供了充足的资金,而这些研究的巨大意义直到几十年后才显现出来。 上述其他部分(1967、1970、1991-93、1991-2015、1996)已在 [WHO5] 中涵盖:谁发明了深度学习?技术说明 IDSIA-16-25,IDSIA,2025 年 11 月。 参考文献([WHO5] 中还有许多其他参考文献 - 请参见上方链接): [BP1] S. Linnainmaa. 将算法的累积舍入误差表示为局部舍入误差的泰勒展开式。硕士论文(芬兰语),赫尔辛基大学,1970 年。参见第 6-7 章和第 58-60 页的 FORTRAN 代码。另见 BIT 16,146-160,1976 年。链接。这是关于“现代”反向传播(也称为自动微分的反向模式)的第一篇出版物。 [BP4] J. Schmidhuber (2014). 谁发明了反向传播? [BPA] HJ Kelley. 最优飞行路径的梯度理论。ARS Journal,第 30 卷,第 10 期,第 947-954 页,1960 年。现代反向传播的先驱 [BP1-4]。 [DEEP1] Ivakhnenko, AG 和 Lapa, VG (1965)。控制论预测装置。CCM 信息公司。第一个具有多层、学习内部表征的深度学习器。 [DEEP1a] 伊瓦赫年科,阿列克谢·格里戈列维奇。数据处理的群方法;随机逼近方法的竞争。苏联自动控制13(1968):43-55。 [DEEP2] Ivakhnenko, AG (1971). 复杂系统的多项式理论。IEEE 系统、人与控制论汇刊,(4):364-378。 [DL1] J. Schmidhuber,2015 年。神经网络中的深度学习:概述。《神经网络》,61,85-117。获得了《神经网络》期刊自 1988 年创刊以来颁发的首个最佳论文奖。 [DL2] J. Schmidhuber,2015。深度学习。Scholarpedia,10(11):32832。 [DL3] Y. LeCun, Y. Bengio, G. Hinton (2015).深度学习。自然 521, 436-444。一篇关于深度学习的“综述”,但没有提及深度学习的开创性工作[DLP][NOB]。 [DL3a] Y. Bengio、Y. LeCun、G. Hinton (2021)。图灵讲座:人工智能的深度学习。ACM 通讯,2021 年 7 月。另一篇关于深度学习的“综述”,却没有提及深度学习的开创性工作 [DLP][NOB]。 [DLH] J. Schmidhuber. 现代人工智能和深度学习的注释历史。技术报告 IDSIA-22-22,IDSIA,卢加诺,瑞士,2022 年。预印本 arXiv:2212.11279。 [DLP] J. Schmidhuber. 三位图灵奖获得者如何重新发表了他们未注明出处的关键方法和思想。技术报告 IDSIA-23-23,瑞士人工智能实验室 IDSIA,2023 年。 [GD'] C. Lemarechal.柯西与梯度法.数学文献增刊,第251-254页,2012年。 [GD''] J.哈达玛。关于弹性斑块镶嵌问题分析相关的回忆录。法国科学院院士的回忆录,1908 年 33 日。 [GDa] YZ Tsypkin (1966). Adaptation, training and self-organization automatic control systems, Avtomatika I Telemekhanika, 27, 23-61. On gradient descent-based on-line learning for nonlinear systems. [GDb] YZ Tsypkin (1971). 自动系统中的适应和学习,学术出版社,1971 年。关于基于梯度下降的非线性系统在线学习。 [GD1] SI Amari (1967). 自适应模式分类器理论, IEEE Trans, EC-16, 279-307 (日文版于 1965 年出版)。可能是第一篇关于使用随机梯度下降 [STO51-52] 在多层神经网络中进行学习的论文(没有具体说明现在被称为反向自动微分或反向传播 [BP1] 的梯度下降方法)。 [GD2] SI Amari (1968). 信息论——信息的几何理论,共立出版社,1968 年(日文,见第 119-120 页)。包含一个五层网络(其中 2 层可修改)的计算机模拟结果,该网络学习内部表示以对非线性可分模式类别进行分类。 [GD2a] S. Saito (1967). 日本九州大学工学研究生院硕士论文。Amari 1967 年提出的多层感知器随机梯度下降法的实现 [GD1]。(S. Amari,私人通信,2021 年。) [NOB] J. Schmidhuber. 因剽窃而获得诺贝尔奖。技术报告 IDSIA-24-24(2024 年 12 月 7 日,2025 年 10 月更新)。 [NOB25a] G. Hinton. 诺贝尔奖演讲:玻尔兹曼机。《现代物理评论》97, 030502, 2025年8月25日。这篇演讲中诸多有问题的论述之一是:“玻尔兹曼机已不再使用,但它们在历史上非常重要[...] 在20世纪80年代,它们证明了仅使用局部可用信息即可学习隐藏神经元的合适权重,而无需进行生物学上不合理的反向传播。” Hinton再次忽略了Ivakhnenko,后者早在20世纪60年代就证明了这一点[DEEP1-2]。 [WHO5] J. Schmidhuber(人工智能博客,2025)。谁发明了深度学习?技术说明 IDSIA-16-25,IDSIA,2025 年 11 月。参见上方链接。

正在加载线程详情

正在从 X 获取原始推文,整理成清爽的阅读视图。

通常只需几秒钟,请稍候。