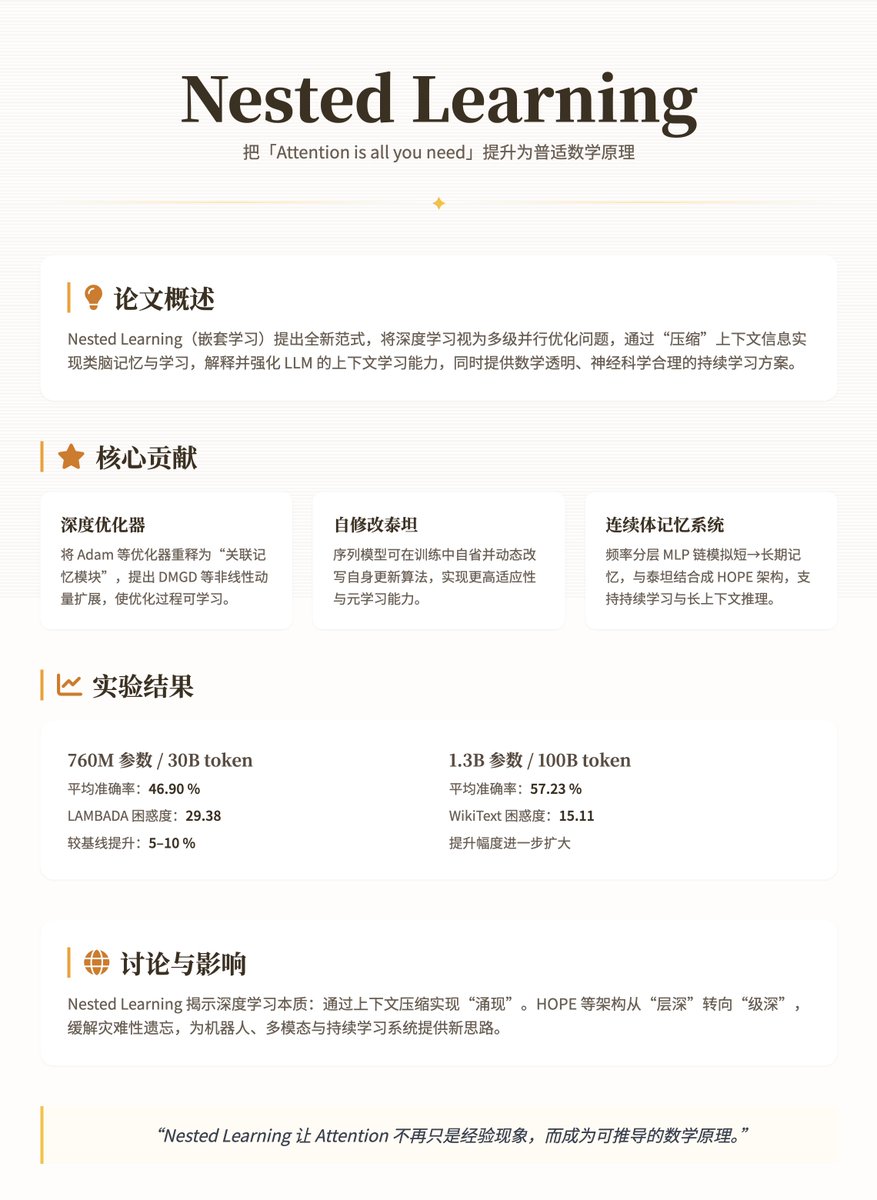

Google Research 最新論文「Nested Learning」:站在Transformer 的肩膀上,把「Attention is all you need」這句口號,從經驗現象提升成了一個更深刻、更普適的數學原理 論文概述論文提出了一種Nested Learning(嵌套學習)全新範式,用於重新審視和提升深度學習模型,特別是LLMs。論文的核心觀點是:傳統深度學習並非簡單地堆疊層級,而是透過嵌套的多層優化問題來「壓縮」上下文訊息,從而實現類似大腦的記憶和學習機制。這不僅解釋了LLMs 的「上下文學習」能力,還為克服其靜態性和遺忘問題提供了數學透明且神經科學合理的解決方案。 核心概念與貢獻論文將神經網路建模為嵌套的、多級並行優化問題,每個層級對應不同的“上下文流”,更新頻率從高到低(如快速的短期記憶到緩慢的長期鞏固)。這借鑒了神經生理學中的記憶鞏固過程:大腦透過線上突觸鞏固(即時調整)和離線系統鞏固(長期儲存)來處理資訊。傳統深度學習被視為「幻覺」——它看似深層架構,但實際上依賴隱含的嵌套優化來壓縮梯度或註意力訊號。 論文的主要貢獻包括三個面向: 1. 深度優化器(Deep Optimizers):將優化器(如Adam 或帶動量的SGD)重新詮釋為“關聯記憶模組”,它們通過最小化梯度壓縮損失(如ℓ₂回歸)來“記住”歷史信息。作者擴展了這些優化器,例如引入「深度動量梯度下降」(DMGD),使用多層MLP 處理非線性動量,或添加預條件器以提升表達力。這使得最佳化過程更像一個可學習的子模組,而非固定規則。 2. 自修改泰坦模型(Self-Modifying Titans):一種序列模型,能動態修改自身的更新演算法(類似元學習)。它允許智能體在訓練中「自省」並調整參數更新,以實現更高的適應性。 3. 連續體記憶系統(Continuum Memory System, CMS):一個頻率分層的MLP 鏈,每個層以不同週期更新(例如,每C步驟更新一次),模擬短期到長期記憶的連續光譜。將CMS 與自修改泰坦結合,形成HOPE 架構—一個高效率的語言模型,支援持續學習和長上下文推理。 這些貢獻透過數學公式(如關聯記憶的最佳化目標min_M ˜L(M(K); V),或動量更新m_{t+1} = α m_t - η ∇L)來嚴謹定義,確保透明性和可擴展性。 方法與技術細節 NL 的核心是多時間尺度更新:模型分解為線性層或註意力機制,每個組件都有獨佔的梯度流。舉例來說: · 簡單MLP 訓練可視為單級最佳化,使用局部驚喜訊號(LSS,輸出與目標的失配)驅動梯度下降。 · 線性注意力機制則為兩層:內層透過點積相似性更新記憶,外層優化投影矩陣。 · 優化器如動量擴展為鍵-值記憶:鍵為歷史梯度,值為預條件器P_i,實現更穩健的壓縮。 HOPE 架構整合了CMS(多層MLP 鏈:y_t = MLP^{(f_k)}(...MLP^{(f_1)}(x_t)...))和自修改機制,支援並行計算,避免Transformer 的二次複雜度。訓練時,內層快速更新以捕捉即時模式,外層緩慢整合長期知識,緩解災難性遺忘。 實驗結果作者在語言建模(WikiText、LAMBADA)和常識推理任務(PIQA、HellaSwag 等)上測試了340M 至1.3B 參數的模型,使用30B 至100B token 預訓練資料。對比基線包括Transformer++、RetNet、DeltaNet 和Titans,結果顯示HOPE 在困惑度和準確率上顯著優越: · 在760M 參數/30B token 設定下,HOPE 的平均準確率達46.90%,LAMBADA 困惑度29.38,優於基線約5-10%。 · 在1.3B 參數/100B token 下,平均準確率57.23%,WikiText 困惑度15.11,提升更明顯。 討論與影響 NL 範式揭示了深度學習的本質:透過情境壓縮實現「湧現」能力,如LLMs 的少樣本學習。但它也暴露了限制——靜態部署後模型易受分佈偏移影響。 HOPE 等創新透過多層嵌套緩解此問題,啟發未來架構從“層深”轉向“級深”,潛在應用於機器人或多模態系統。 論文地址

正在加载线程详情

正在从 X 获取原始推文,整理成清爽的阅读视图。

通常只需几秒钟,请稍候。