切勿遮挡GPU! 在 @modal 的一篇新博文中,我们探讨了 AI 推理中一个主要的低效类别:主机开销。 我们列举了三个与 @sgl_project 合作以减少主机开销并防止 GPU 停顿的案例。 每一微秒都至关重要。 https://t.co/ZeumrZpSKE

对于推理过程,我喜欢把GPU想象成一艘大船,把CPU想象成领航员。领航员需要告诉船该往哪里走。 如果船停下来等待领航员指示下一步行动,那就糟了!你会浪费资源和时间。

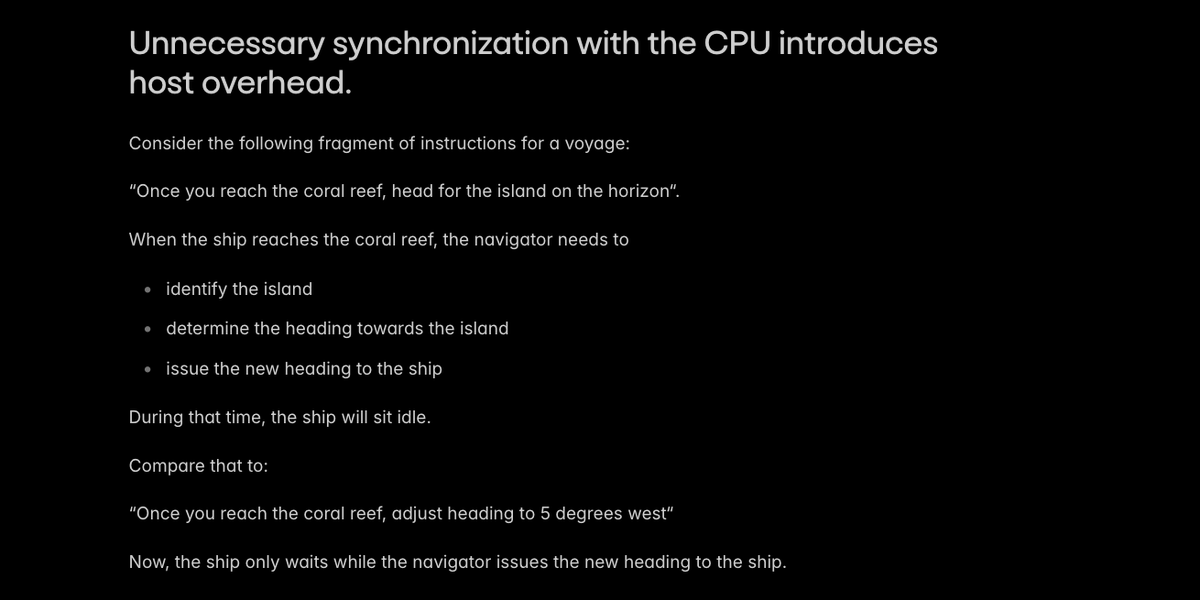

AI 推理中主机开销的主要原因是与 CPU 不必要的同步——相当于让船等待导航员。

像 @sgl_project 这样的生产引擎避免了主机/设备同步中最明显的案例。 我们发现了两种特殊情况,只需稍加巧妙处理即可避免同步: - 在设备上构建一些位置嵌入 - 在主机上重新计算一些 KV 缓存页的长度

PR 在这里: hgithub.com/sgl-project/sg… github.com/sgl-project/sg…

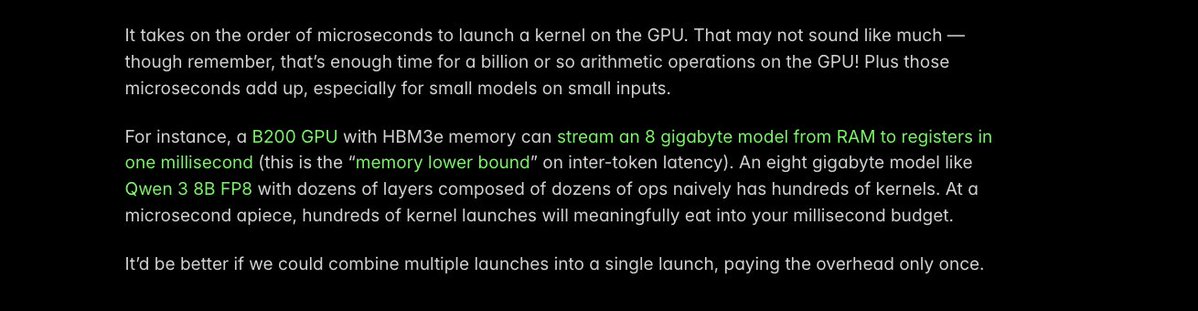

减少主机开销的另一个关键技巧是_融合_内核:将多个独立的 GPU 内核启动合并为一个内核启动。 每次发射的额外时间只有大约一微秒,但每一微秒都至关重要!

我们发现,在较小的 VLM 中,某个特定操作会产生较大的内核启动开销——而我们看到这些 VLM 的部署量正在大幅增加(感谢 @Alibaba_Qwen)。 因此,我们使用 @PyTorch 编译器自动融合内核,将执行时间从 40 微秒缩短到 5 微秒。

详情请见此新闻稿:https://t.co/gvEqTgdIth

Torch 编译对于快速降低推理延迟非常有效。 我们之前已经写过相关文章: https://t.co/MN072QDXzz

还有更多微秒可以节省,还有更多 GPU 可以从未经优化的 CPU 代码的束缚中解放出来! 但 @modal 团队很高兴已经取得了一些进展,这些进展有助于我们的客户提供交互式 AI 应用。 点击此处阅读博客:https://t.co/ZeumrZqqAc