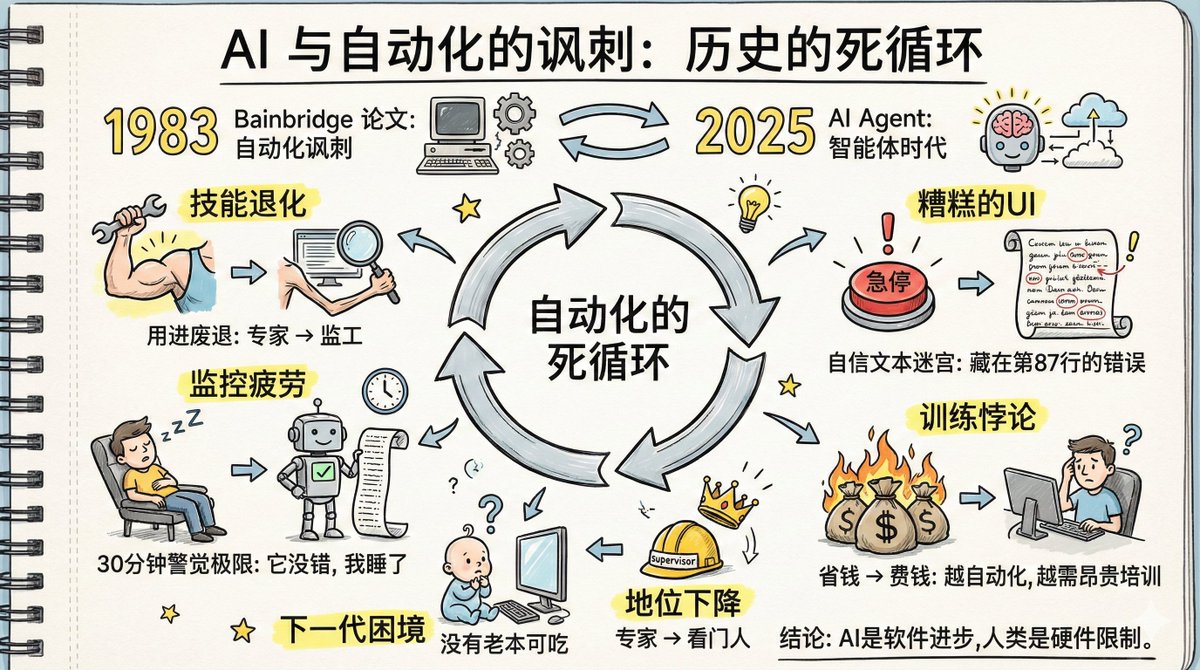

今天看了篇文章,叫:《AI 與自動化的諷刺》,內容跟當前AI 的發展很應景。 1983年,一位認知心理學家Lisanne Bainbridge 寫了篇論文,題目叫做《自動化的諷刺》。四十多年後的今天,這篇論文上預言的問題,正一字一句地在AI Agent 身上應驗。 當年她研究的是工廠自動化:機器工作,人類監督。 今天我們面對的是AI Agent自動化:AI工作,人類監督。場景變了,但底層邏輯一模一樣。而她當時在論文中指出的那些問題,又重新來了一次。 論文中都提到了哪些問題呢? 1. 技能退化困境:不用就會忘,專家變監工後技能會萎縮 用進廢退,這四個字我們都懂。但放到AI時代,它有個更殘酷的版本。 以前你是某個領域的專家,每天都做這件事,手到擒來。現在公司說,讓AI Agent來做吧,你負責盯著它,出了問題再介入。 聽起來很美好對不對?從打工升級成監工,豈不是更輕鬆? 問題來了:你不做這件事了,但你的技能不只不會進步,甚至還會退化。 像我這樣天天用AI 寫代碼的,我能感覺得到這兩年是沒啥進步,而且對AI 有依賴,很多以前信手拈來隨手就可以寫出來的代碼,現在沒有AI 就啥都不想乾了。 真的是有點用進廢退了。 無論是OpenAI 還是Anthropic 都在吹他們的Coding Agent 多厲害,他們的員工只要驗證AI 寫的結果就好了,但是他們故意沒提的是,這些人都是萬裡挑一的高手,他們有足夠的經驗判斷AI對不對。但如果他們接下來幾年都只是驗證AI 做的對不對,那麼他們的技能會慢慢倒退。 像我們這一代老程式設計師還好,更要命的是下一代。 今天的老程式設計師好歹是從實戰中成長起來的。明天的程式設計師呢?他們從入行第一天就在盯AI,沒怎麼親手做過。他們既沒有技能,也沒有機會學。那他們怎麼判斷AI對不對? 論文原話是: > 目前這代自動化系統,正在吃老一代操作員的技能老本。下一代操作員不可能擁有這些技能。 這個問題今天看不出來,三、五年後可能就會凸顯出來了。 2. 記憶提取困境:不常用的知識,調取速度也會變慢 還有個問題就是相關技能的記憶也會退化。 想想我們高中時哪些滾瓜爛熟的公式,現在還能想幾個了。放到AI 監督的場景,隨著AI 能力越來越強,大部分時候都是對的,這意味著大多數時候不需要用到你的知識,隨著你的知識越用越少,相關的記憶就會退化。 3. 實踐悖論:理論培訓沒用,必須實戰才能學會,但AI在工作人沒機會練 這時候你可能會想:那培訓是不是有用? 但是《自動化的諷刺》論文中的結論是:培訓並沒有太大用。 因為專業技能不是聽課聽出來的,是在真實場景裡靠實戰鍛鍊出來的。課堂上學的理論,如果沒有配套的實戰練習,你很可能聽不懂,因為沒有相應的經驗框架。就算當時懂了,很快也會忘,因為沒有和真實任務綁定的記憶提取路徑。 要保持監督AI的能力,你得定期親自工作。但如果公司追求的是讓AI 自動化運作以提升效率,那人就沒太多機會練手。 這是個死循環。 就像論文裡面說的: > 我們訓練操作員依照指示行事,然後把他們放進系統,指望他們提供智慧。 你不能指望平常不需要怎麼思考和練習的人類,在關鍵時刻能想出什麼好辦法。 4. 監控疲勞:人類無法長時間對"很少出錯"的系統保持警覺 心理學研究早就發現,人類無法對一個很少出問題的目標保持長時間警覺,半小時是極限。這不是意志力的問題,這是由生理結構決定的。 從演化角度看,這其實是個生存優勢:如果你盯著一個地方什麼都沒發生,大腦會自動降低警覺,把注意力資源省下來應對真正的威脅。但放到監控場景裡,這就成了問題。 AI Agent大部分時候是對的,偶爾會犯錯。這恰好是最難監控的模式。如果它經常出錯,你會保持警惕。如果它從不出錯,你就不用監控。但它很少出錯這種情況,正好落在人類注意力的盲點裡。 更糟的是,AI Agent犯錯的方式特別隱密。它不會說"我不確定",它會用一種極其自信的語氣告訴你它的計劃,洋洋灑灑幾十上百行。錯誤可能藏在第87行的一個小前提裡,例如"因為2大於3,所以我們應該…"。被那麼多看起來正確的內容包裹著,被那種自信滿滿的語氣麻痺著,你很難注意到。 那加個自動警報系統呢? 論文說:誰來監控警報系統?如果警報系統本身出了問題,操作員不會注意到,因為警報系統已經正常運作很久了。 那讓人做紀錄呢? 論文說:人可以機械地抄數字而完全沒注意到數字是什麼。 所有試圖對抗監控疲勞的手段,都會撞上同一面牆:人類的注意力就是無法長時間鎖定在一個很少出事的目標上。這是硬體限制,不是軟體問題。 5. 地位問題:從專家降級為監工,心理衝擊和社會地位下降 你曾經是專家,公司裡有什麼難題找你,同事尊重你,你自己也有職業認同。現在你是AI的看門人。 技能層面的損失是一回事,心理層面的衝擊又是另一回事。從專家降級為監工,從創造者變成審核員,從被需要變成備胎。這種轉變對很多人來說是很難接受的。 論文裡說,被這樣降級的人會出現各種複雜的應對反應,有些看起來甚至是自相矛盾的。這部分內容展開講太長,有興趣的可以去讀原論文。 6. 糟糕的UI:目前AI Agent介面是最糟糕的監控設計 工業自動化領域花了幾十年優化控制室設計:顯示器怎麼佈局能讓操作員最快發現異常,急停按鈕為什麼是紅色的、為什麼那麼大、為什麼放在那個位置。每一個細節都是用事故和教訓換來的。 現在看看AI Agent的介面? 一堆自信滿滿的長文本,一個接一個的多步驟計劃,幾十上百行洋洋灑灑的解釋。你要在這些文字裡找出那個藏著的錯誤。 這大概是人類設計過的最糟糕的異常檢測介面。 7. 訓練悖論:越成功的自動化系統,越需要投資訓練人類 論文中談到自動化帶來的訓練問題: > 如果不能讓操作員定期接手工作親自幹,就得用模擬器訓練。但模擬器有個根本問題:你只能模擬你能預見的故障。未知的故障模擬不出來,已知但沒經歷過的故障也很難準確模擬。 那怎麼辦? > 只能訓練通用策略而不是具體因應方法。但這又帶來新問題:你不能指望操作員光靠查操作手冊來應對異常,因為手冊不可能涵蓋所有情況。 > 越是成功的自動化系統,越少需要人工幹預,反而越需要在人員訓練上投入大量資金。 因為介入越少,人的技能退化越快,應對罕見異常的能力越弱,每次訓練的成本就越高。 決策者想用AI省錢,但省下的人力成本可能得加倍投入到訓練成本。 8. 領導困境:監督AI不只是被動看,還要主動"領導"它們 監督AI Agent不只是被動地盯著看,還得主動指揮它們。告訴它們做什麼、不做什麼、分幾步做、怎麼調整方向。 這其實是一種領導技能。 為什麼LinkedIn上誇AI Agent最起勁的往往是管理者?因為他們本來就習慣間接工作:設定目標、分配任務、給回饋、調方向,但不親自動手。對他們來說,指揮AI Agent和指揮下屬沒有本質區別。 但對於一直親自工作的執行者來說,這是一個巨大的角色轉換。你得從一個做事的人,變成一個讓別人做事的人。這不是改幾條prompt就能解決的,這是一整套技能係統的重建。 公司會給新晉經理做領導力培訓。但有誰看過公司給AI監督者做領導力培訓? 四十年前那篇論文的結尾是這樣的: > 沒有時間壓力時,人類可以是令人印象深刻的問題解決者。困難在於,一旦有時間壓力,效率就會大打折扣。我希望這篇論文說清楚了兩件事:第一,自動化不一定會消除困難,這是諷刺所在;第二,解決這些問題所需的技術創造力,可能比自動化本身還要大。 四十年後,我們換了個場景,但面對的是同一組問題。 AI Agent的能力正在進步,但人類的認知結構沒變。監控疲勞還是半小時,技能退化還是用進廢退,注意力盲區還在那裡。這些是硬體限制,不是軟體更新能解決的。 推薦閱讀原文: 《Ironies of Automation》:https://t.co/5HWoelLIkR 《AI and the ironies of automation - Part 1》 https://t.co/u27fpcCOWk 《AI and the ironies of automation - Part 2》

正在載入線程內容

正在從 X 取得原始推文,整理成清爽的閱讀畫面。

通常只需幾秒鐘,請稍候。