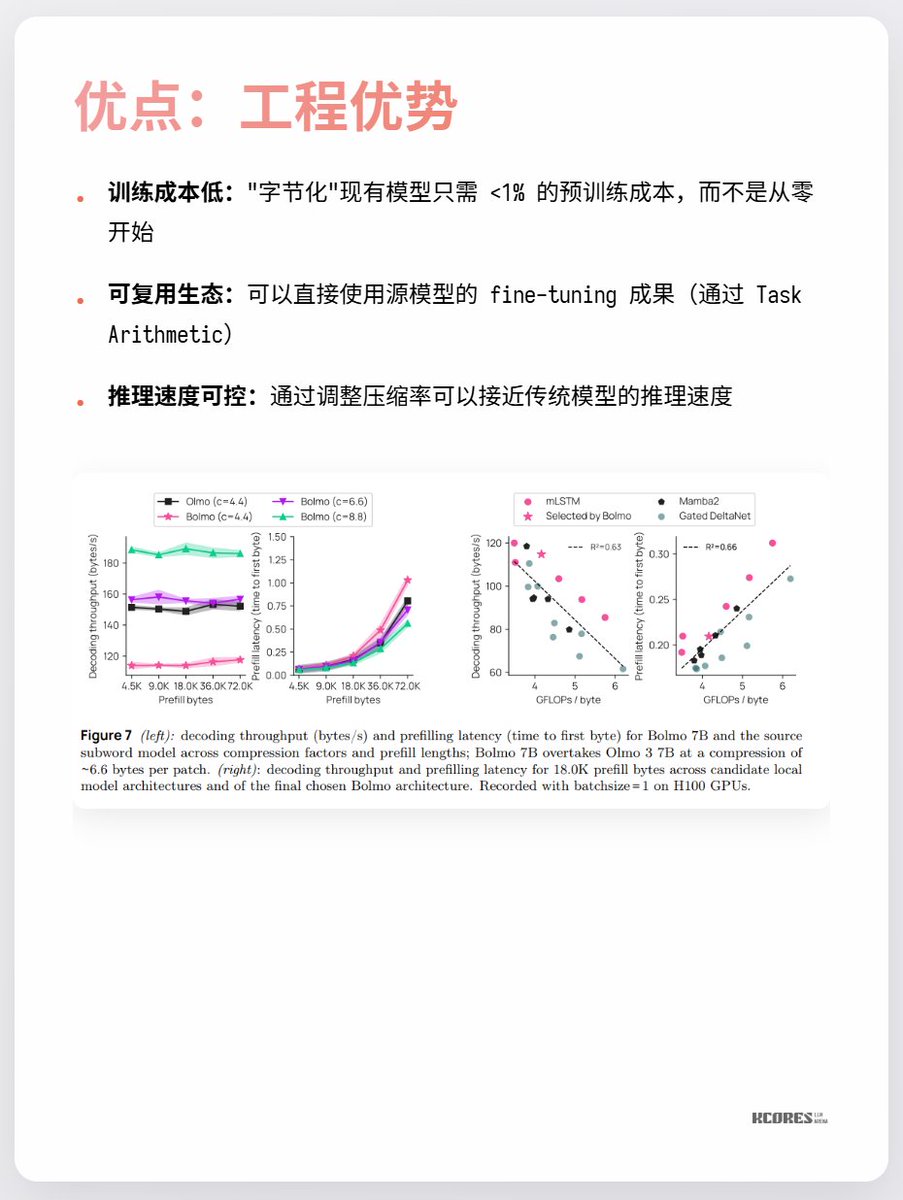

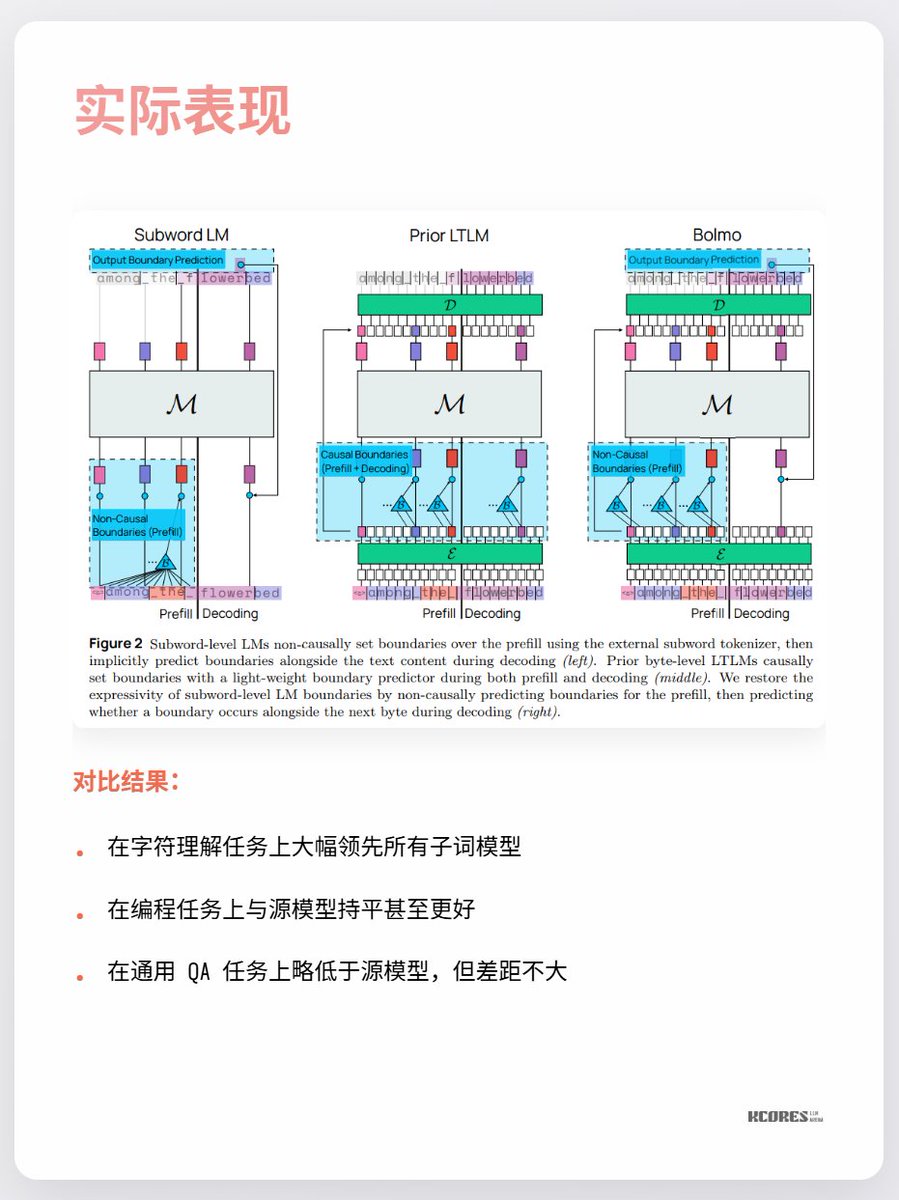

而Bolmo 這個模型取了個巧,他不是從0訓練的,而是把現有的模型"字節化", 它內置了個Local Encoder/Decoder, 將字節序列壓縮成"潛在token",再送入傳統Transformer 處理。這樣只需要少量的成本就能轉換了。

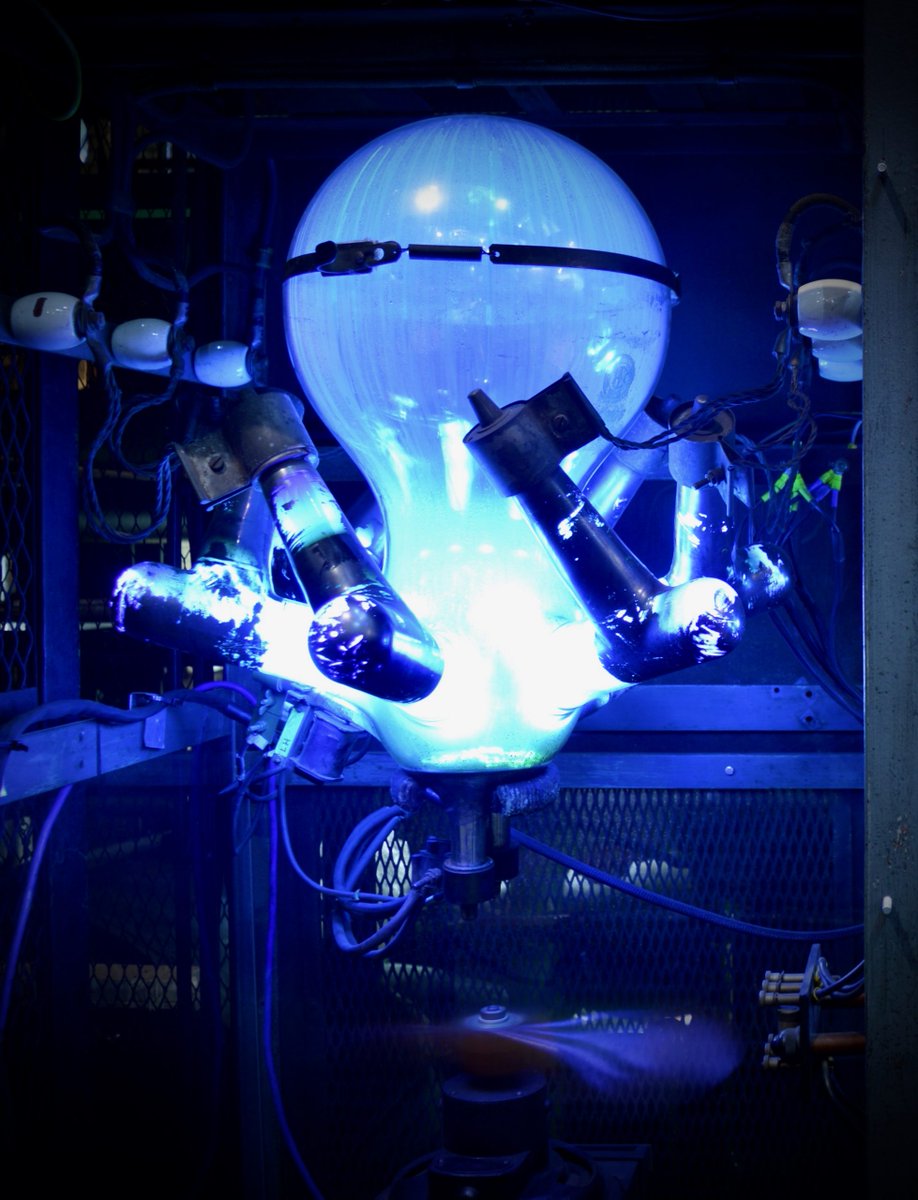

目前大家最大的爭議還是,看不到太大的受益,以及,更長的序列意味著更多的KV Cache,顯存壓力更大。以及,只有在字符理解這個單一任務上大幅領先,其它任務沒太大亮點。 總之可以持續關注下。科技爆發時期的螺旋探索總是很有趣的,像是我就比較喜歡水銀整流器(最後一張圖),但是現在都被IGBT取代了。