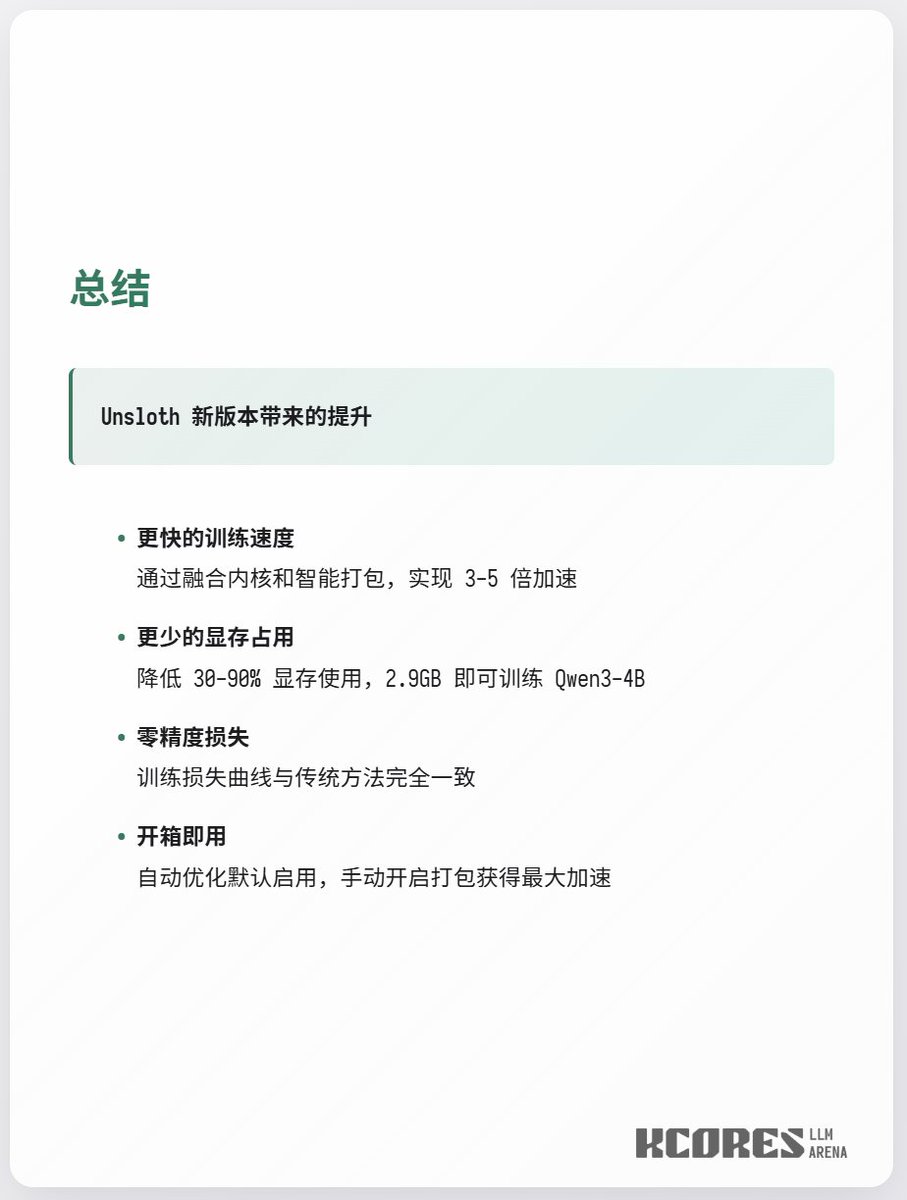

unsloth 又發力了, 3GB 顯存訓練Qwen3-4b unsloth 最新的更新提升巨大, 簡單來說, 他們把原本Q和K各自需要的2個Triton內核合併為1個,並支持可變長度RoPE, 這樣可以很大程度上節省顯存和提升計算速度(原本Q和K需要兩個Triton Kernel計算,現在合併為了一個), 在長上下文訓練上實現了2.3x的訓練速度加速. 另外也支持了int64索引, 因為原來的int32索引在500K這種超大上下文訓練中會導致CUDA越界錯誤, 於是換了更大的精度來避免越界, 這樣就支持更大上下文了.

實作細節/1

實作細節/2

如何使用