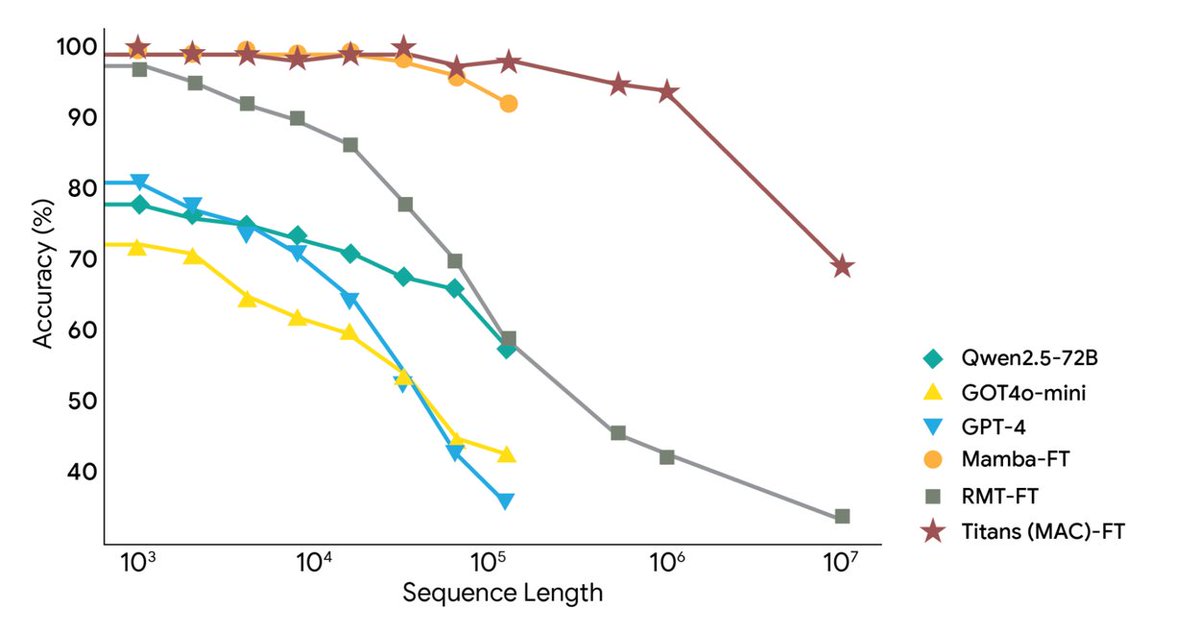

Google Research今天發布了全新框架:Titans架構和MIRAS框架,解決AI超長上下文和長期記憶力問題,把上下文拉到了超200萬token 它以深度神經記憶進行即時學習,讓大模型在跑起來的同時即時更新自身長時記憶,來實現RNN速度+Transformer精度 Titans,讓AI運行時即時更新其長時記憶模組 MIRAS,提供統一記憶系統的理論藍圖 Titans把長時記憶做成一個多層感知機(MLP),而不是傳統RNN的固定向量,每讀一個新詞,先算“驚訝度”,平平無奇就略過,反之就寫進長時記憶並同步更新MLP的參數 為了控制容量還加了weight decay,不重要的舊資訊自動淡出 最終,Attention層可以「按需」去查長時記憶,也可以只看最近上下文 MIRAS 提供了一個統一的視角,它認為主流序列模型本質上都是在解決同一個問題,如何高效地把新資訊和舊記憶結合起來,同時又不會忘記重要的東西,它們都是不同形式的「關聯記憶」系統 它把一個AI模型的記憶系統拆解成記憶結構、注意力偏移、保留門、記憶演算法四個關鍵部分 並且提出用更複雜、更精妙的數學方法來做判斷,這樣就能設計出更強大,魯棒性更高的記憶系統 實驗顯示,Titans在語言建模、常識推理、DNA建模、時間序列預測及2M token的BABILong任務上,優於同等規模的Transformer++、Mamba-2、Gated DeltaNet,甚至超過GPT-4 #AI記憶力#Titans

正在載入線程內容

正在從 X 取得原始推文,整理成清爽的閱讀畫面。

通常只需幾秒鐘,請稍候。