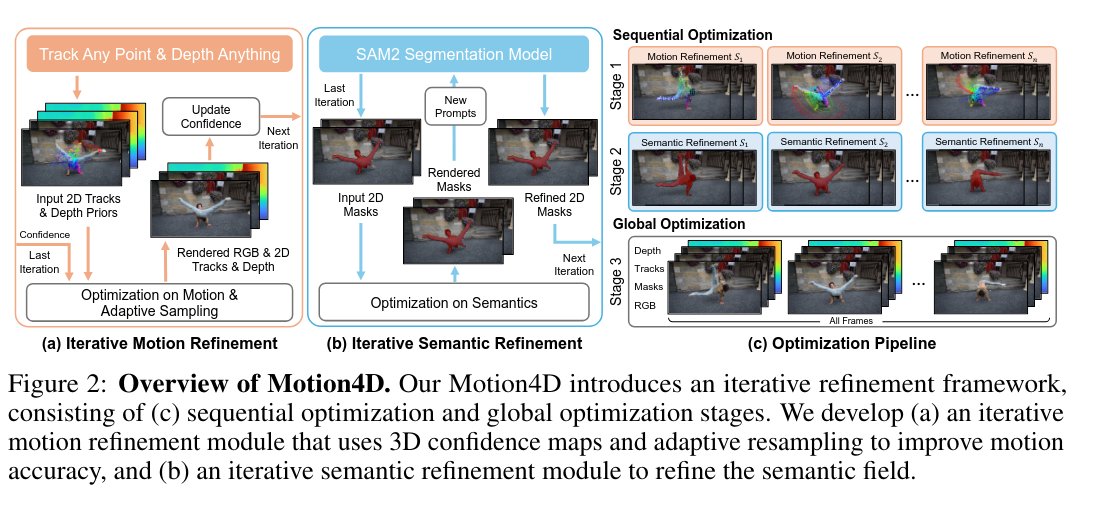

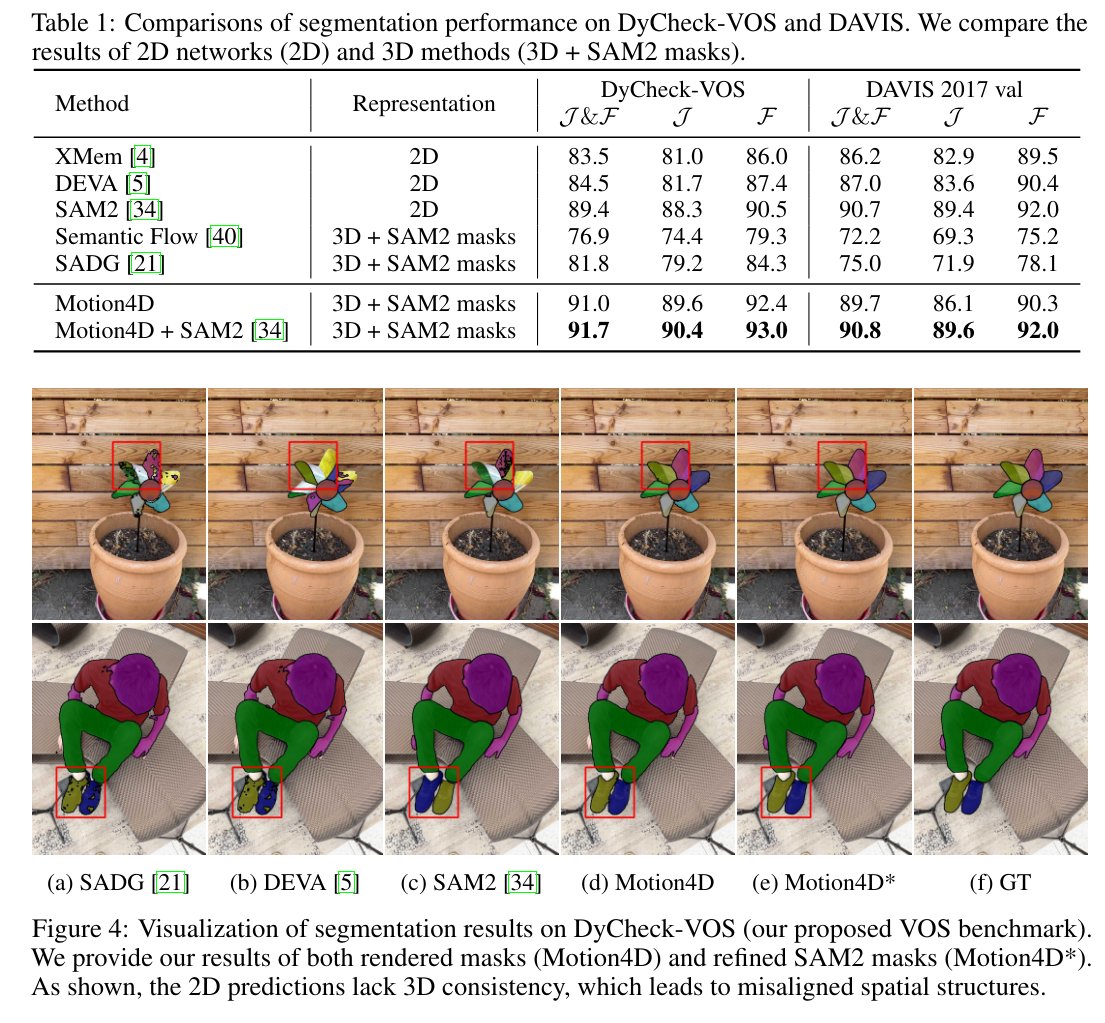

Motion4D:學習與 3D 一致的運動和語義以實現 4D 場景理解 貢獻: • 我們提出了 Motion4D 模型,該模型將基礎模型中的 2D 先驗資訊整合到動態 3D 高斯散射表示中。這實現了從單眼影片中一致地進行運動和語義建模。 • 我們設計了一個包含以下兩部分的迭代最佳化框架: - 順序最佳化,在連續階段更新運動和語義場,以保持局部一致性。 - 全域最佳化,它對所有屬性進行聯合最佳化,以確保長期一致性。 • 我們引入了使用 3D 置信度圖和自適應重採樣的迭代運動細化來增強動態場景重建,同時引入了語義細化來透過 SAM2 的迭代更新來修正 2D 語意不一致。 • 我們的 Motion4D 在視訊物件分割、基於點的追蹤和新視角合成等任務中,效能顯著優於 2D 基礎模型和現有的 3D 方法。

論文連結:htarxiv.org/abs/2512.03601案連結:https://t.co/SEmM7IIDB5