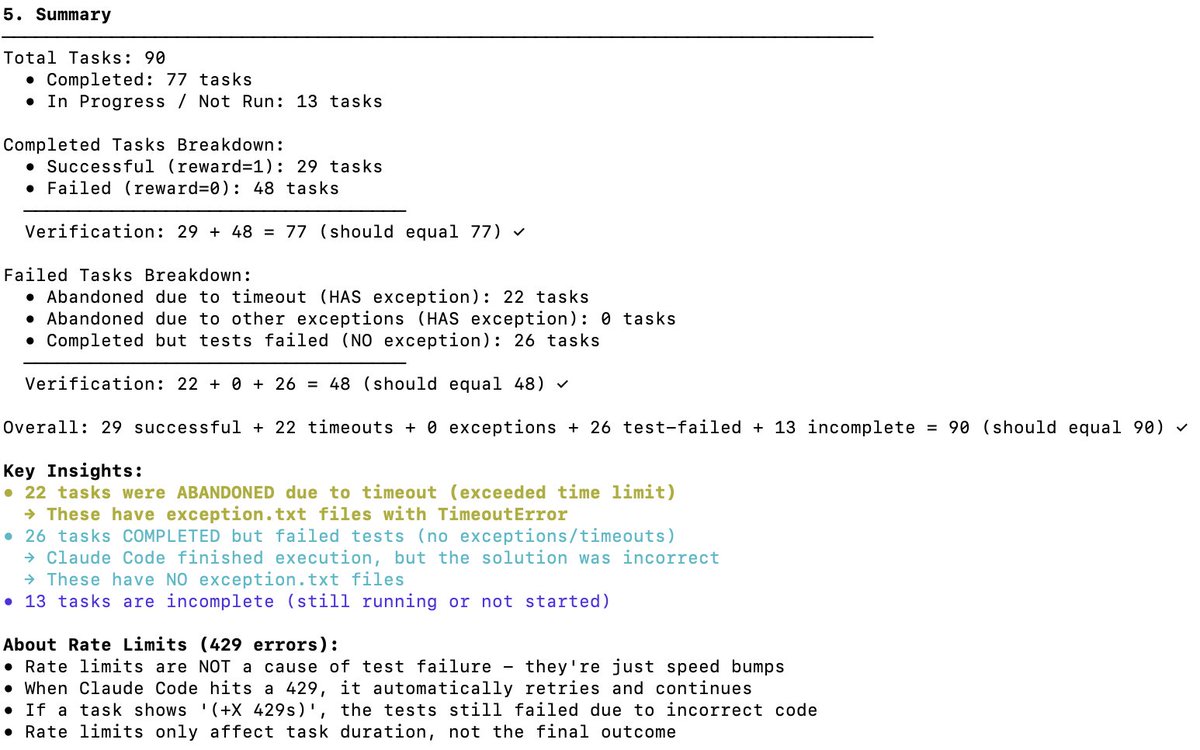

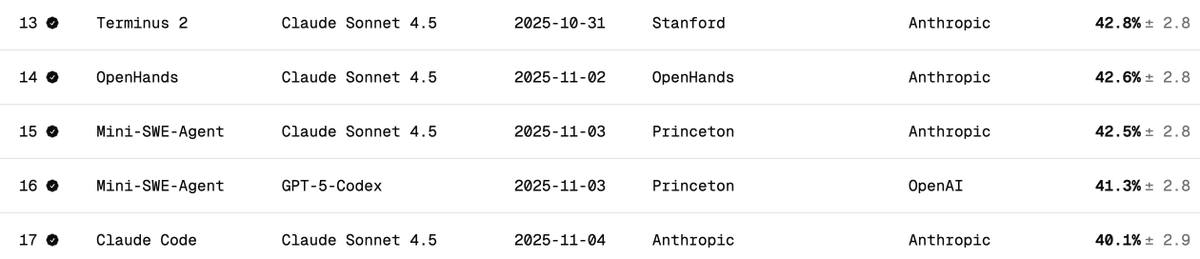

獨立驗證DeepSeek V3.2在Terminal Bench 2上的效能 終端基準測試用於衡量模型在終端場景(例如 Claude Code、Codex CLI、Gemini CLI)中支援/運行代理程式的能力。在我看來,這是人工智慧軟體開發中最重要的邏輯邏輯基準測試。它涉及人工智慧如何操作您的命令列介面 (CLI) 來下載軟體、開發程式碼、進行測試等等。 官方比數是多少? 如下表所示,DeepSeek v3.2 的官方得分分別為 46.4(思考型)和 37.1(非思考型)。他們使用了論文中提到的 Claude Code 測試框架。 Claude Code + Sonnet 4.5 在此基準測試中的表現如何? 以下是 Claude Sonnet 4.5 在不同安全帶上的終端測試得分。請注意,Claude Code 安全帶的得分約為 40%。 使用 Claude Code Harness 運行 DeepSeek V3.2 的得分是多少? 我使用 DeepSeek-Reasoner(Thinking)進行了測試。在近 90 次測試中,Harbor(編排器)停止工作前運行了 77 次。假設這些樣本是無偏的,那麼 77 這個數字就足以說明問題: - 29 - 成功 - 48 - 失敗(22 次逾時 + 26 次產生錯誤代碼) 這使得得分達到 38%(相當不錯,已經接近 Claude Code + Sonnet 4.5 的 40%)。 但可以肯定的是,如果給 DeepSeek v3.2 模型更多時間,它肯定能完成更多超時任務,完成率會遠高於 38%——我認為可以達到 50%。但那就不是公平的比較了(測試創建者建議不要更改超時設定)。 與其他開源軟體模型的比較: 以下型號使用 Terminus 2 線束 1. Kimi K2 思考 - 35.7% 2. MiniMax M2 - 30% 3. Qwen 3 Coder 480B - 23.9% 結論: 對於開源軟體模型而言,其性能達到了 SOTA 水平,令人難以置信的是,它幾乎與 Claude 4.5 相當,然而,我的得分低於 DeepSeek 團隊的得分:46.4(再次強調,最後 13 次測試沒有運行)。 我懷疑他們可能修改了 Claude 程式碼的行為。 Claude 程式碼會以特定的方式(例如作為)提示模型,而 DeepSeek v3.2 可能不熟悉或無法很好地處理這些方式。 很高興得知 DeepSeek 有 Anthropic API 接口,這讓使用 Claude Code 進行測試變得非常順利。我只需要把 settings.json 檔案放到 Docker 容器裡就行了。 DeepSeek (@deepseek_ai) 應該公開透明地分享他們是如何取得這些分數的。 成本與緩存命中率: 最不可思議的是,運行這 77 個測試只花了 6 美元(Harbor 不知何故放棄了最後 13 個測試)。雖然處理了近 1.2 億個令牌,但由於大部分令牌都是輸入的,並且之後都透過快取命中(DeepSeek 自動實現了基於磁碟的快取),所以成本非常低。 向 Terminal Bench 團隊提出請求: 請簡化恢復未完成任務就已終止的工作的流程。感謝您提供的這項卓越服務。 @terminalbench @teortaxesTex @Mike_A_Merrill @alexgshaw @deepseek_ai

正在載入線程內容

正在從 X 取得原始推文,整理成清爽的閱讀畫面。

通常只需幾秒鐘,請稍候。