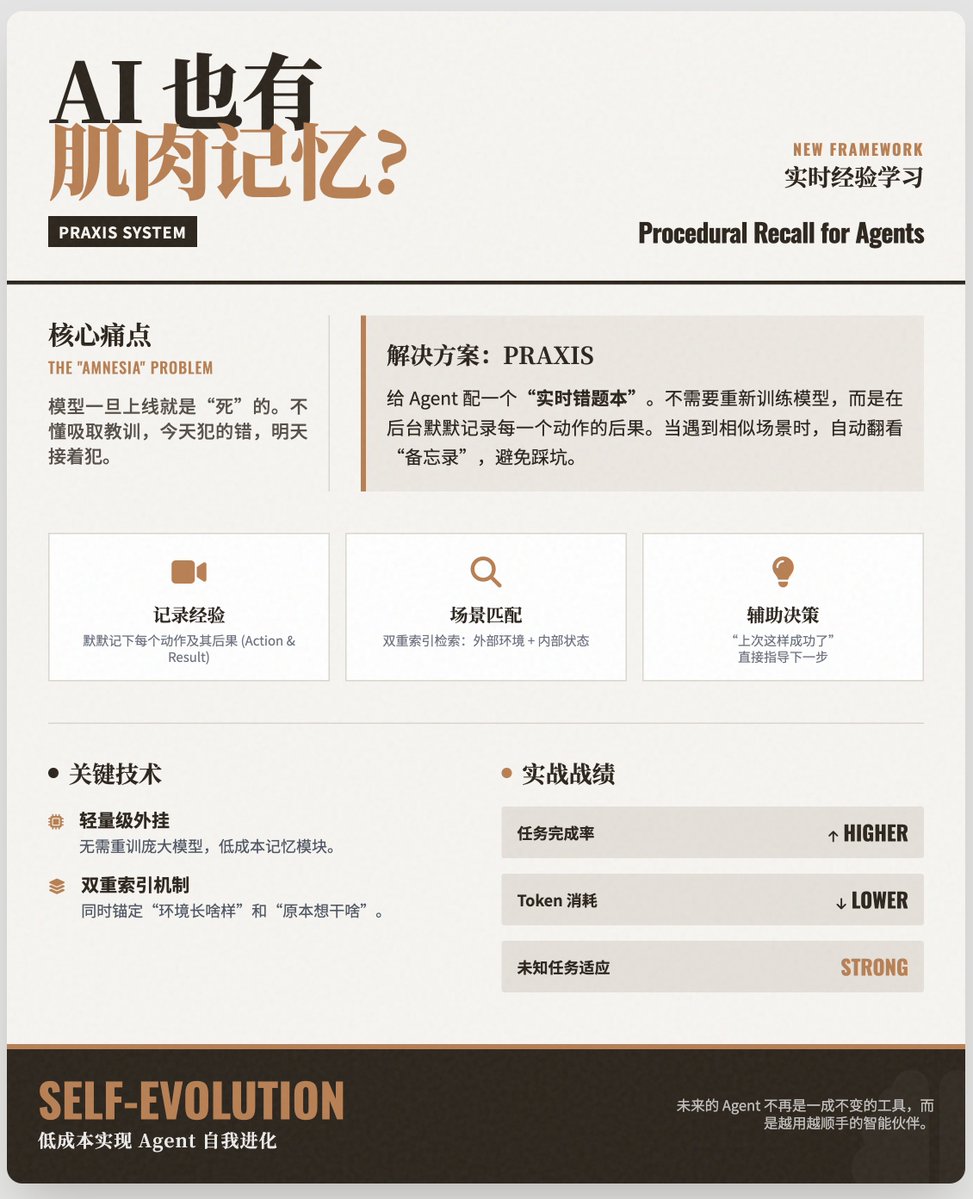

為AI 裝上「肌肉記憶」:如何透過「狀態索引經驗」讓Agent 在即時過程中學習、越用越聰明? 核心痛點:AI Agent 的“健忘症” 目前的AI Agent 雖然很聰明,但它們通常有一個致命弱點:在部署後無法學習。 · 模型是「死」的:一旦模型訓練完成並上線,它的知識就固定了。 · 不明白學習:如果一個Agent 今天在某個複雜的網頁上操作失敗了,明天它遇到同樣的網頁,可能還會犯同樣的錯誤。 · 缺乏「肌肉記憶」:人類透過「試誤」來掌握技能(過程性知識),而AI Agent 往往缺乏這種從即時經驗中累積技巧的機制。 解決方案:PRAXIS 系統為了解決這個問題,作者提出了一個名為PRAXIS(Procedural Recall for Agents with eXperiences Indexed by State)的新機制。 我們可以把PRAXIS 想像成Agent 的「即時錯誤」或「經驗備忘錄」: · 記錄經驗:當Agent 執行任務時,PRAXIS 會在後台默默記錄它的每一個動作及其後果。 · 場景配對:當Agent 再次遇到類似的場景(環境狀態+ 內部狀態)時,PRAXIS 會快速檢索過去的經驗。 · 輔助決策:它會告訴Agent:“嘿,上次在這個介面點擊這個按鈕成功了(或失敗了)”,從而直接指導Agent 做出更優選擇。 關鍵技術點· 輕量級外掛:PRAXIS 不需要重新訓練龐大的大模型,它更像是外掛的記憶模組,成本很低。 · 雙重索引:它不僅看外在環境(例如網頁長什麼樣子),還看Agent 的內部狀態(例如目前的計畫是什麼),從而確保經驗匹配的精準度。 實驗結果:Web 瀏覽任務的大勝研究團隊在REAL Web Browsing Benchmark 上進行了評估,結果顯示: · 任務完成率更高:裝備了PRAXIS 的Agent 能夠更準確地完成複雜的網頁任務。 · 更省錢:因為少走彎路,減少了無效的嘗試步驟,Token 消耗和運行成本顯著降低。 · 適應性強:對於那些沒看過的任務,只要環境相似,Agent 也能透過類比過去的經驗來解決問題。 產業啟示與總結這篇論文提出了一種低成本讓AI Agent 實現「自我進化」 的路徑。 · 告別「一次性」智能:未來的Agent 將不再是一成不變的工具,而是越用越順手、越用越聰明的助手。 · 應對動態環境:特別是在網頁瀏覽、軟體操作等介面經常變動的場景下,PRAXIS 這種機制讓Agent 能夠像人類一樣快速適應新版本的UI,而不需要等待模型廠商發布新版本。 論文

正在載入線程內容

正在從 X 取得原始推文,整理成清爽的閱讀畫面。

通常只需幾秒鐘,請稍候。