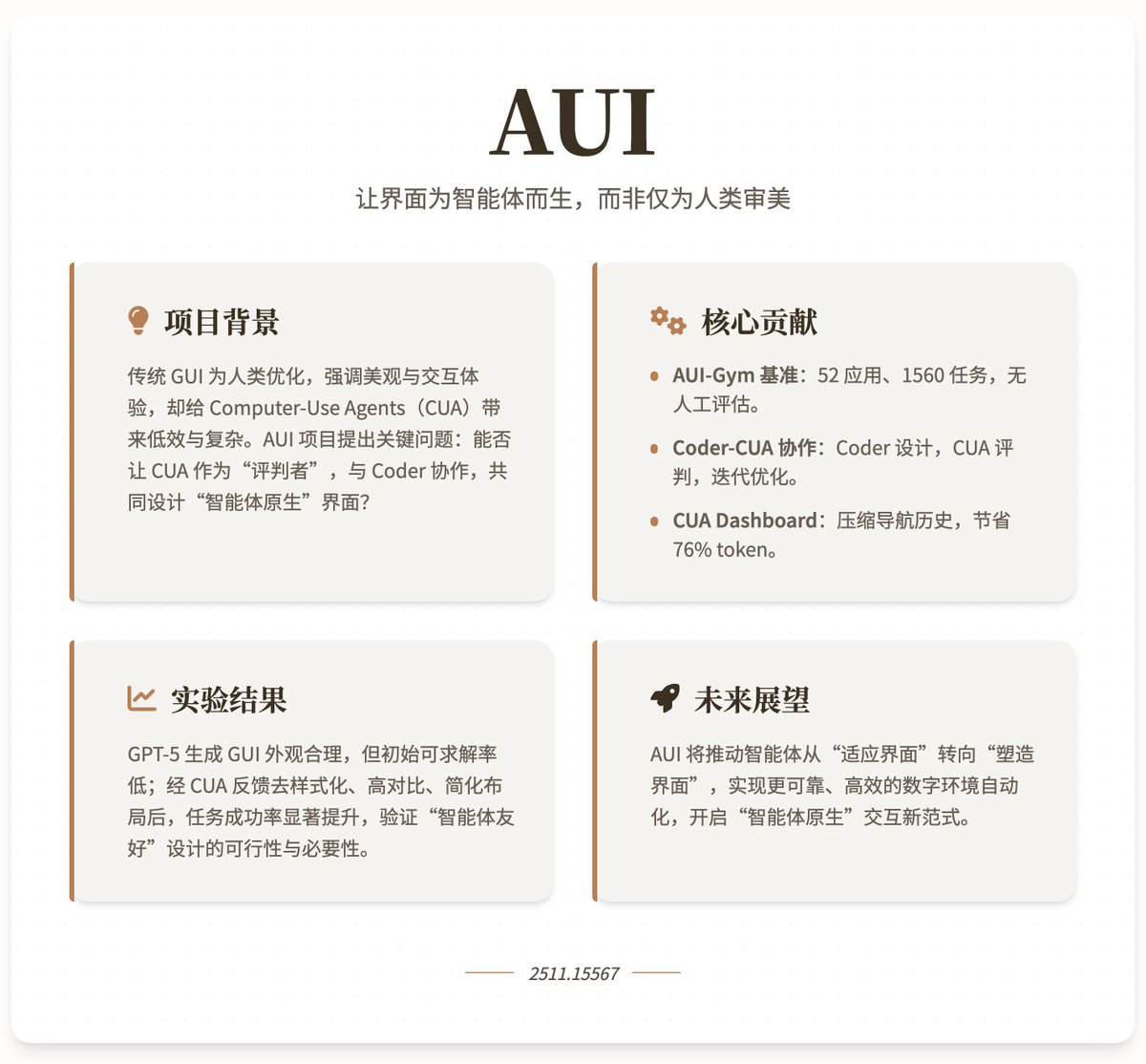

Gemini 3.0 Pro 和Claude Opus 4.5 產生UI 的能力繼續升級,前端還有活路嗎😂 開玩笑😄,AI 模型生成UI 這麼牛,對人很友好,可是它們生成的UI 對AI Agent 友好嗎? 來自牛津大學、新加坡國立大學和微軟的最新研究“AUI”,就是在探索如何利用Computer-Use Agents (CUA) 和編碼語言模型來自動化生成和優化GUI,使介面更適合智能體而非人類的使用。 專案背景與動機傳統GUI 主要為人類優化,強調美觀、易用性和視覺吸引力(如動畫和彩色佈局),這導致CUA 在操作時必須模仿人類行為,增加了複雜性和低效性。隨著程式語言模型在自動產生功能性網站方面的進步,AUI 專案提出一個關鍵問題:能否讓CUA 作為「評判者」協助Coder 自動設計GUI?這種協作旨在創建「智能體原生」的介面,優先考慮任務執行效率而非人類美學。透過智能體的回饋,專案希望實現更可靠、更有效率的數位環境自動化,推動智能體從被動適應到主動塑造環境的轉變。 核心貢獻 1. AUI-Gym 基準測試平台:這是一個專為自動GUI 開發和測試設計的基準,涵蓋52 個應用程序,分佈在6 個領域(App、Landing、Game、Interactive、Tool 和Utility)。專案使用GPT-5 產生1560 個模擬真實場景的任務(每個應用30 個),並透過手動驗證確保品質。這些任務強調功能完整性和互動性,例如在「Micro Habit Tracker」應用程式中建立習慣並查看圖表。每個任務配備一個基於規則的驗證器,透過JavaScript 檢查任務是否在給定介面中可執行,從而實現無人工幹預的可靠評估。基準的指標包括: · 功能完整性(Function Completeness, FC):評估介面是否支援任務(即是否存在功能檢查器),以基礎可用性衡量。 · CUA 成功率(Success Rate, SR):評估CUA 在導航任務時的平均完成率,反映實際執行效率。 2. Coder-CUA 協作框架:框架將Coder(程式語言模型) 定位為“設計師”,負責初始化和迭代修訂GUI;CUA 則作為“評判者”,透過任務求解性和導航回饋提供指導。具體流程: · Coder 從使用者查詢(包括名稱、目標、功能和主題)產生初始HTML 網站。 · CUA 測試網站:首先驗證任務可求解性(收集不可行任務作為功能回饋),然後執行導航(透過點擊、輸入等原子動作)。 · 回饋循環:不可求解任務彙總為語言總結供Coder 改進功能;導航軌跡透過CUA Dashboard 壓縮為視覺回饋,幫助Coder 優化版面配置。 3. CUA Dashboard:用於將CUA 的多步驟導航歷史(包括截圖、動作和結果)濃縮成單張1920×1080 影像。透過自適應裁剪關鍵互動區域,平均減少76.2% 的視覺tokens,同時保留必要線索(如任務目標、步驟和失敗點)。這使得回饋更易解釋,便於Coder 識別問題(如低對比或複雜佈局)並進行針對性修訂,例如去除樣式、提升對比或簡化結構。 實驗結果實驗顯示,先進Coder(如GPT-5)能產生外觀合理的GUI,但初始功能完整性較低(許多任務不可求解),透過失敗回饋可快速提升。 CUA 導航是主要瓶頸,即使功能完整,初始成功率也較低;但透過協作迭代(如去樣式化、高對比和簡化佈局),成功率顯著提高,證明智能體回饋能增強GUI 的穩健性和效率。專案強調,智能體偏好簡潔、功能導向的介面,而非人類式的視覺複雜性。 研究計畫地址

正在載入線程內容

正在從 X 取得原始推文,整理成清爽的閱讀畫面。

通常只需幾秒鐘,請稍候。