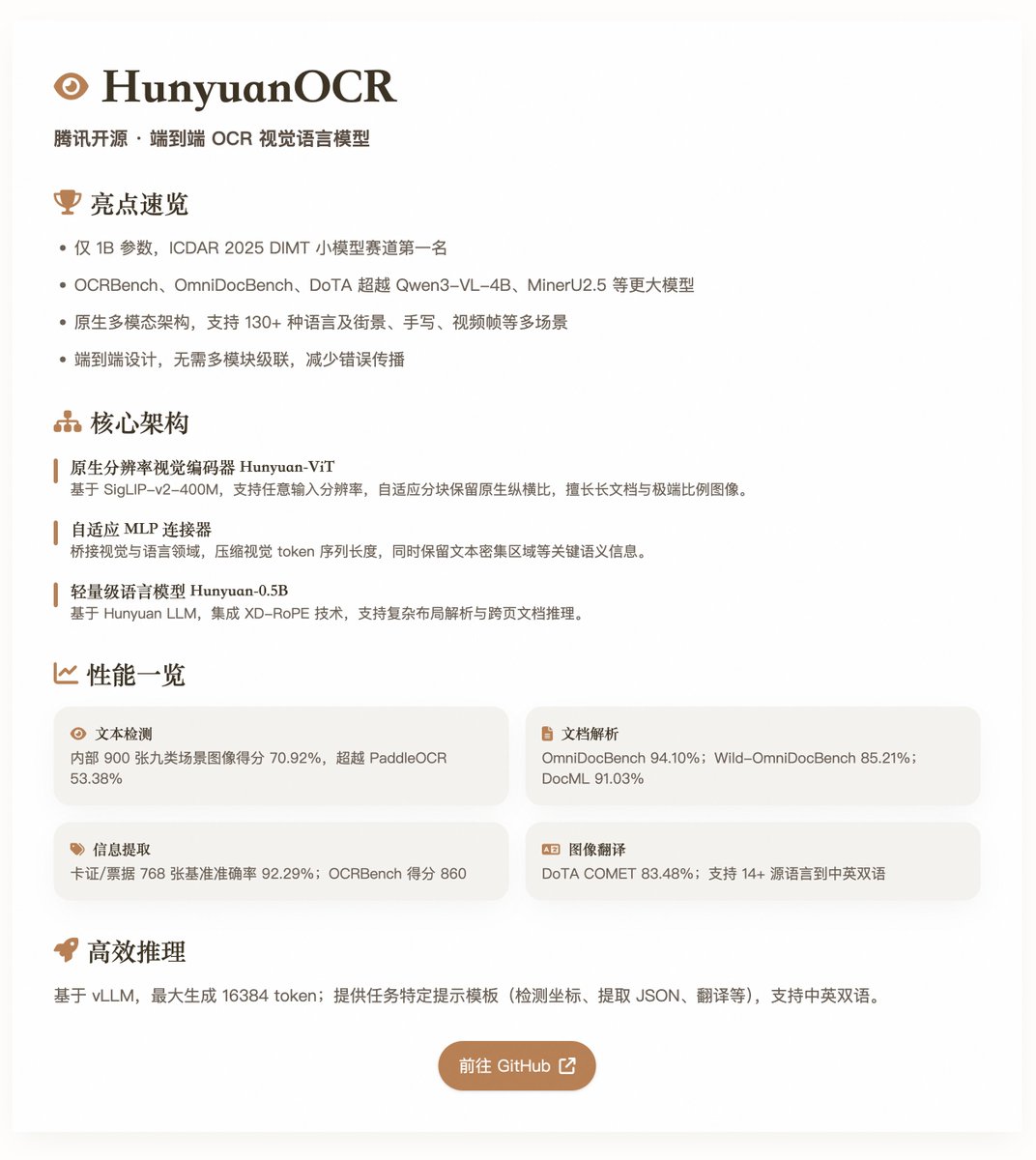

HunyuanOCR:騰訊開源的端對端OCR 視覺語言模型 HunyuanOCR 參數規模僅1B,卻在多項OCR 基準測試中達到了領先水準。它基於原生多模態架構,專為OCR 任務優化,適用於文字偵測、文件解析、資訊擷取、視覺問答和文字影像翻譯等場景。模型在ICDAR 2025 DIMT 挑戰賽(小模型軌道)中獲得第一,並在OCRBench、OmniDocBench 和DoTA 等基準上超越了許多更大規模的模型,如Qwen3-VL-4B 和MinerU2.5。 核心特性和架構 HunyuanOCR 採用純端對端視覺語言模型設計,避免了傳統OCR 系統中的多模組級聯,從而減少了錯誤傳播和維護成本。其架構包括三個主要組件: · 原生解析度視覺編碼器(Hunyuan-ViT):基於SigLIP-v2-400M 預訓練模型,參數約0.4B,支援任意輸入解析度。透過自適應分塊機制保留影像原生縱橫比,擅長處理長文件、極端比例影像和低品質掃描件。 · 自適應MLP 連接器:作為視覺與語言領域的橋樑,進行空間維度的內容壓縮,減少視覺token 序列長度,同時保留關鍵語義訊息,如文字密集區域。 · 輕量級語言模型(Hunyuan-0.5B):基於Hunyuan LLM,參數約0.5B,整合XD-RoPE 技術,將RoPE 分解為文字、高度、寬度和時間四個子空間,支援複雜佈局解析和跨頁文件推理。 模型支援多任務統一建模,透過自然語言指令(如「偵測並識別圖片中的文字」)完成從感知到語義的任務,無需額外預處理模組。它涵蓋多語言(130+ 種,包括低資源語言)和多場景(如街景、手寫、視訊畫面),並在訓練中強調高品質應用對齊資料和強化學習(RL)優化,提升了複雜場景下的穩健性。 訓練與資料建構(兩分鐘) · 預訓練階段:分四步驟進行,總計約454B token。包括視覺語言對齊、多模態預訓練、長上下文擴展(至32K token)和應用導向監督微調。數據混合了開源數據集、合成元素級數據和端到端應用數據,總計約2 億高品質樣本,涵蓋街景、文件、手寫等九大場景。 · 後訓練階段:使用線上強化學習演算法GRPO,結合任務特定獎勵機制(如rule-based 和LLM-as-a-judge)。這顯著提升了模型在文件解析和翻譯等挑戰任務上的準確性和穩定性。 資料管道強調合成與增強:擴展SynthDog 框架產生多語言長文檔,支援RTL 佈局和複雜字體;引入扭曲合成管道模擬真實缺陷(如模糊、扭曲、照明變化);自動化QA 生成管道復用跨任務樣本,確保多樣性和品質。 效能評估· 文字偵測(Spotting):在內部900 張影像基準(九類場景)上得分70.92%,優於PaddleOCR (53.38%) 和Qwen3-VL-235B (53.62%)。 · 文件解析(Parsing):在OmniDocBench 上整體得分94.10%,文字編輯距離0.042;Wild-OmniDocBench(真實捕捉場景)得分85.21%;DocML(多語言)得分91.03%。 · 資訊提取與VQA:在768 張卡證/票據基準上準確率92.29%;視訊字幕提取92.87%;OCRBench 得分860。 · 文字影像翻譯:支援14+ 源語言到中/英,在DoTA 上COMET 得分83.48%,在DocML 上73.38%(其他到英)/73.62%(其他到中)。 這些結果突顯了模型在輕量級下的高效性,尤其在真實世界場景中超越了模組化VLM 和傳統管道。 @vllm_project 支援高效推理,最大生成16384 token。報告提供了任務特定提示模板,如檢測座標、提取JSON 或翻譯,支援中英雙語。 開源模型:

正在載入線程內容

正在從 X 取得原始推文,整理成清爽的閱讀畫面。

通常只需幾秒鐘,請稍候。