#1 基於表徵的語言模型探索:從測試階段到訓練後階段 連結 - https://t.co/NSxfgxeTX4 我們使用強化學習來改進模型,但本質上我們只是在強化基礎模型已經知道的東西,很少arxiv.org/abs/2510.11686索,推動模型嘗試不同的解決方案,而不僅僅是同一個解決方案的更自信的版本。 主要查詢: LLM 的內部表徵(隱藏狀態)能否引導探索? 刻意探索能否讓我們超越簡單的磨練?

#2 - 假設你想向你的視訊串流管理器(VLM)提供無限的視訊串流,你會如何防止它們崩潰? 連結 - https://t.co/b0KulnGDS1 對所有歷史幀的完全關注是二次方的,最終會導致延遲和記憶體消耗爆炸性增長。幾分鐘後,arxiv.org/abs/2510.09608降。滑動視窗勉強能保持局部完整性,但全域註解功能會變得非常糟糕。他們將 Qwen2.5-VL-Instruct-7B 微調成一個新的模型 StreamingVLM,並配上對應的推理方案和資料集。其核心設計理念是:將訓練與流式推理同步,而不是在推理時添加鍵值對驅逐啟發式演算法。其設計的關鍵組成部分包括:流感知鍵值快取、連續 RoPE、重疊式全注意力訓練策略以及串流專用資料。這是一篇非常棒的論文,值得專門討論。

#3 - 這是思考還是作弊?透過測量推理努力來檢測隱性獎勵作弊 連結 - https://t.co/z2RUEQZuOl 模型通常會獎勵走捷徑的駭客行為。 有時候,作弊手段在思路鏈(CoT)中顯而易見,也就arxiv.org/abs/2510.01367有時候,作弊則是隱性的獎勵機制漏洞。思路鏈看起來合情合理。 該模型實際上走了捷徑(例如,使用洩漏的答案、漏洞或 RM 偏差),但卻用虛假的解釋掩蓋了這一點。 如果模型作弊,它只需要極少的「真正」推理就能獲得高額獎勵。因此,作者建議,與其閱讀並相信模型的解釋,不如衡量一下,如果強制模型提前回答,它能多早獲得獎勵。 他們將這種方法稱為 TRACE(截斷推理 AUC 評估)。

#4 - 量化增強的LLM強化學習 連結 - https://t.co/yGkbqg1kVk 代碼 - https://t.co/varxiv.org/abs/2510.11696該如何在強化學習github.com/NVlabs/QeRL什麼應該使用量化」。 QERL 使用 NVFP4 4 位元量化,令人驚訝的是,它透過利用量化雜訊來增強探索能力。如圖 4 和圖 5 的熵曲線所示,這種雜訊使模型的輸出分佈趨於平坦並提高了熵。 為了使這種噪聲在整個訓練過程中有用,作者添加了自適應量化噪聲,即透過 RMSNorm 注入的高斯擾動(圖 6)。 這樣既能達到全精度等級的推理質量,又能使用約 25-30% 的內存,並且能將 RL 迭代速度提高 1.2-2 倍,甚至允許在單個 H100 上訓練 32B 模型。 結果似乎與全參數強化學習相符。 值得深入研究。

#5 - 如何計算您的 MFU? 連結 - https://t.co/Ve9Cgithub.com/karpathy/nanoc…r 在 nanochat 上進行了一場精彩的討論

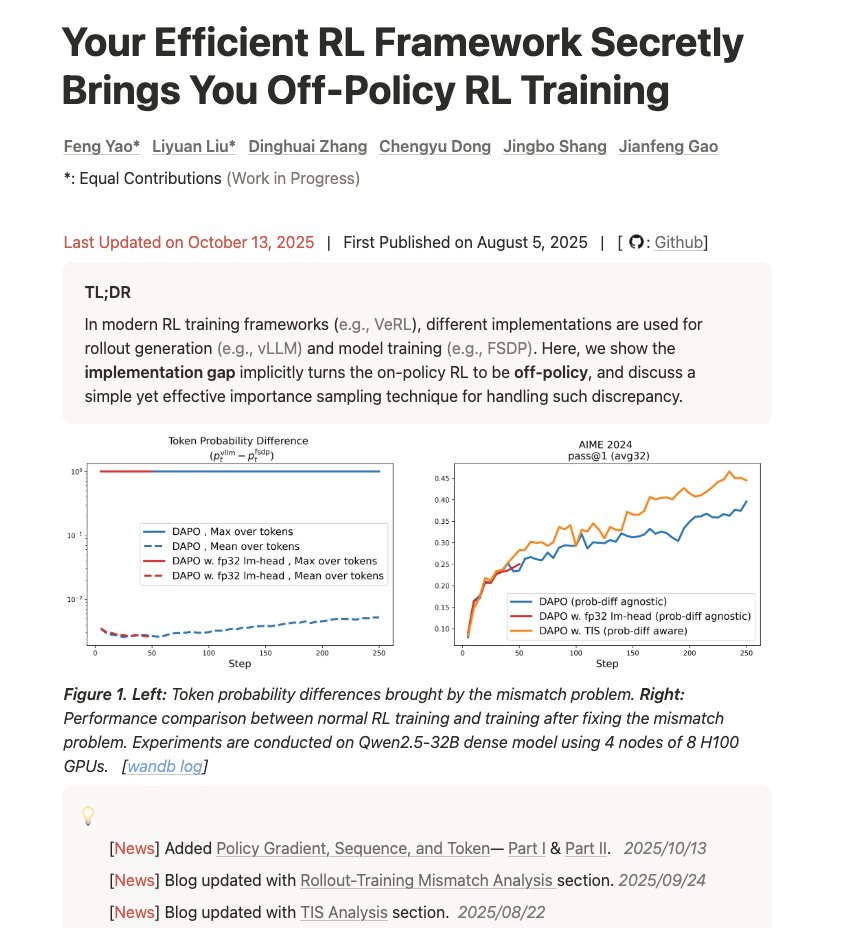

#6 - 你高效率的強化學習架構悄悄地為你帶來了離策略性增強學習訓練 連結 - https://t.co/d2Loq5UwZQ 這篇部落格寫得很好,深入淺出地講解了訓練與推理不匹配以及它如何影響結fengyao.notion.site/off-policy-rl#…下,問題有多嚴重,以及如何使用重要性抽樣來修復它。”