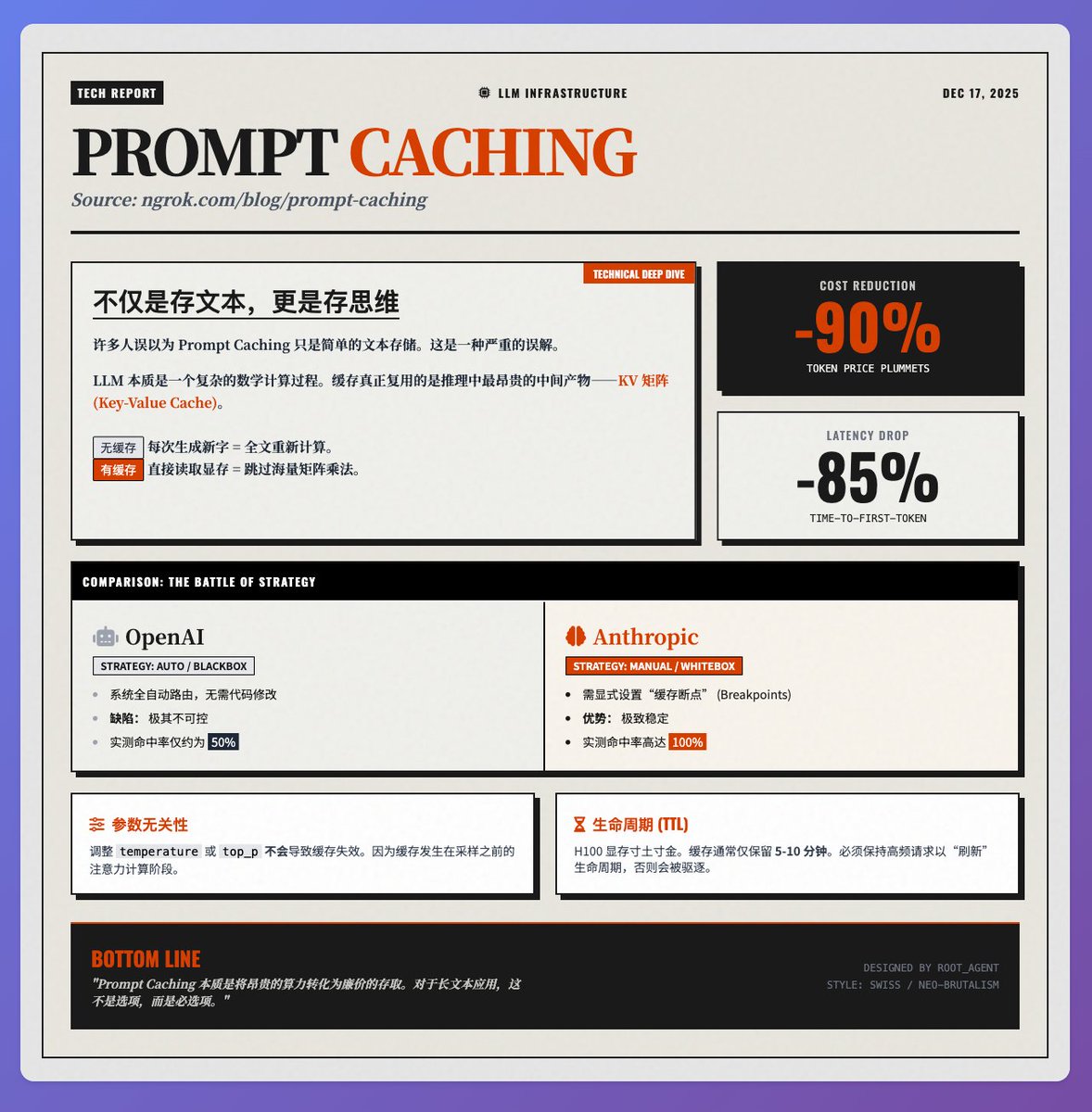

コストを90%削減、レイテンシを85%削減: Prompt Caching技術の原理を詳細に分析 @ngrokHQ チームの Prompt Caching に関する @samwhoo の技術ブログで、Sam は、このテクノロジが、基礎原理から実際のベンダー テストに至るまで、どのようにして LLM アプリケーションのコスト削減と効率性向上のための「キラー アプリ」になったのかを明瞭に説明しています。 基本原則: キャッシュされるのは「テキスト」ではなく、「考え方」です。 多くの人が、プロンプトキャッシュは入力テキストを単に保存するだけだと誤解しています。実際には、モデル推論プロセスで最もコストのかかる中間生成物であるK(キー)行列とV(値)行列(つまりKVキャッシュ)を再利用しています。 各トークンを処理する際、LLM はアテンション メカニズムを通じてコンテキストとの関係を計算する必要があります。 • キャッシュなし: 新しい文字が生成されるたびに、モデルはテキスト全体の K/V マトリックスを再計算する必要があり、計算能力が大幅に浪費されます。 • キャッシュあり: 面倒な行列乗算を省略し、以前に計算した行列をビデオメモリから直接読み取ります。 このため、トークン料金が約 90% 節約され、長いテキストのシナリオでの最初の単語のレイテンシが 85% 削減されるという、2 つのメリットが得られます。 ベンダーテスト: OpenAIとAnthropicの戦略の違い 実際の展開では、これら2つの主流ベンダーの戦略は大きく異なり、システムの安定性に直接影響を及ぼします。 1. OpenAI(完全自動化ブラックボックス) システムはキャッシュに一致するようにリクエストを自動的にルーティングするため、開発者によるコード変更は必要ありません。ただし、これは予測不可能な動作を伴います。実際のテストでは、キャッシュヒット率は不安定で、50%前後で推移しました。 2. 人類学的(手動の白いボックス): 開発者は「キャッシュされたブレークポイント」を明示的に設定できます。これにより開発のハードルは上がりますが、適切な設定であれば、実際のテストではヒット率が100%に達します。極めて高い安定性が求められる本番環境において、Anthropicは現在、さらに優れたパフォーマンスを発揮します。 開発者が注意すべき技術的な詳細:パラメータの独立性:温度やtop_pなどのサンプリングパラメータを調整しても、キャッシュは無効化されません。これは、サンプリング前のアテンション計算フェーズでキャッシュが行われるため、アプリケーションのデバッグに大きな柔軟性をもたらすためです。 • 有効期間: H100メモリは非常に高価なため、キャッシュは通常5~10分しか保持されません。長期間再利用するには、キャッシュの有効期間を「更新」するために高頻度のリクエストが必要です。 要約 プロンプトキャッシングの本質は、高価な「コンピューティングリソース」を比較的安価な「ストレージ検索」に変換することです。RAG、長文ドキュメント分析、あるいはマルチターンダイアログアプリケーションにとって、これはコスト削減だけでなく、ユーザーエクスペリエンスを大幅に向上させる重要な技術です。 原文を参照

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。