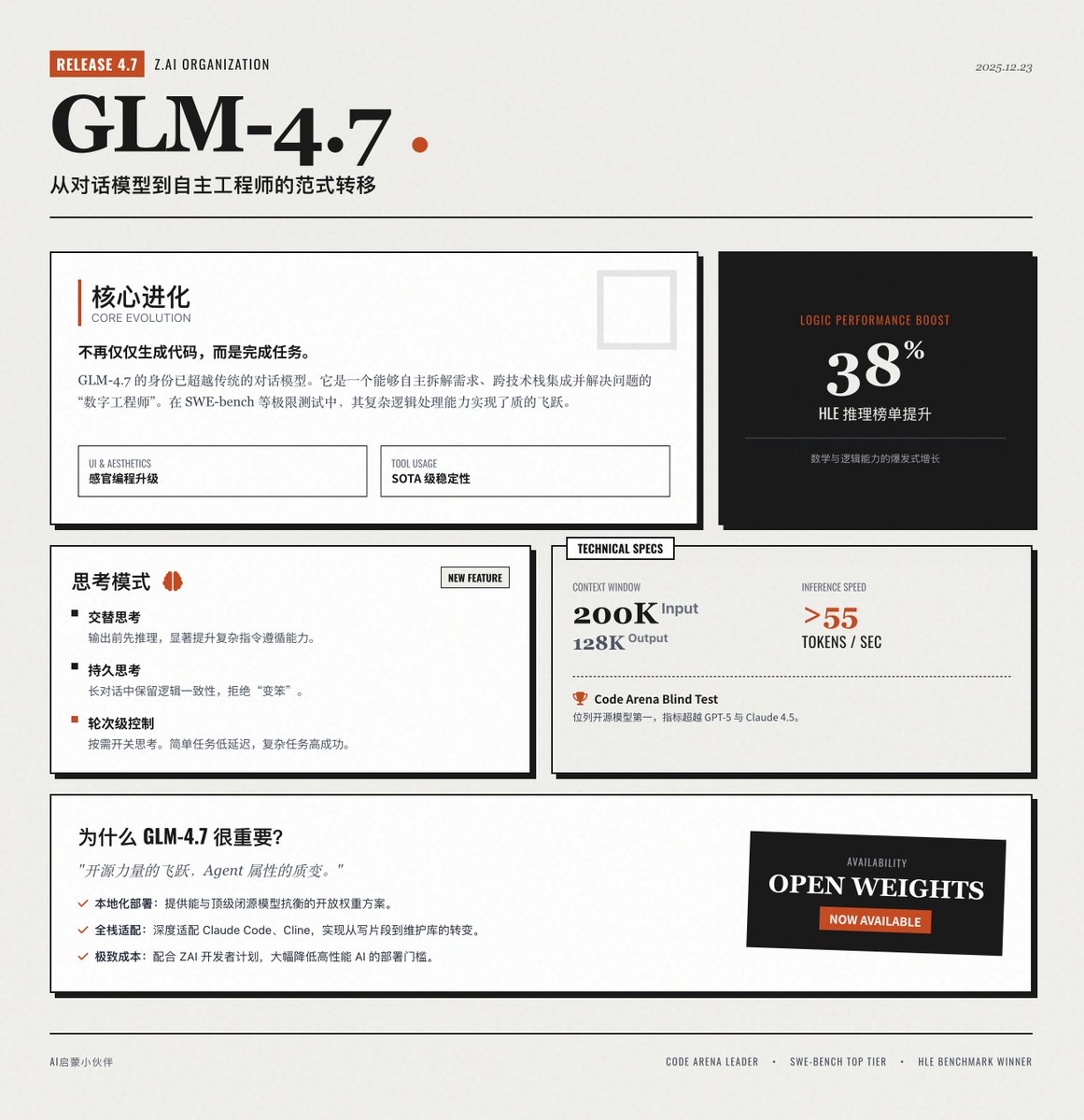

Zhipu AI lança oficialmente o GLM-4.7 🚀 O mais recente modelo fundamental da Zai AI, uma grande atualização da série GLM, alcançou avanços inovadores em programação, raciocínio lógico e capacidades do agente. 📢 Interlúdio: Este cartão informativo foi gerado usando GLM-4.7 + prompts de cartão informativo. Você pode ter uma ideia de suas capacidades de design de interface. Evolução do núcleo: da "geração de código" à "conclusão da tarefa" O GLM-4.7 não é mais apenas um modelo de diálogo; é mais como um engenheiro digital capaz de resolver problemas complexos de forma autônoma. • Programação principal: Programação de agentes multilíngue aprimorada, superando significativamente seu antecessor em testes de programação complexos, como o SWE-bench, capaz de compreender requisitos de forma autônoma, decompor soluções e integrar-se em diferentes conjuntos de tecnologias. • Programação sensorial: Aprimora a estética da interface do usuário/front-end, resultando em um código de página web e layouts de slides mais modernos e atraentes, reduzindo o processo tedioso de ajustes manuais de estilo. • Invocação de ferramentas: Estabilidade de decisão em várias etapas, atingindo o nível de última geração (SOTA) no benchmark de uso de ferramentas complexas e suportando a extração de parâmetros de ferramentas em tempo real. • Raciocínio Complexo: Avanços matemáticos e lógicos, com desempenho aprimorado em aproximadamente 38% em comparação com o GLM-4.6 em benchmarks de raciocínio extremamente difíceis, como o HLE. Funcionalidades inovadoras: Modo de "Pensamento" multidimensional O GLM-4.7 introduz um controle mais flexível da cadeia de pensamento, tornando o modelo mais "racional" ao lidar com tarefas. Pensamento Alternado: Pensar antes de dar uma resposta ou acionar uma ferramenta melhora significativamente a capacidade de seguir instruções complexas. • Pensamento persistente: Em diálogos com múltiplas interações, o modelo retém seus processos de pensamento anteriores, garantindo a consistência do raciocínio em tarefas de programação complexas ao longo de conversas prolongadas e evitando que o modelo "se torne estúpido devido a diálogos excessivamente longos". • Controle de raciocínio baseado em rodadas: Os usuários podem ativar e desativar a função de raciocínio conforme necessário. Para tarefas simples, como pesquisa de informações, o raciocínio pode ser desativado para obter baixa latência; para planejamento complexo, o raciocínio profundo pode ser ativado para obter uma alta taxa de sucesso. Especificações técnicas e desempenho O GLM-4.7 atingiu o nível máximo da indústria em termos de parâmetros técnicos, especialmente no processamento de textos longos e em eficiência. • Contexto longo: Suporta até 200 KB de entrada de contexto e até 128 KB de saída de conteúdo em uma única execução. • Velocidade de inferência extrema: velocidades de inferência superiores a 55 tokens/s proporcionam uma experiência de resposta excepcional, mantendo o desempenho de ponta. • Classificação de referência: Em testes cegos como o Code Arena, o GLM-4.7 ficou em primeiro lugar entre os modelos de código aberto, e algumas métricas chegaram a superar o GPT-5 e o Claude 4.5 Sonnet. Por que o GLM-4.7 é tão importante? • Um grande avanço no poder do código aberto: Como um modelo de peso aberto, o GLM-4.7 oferece aos desenvolvedores uma opção que pode rivalizar com os principais modelos de código fechado, promovendo muito a possibilidade de implantação local e aplicativos privados. • Atributos de Agente Mais Robustos: É um dos modelos mais compatíveis com soluções de assistentes de programação inteligentes, como Claude Code e Cline, concretizando verdadeiramente a transformação de "escrever trechos de código" para "manter autonomamente toda a base de código". • Equilibrando eficiência e custo: Com o programa para desenvolvedores lançado pela ZAI, o custo de suas chamadas foi bastante reduzido, tornando a implantação em larga escala de IA de alto desempenho mais viável. Veja o anúncio oficial:

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.