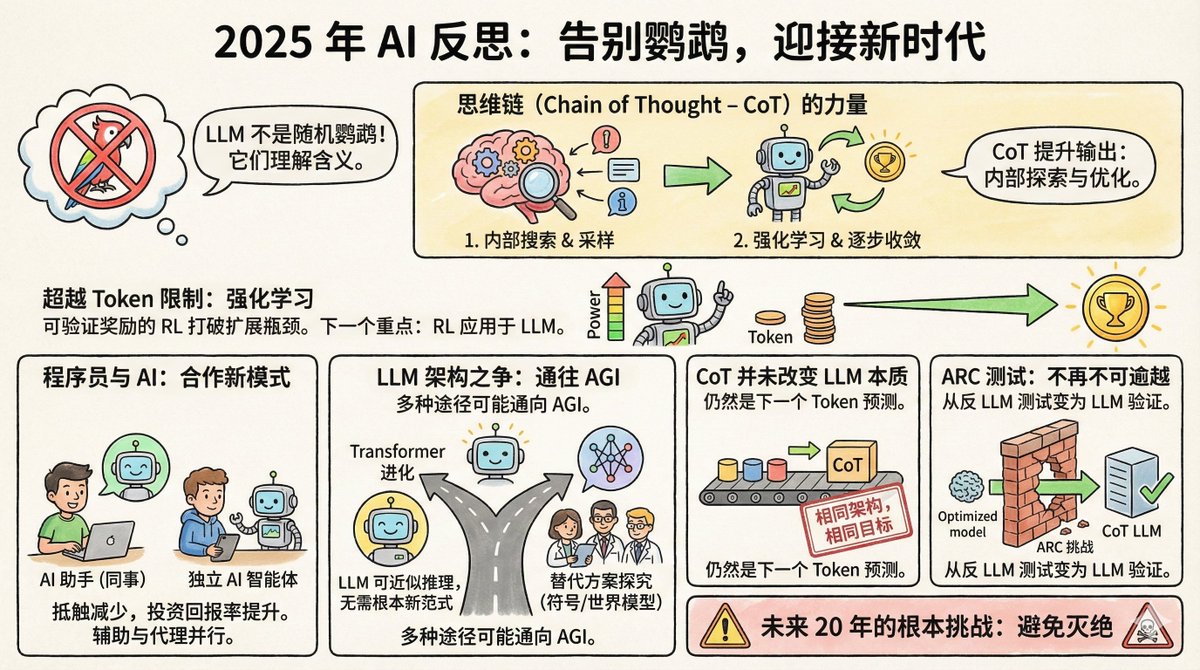

Salvatore Sanfilippo, criador do Redis, publicou recentemente uma reflexão de fim de ano sobre IA, destacando oito pontos principais. Primeiramente, um pouco de contexto: Salvatore não é da área de IA; ele é uma lenda no mundo da programação. Em 2009, ele criou o Redis, um banco de dados que hoje é um dos sistemas de cache mais populares do mundo. Ele se aposentou do Redis em 2020 para se dedicar a seus próprios projetos. Retornou ao Redis no final de 2024, tornando-se também um usuário assíduo de ferramentas de IA; Claude é seu parceiro de programação. Essa identidade é bastante interessante: ele é ao mesmo tempo um especialista em tecnologia e um usuário comum de IA, o que lhe confere uma perspectiva mais realista do que os pesquisadores de IA pura. Em primeiro lugar, a alegação sobre papagaios aleatórios está finalmente sendo desacreditada. Em 2021, pesquisadores do Google, Timnit Gebru e outros, publicaram um artigo que apelidou os grandes modelos de linguagem de "papagaios aleatórios". Isso significa que esses modelos simplesmente juntam palavras probabilisticamente, sem entender o significado da pergunta ou saber o que estão dizendo. A analogia é vívida e amplamente utilizada. Mas Salvatore afirma que, até 2025, quase ninguém mais a usará. Por quê? Porque há evidências demais. Os modelos LLM superam a grande maioria dos humanos em exames da OAB, exames de medicina e competições de matemática. Mais importante ainda, pesquisadores, por meio da engenharia reversa desses modelos, descobriram que eles de fato contêm representações internas de conceitos, e não apenas colagens de palavras. Geoffrey Hinton resumiu a questão de forma bastante direta: para prever com precisão a próxima palavra, é preciso compreender a frase. A compreensão não substitui a previsão, mas é uma condição necessária para fazer boas previsões. É claro que, se a LLM realmente entende isso, é um debate filosófico. Mas, em termos práticos, esse debate está encerrado. II. A Corrente Mental é uma descoberta revolucionária subestimada A cadeia de raciocínio consiste em fazer com que o modelo registre seu processo de pensamento antes de responder. Parece simples, mas o mecanismo subjacente é bastante complexo. Salvatore acredita que isso fez duas coisas: Primeiro, permite que o modelo explore suas representações internas antes de responder. Em termos mais simples, ele recupera conceitos e informações relevantes para o contexto da pergunta e, em seguida, responde com base nessas informações. Isso é um pouco como alguém esboçar sua prova em um rascunho com antecedência. Em segundo lugar, ao incorporar o aprendizado por reforço, o modelo aprende a guiar seu raciocínio passo a passo em direção à resposta correta. A saída de cada token altera o estado do modelo, e o aprendizado por reforço o ajuda a encontrar o caminho que converge para a resposta certa. Não tem nada de misterioso, mas os efeitos são incríveis. Terceiro, o gargalo da expansão da capacidade computacional foi superado. Havia um consenso na comunidade de IA: a melhoria das capacidades dos modelos depende da quantidade de dados de treinamento, mas a quantidade de texto produzido por humanos é limitada, portanto a expansão eventualmente encontrará um limite. Mas agora, com o aprendizado por reforço que oferece recompensas verificáveis, as coisas mudaram. O que são recompensas verificáveis? Para algumas tarefas, como otimizar a velocidade de um programa ou provar teoremas matemáticos, o modelo pode avaliar a qualidade dos resultados por si só. Um programa mais rápido é melhor, e uma prova correta é correta; nenhuma anotação humana é necessária. Isso significa que o modelo pode se aprimorar continuamente nesses tipos de tarefas, gerando uma quantidade quase infinita de sinais de treinamento. Salvatore acredita que essa será a direção do próximo grande avanço na IA. Lembra-se da 37ª jogada do AlphaGo? Ninguém a entendeu na época, mas mais tarde provou-se que foi uma jogada divina. Salvatore acredita que o LLM pode seguir um caminho semelhante em certos campos. IV. As atitudes dos programadores mudaram. Há um ano, a comunidade de programadores estava dividida em dois grupos: um acreditava que a programação assistida por IA era uma arma mágica, e o outro a considerava apenas um brinquedo. Agora, os céticos, em sua maioria, mudaram de opinião. A razão é simples: o retorno sobre o investimento ultrapassou um ponto crítico. O modelo pode, de fato, cometer erros, mas o tempo economizado compensa amplamente o custo de corrigi-los. Curiosamente, as abordagens dos programadores à IA se dividem em duas categorias: uma trata o LLM como um "colega", utilizando-o principalmente por meio de interfaces conversacionais baseadas na web. O próprio Salvatore pertence a essa categoria, usando versões online como Gemini e Claude para colaborar como se estivesse conversando com uma pessoa experiente. Outra corrente de pensamento vê o LLM como uma "inteligência de codificação independente e autônoma", permitindo-lhe escrever código, executar testes e corrigir erros por conta própria, enquanto os humanos são os principais responsáveis pela revisão. Esses dois usos se baseiam em filosofias diferentes: você trata a IA como uma assistente ou como uma executora? V. O Transformer pode ser o caminho a seguir. Alguns cientistas de IA de renome começaram a explorar arquiteturas além do Transformer, formando empresas para pesquisar representações simbólicas explícitas ou modelos do mundo. Salvatore tem uma visão aberta, porém cautelosa, sobre isso. Ele acredita que o LLM é essencialmente uma aproximação do raciocínio discreto em um espaço diferenciável, e que não é impossível alcançar a IAG sem um paradigma fundamentalmente novo. Além disso, a IAG pode ser implementada independentemente por meio de uma variedade de arquiteturas completamente diferentes. Em outras palavras, todos os caminhos levam a Roma. O Transformer pode não ser o único caminho, mas também não é necessariamente um beco sem saída. VI. A cadeia de mentalidade não altera a essência do LLM. Algumas pessoas mudaram de opinião. Antes diziam que LLM era apenas um papagaio repetindo o que pensava, mas agora reconhecem que LLM tem essa capacidade, embora também afirmem que a cadeia mental altera fundamentalmente a natureza de LLM, portanto as críticas anteriores ainda são válidas. Salvatore disse sem rodeios: Eles estão mentindo. A arquitetura permanece a mesma; ainda é um Transformer. O objetivo do treinamento permanece o mesmo: prever o próximo token. O CoT também é gerado token por token, o que não é diferente de gerar outros conteúdos. Você não pode afirmar que o modelo "se tornou outra coisa" só porque se tornou mais poderoso, para justificar seu julgamento incorreto. Essa é uma afirmação bastante direta, mas logicamente correta. Os julgamentos científicos devem ser baseados em mecanismos, e as definições não devem ser alteradas simplesmente porque o resultado mudou. Outro exemplo que ilustra bem esse ponto é o teste ARC. VII. Os testes ARC passaram de serem contrários ao LLM para serem favoráveis ao LLM. O ARC é um teste desenvolvido por François Chollet em 2019 especificamente para medir a capacidade de raciocínio abstrato. Seu objetivo é resistir à recuperação de memória e a buscas por força bruta, exigindo raciocínio genuíno para sua resolução. Na época, muitas pessoas acreditavam que o LLM jamais passaria nesse teste. Isso porque ele exige a capacidade de generalizar regras a partir de um número muito pequeno de amostras e aplicá-las a novas situações, algo que um papagaio aleatório não consegue fazer. O resultado? No final de 2024, o modelo o3 da OpenAI alcançou uma precisão de 75,7% no ARC-AGI-1. Em 2025, mesmo no ARC-AGI-2, mais difícil, os melhores modelos atingiram mais de 50% de precisão. Essa inversão é bastante irônica. O teste foi originalmente concebido para provar que o LLM é ineficaz. No entanto, ironicamente, tornou-se uma evidência que comprova a eficácia do LLM. VIII. Desafios Fundamentais para os Próximos 20 Anos O último ponto resume-se a uma única frase: O desafio fundamental para a IA nos próximos 20 anos é evitar a extinção. Ele não deu mais detalhes, apenas essa frase. Mas você sabe o que ele quer dizer. Quando a IA realmente se tornar poderosa o suficiente, "como garantir que ela não cause grandes problemas" deixará de ser ficção científica. Salvatore não é um fervoroso defensor da IA, nem um cético. Ele entende a tecnologia e a utiliza na prática. Sua perspectiva não é puramente acadêmica, nem puramente comercial, mas sim a observação serena de um engenheiro experiente. Sua principal conclusão é que os LLMs são muito mais poderosos do que muitas pessoas estão dispostas a admitir, o aprendizado por reforço está abrindo novas possibilidades e nossa compreensão desses sistemas ainda está longe de ser completa. Este é provavelmente o verdadeiro estado do desenvolvimento da IA em 2025: as capacidades estão se acelerando, as controvérsias estão diminuindo, mas a incerteza permanece enorme.

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.