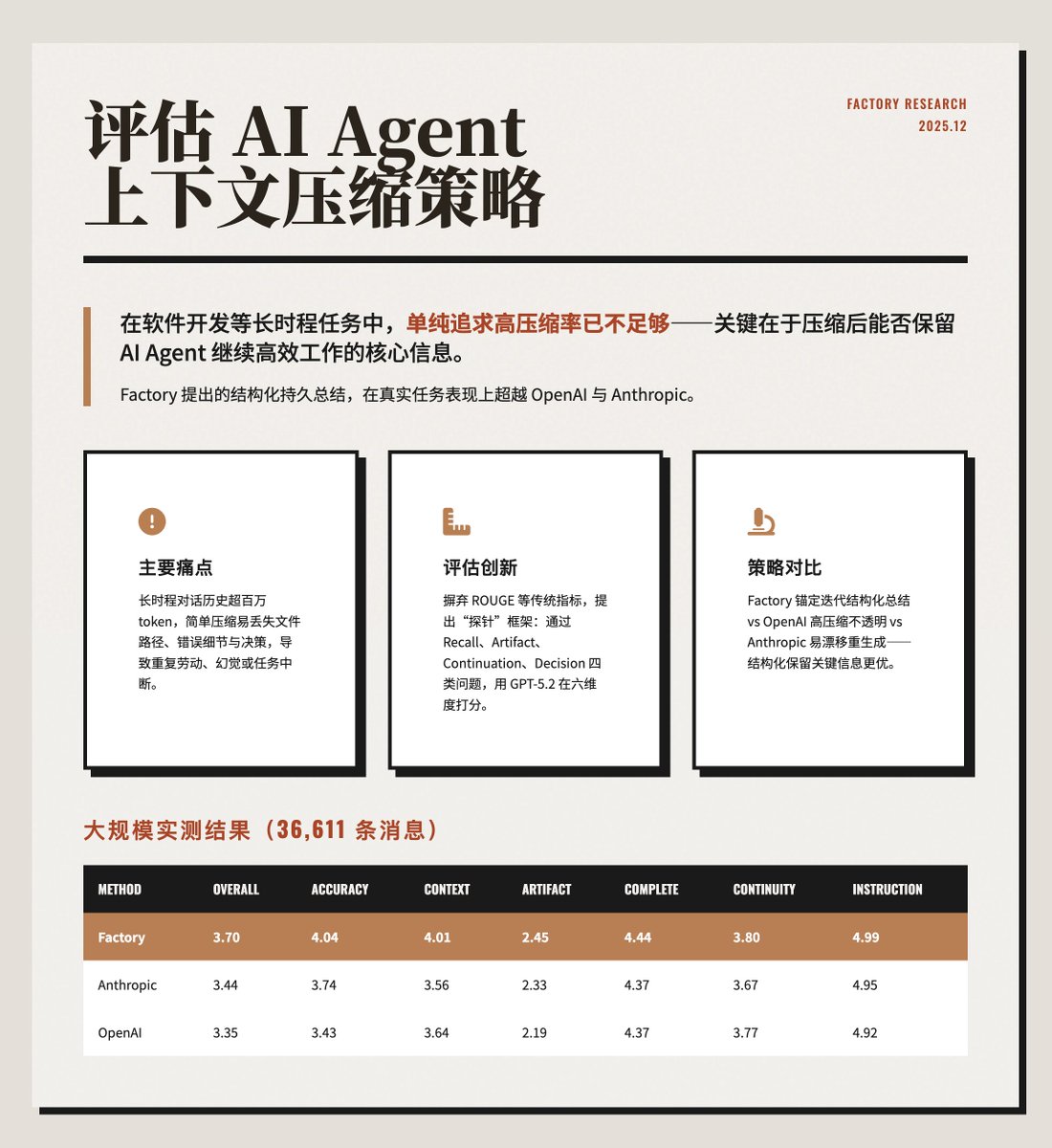

Avalie a estratégia de compressão de contexto do agente de IA. Ao lidar com tarefas que exigem continuidade, como o desenvolvimento de softwarefactory.ai/news/evaluatin…ma alta taxa de compressão de contexto é insuficiente. Mais importante ainda, o processo de compressão deve preservar informações cruciais para que o agente de IA continue funcionando de forma eficaz. O método de sumarização estruturada proposto pela @FactoryAI supera o OpenAI e o Anthropic em tarefas práticas. https://t.co/ZsCDxoVO3Q Principais problemas Quando agentes de IA são executados por longos períodos, eles geram uma quantidade enorme de histórico de diálogos (mais de 1 milhão de tokens), excedendo o limite da janela de contexto do modelo. Uma simples compressão pode facilmente resultar na perda de detalhes cruciais, como caminhos de arquivos modificados, mensagens de erro ou decisões anteriores, fazendo com que o agente de IA execute tarefas repetitivas, apresente alucinações ou tenha suas tarefas interrompidas. O artigo enfatiza que otimizar o "consumo de tokens por tarefa", em vez da "redução de tokens por compressão", é crucial para alcançar uma operação eficiente e contínua. O método de avaliação inova em relação às métricas tradicionais (como ROUGE ou similaridade de incorporação), que medem apenas a similaridade textual e não conseguem avaliar se o contexto comprimido permite a continuação da tarefa em si. Este artigo propõe uma estrutura de avaliação baseada em sondagem: • Após a compressão, faça perguntas específicas ao agente de IA para testar sua retenção. • As sondagens são classificadas em quatro categorias: Recordação, Artefato, Continuação e Decisão. • Utilize o GPT-5.2 como avaliador do LLM e atribua uma pontuação em seis dimensões (0-5 pontos): precisão, consciência contextual, rastreamento da peça, integridade, continuidade e conformidade com as instruções. Comparação de três estratégias de compressão: Factory: Emprega "sumação iterativa ancorada", mantendo um resumo estruturado e persistente que inclui a intenção, as modificações do documento, as decisões e as próximas etapas. O novo conteúdo é gradualmente incorporado, em vez de ser regenerado a cada vez. • OpenAI: Utiliza a interface `/responses/compact`, alcançando a maior taxa de compressão (99,3%), mas seu resumo é opaco e frequentemente descarta conteúdo de baixa entropia, como caminhos de arquivos. • Antrópico: Gera resumos estruturados detalhados (incluindo análises, documentos, tarefas, etc.), mas se regenera completamente a cada compressão, o que pode causar desvios no resumo. O exemplo e os resultados ilustram isso com um caso específico de depuração de um erro 401: o Factory, após a compressão, recupera com precisão os detalhes do erro e a causa raiz, enquanto o OpenAI e o Anthropic perdem parte da especificidade técnica. Os resultados de um teste em larga escala com dados reais de produção (36.611 mensagens) são mostrados na imagem abaixo. A Factory se destaca em precisão e reconhecimento de contexto. Embora a OpenAI ostente a maior taxa de compressão, apresenta a menor qualidade, o que pode acarretar custos adicionais de recuperação devido à perda de informações. Principal conclusão: Estrutura em vez de compressão extrema: Resumos explicitamente segmentados preservam melhor as informações essenciais. A taxa de compressão não é a única métrica: uma alta compressão pode sacrificar a eficiência da tarefa; o consumo total de tokens é mais importante. • O rastreamento de peças é um desafio: todos os métodos apresentam baixa pontuação nessa dimensão, exigindo mecanismos de indexação adicionais. • A avaliação por sondagem é mais confiável: ela reflete a usabilidade real melhor do que as métricas tradicionais de PNL (Processamento de Linguagem Natural).

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.