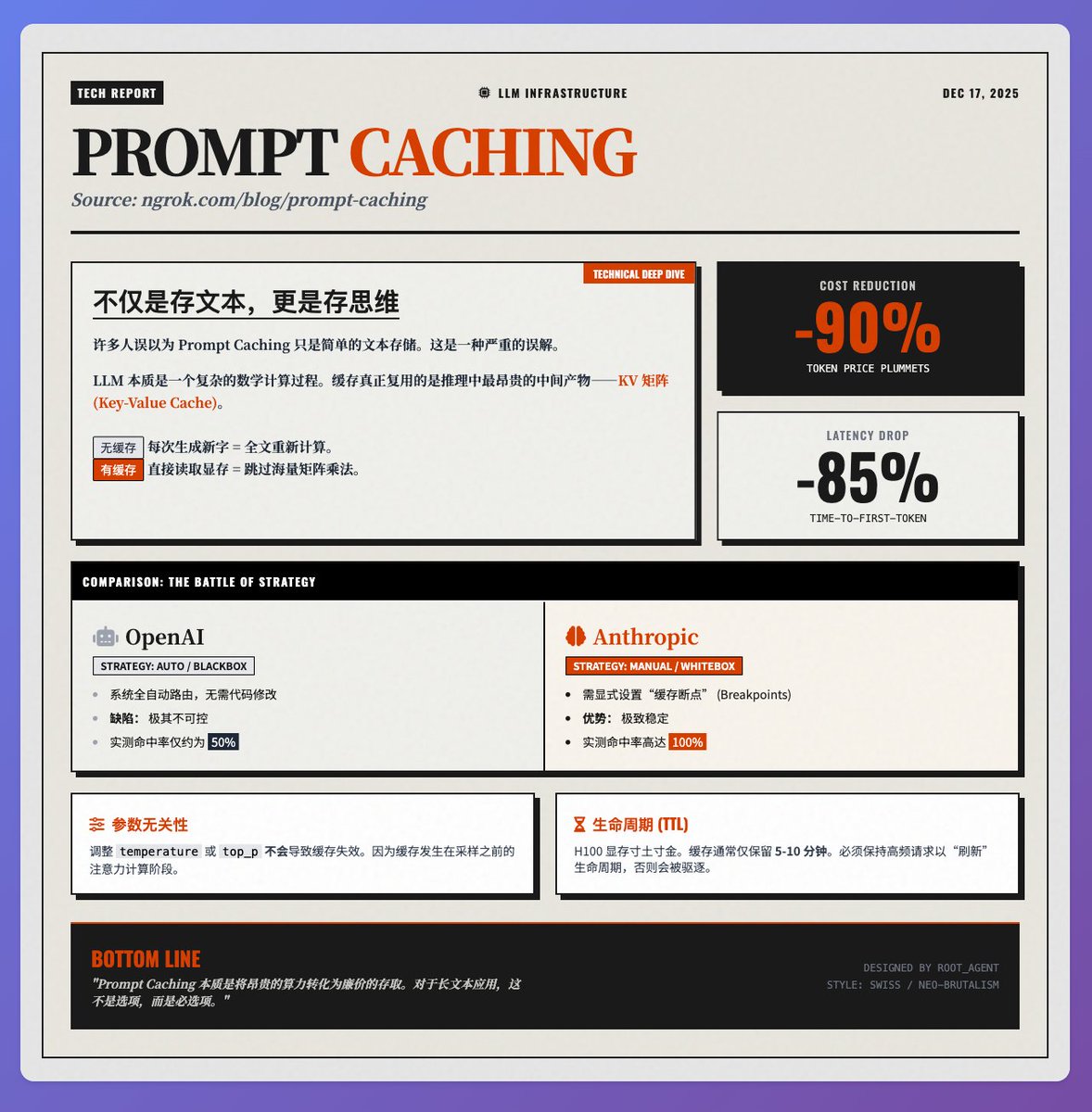

Custos reduzidos em 90%, latência reduzida em 85%: Análise detalhada dos princípios da tecnologia Prompt Caching. No blog técnico de @samwhoo sobre Prompt Caching na equipe @ngrokHQ, Sam revela claramente como essa tecnologia se tornou um "aplicativo matador" para redução de custos e melhoria da eficiência em aplicações LLM, desde os princípios subjacentes até os testes reais do fornecedor. Princípio fundamental: O que é armazenado em cache não é "texto", mas sim "mentalidade". Muitas pessoas acreditam erroneamente que o Prompt Caching simplesmente armazena o texto de entrada. Na realidade, ele reutiliza o produto intermediário mais custoso no processo de inferência do modelo — as matrizes K (Chave) e V (Valor) (ou seja, o Cache KV). Ao processar cada token, o LLM precisa calcular sua relação com o contexto por meio de um mecanismo de atenção. • Sem armazenamento em cache: Para cada novo caractere gerado, o modelo precisa recalcular a matriz chave/valor de todo o texto, resultando em um enorme desperdício de poder computacional. • Com armazenamento em cache: Leia a matriz previamente calculada diretamente da memória de vídeo, evitando a multiplicação de matrizes, que é trabalhosa. Por isso, oferece um benefício duplo: economiza cerca de 90% das taxas de tokens e reduz a latência da primeira palavra em cenários de texto longo em 85%. Testes de Fornecedores: As Diferenças entre as Estratégias da OpenAI e da Anthropic. Em implementações reais, as estratégias desses dois principais fornecedores são drasticamente diferentes, impactando diretamente a estabilidade do sistema: 1. OpenAI (Caixa Preta Totalmente Automatizada): O sistema tenta automaticamente encaminhar as solicitações para corresponder ao cache, sem exigir modificações de código por parte dos desenvolvedores. No entanto, isso tem um custo: a imprevisibilidade — em testes reais, a taxa de acertos do cache foi instável, oscilando em torno de 50%. 2. Antrópico (caixa branca manual): Os desenvolvedores podem definir explicitamente "pontos de interrupção em cache". Embora isso aumente o nível de exigência para desenvolvimento, com as configurações adequadas, a taxa de acerto chega a 100% em testes reais. Para ambientes de produção que exigem extrema estabilidade, o Anthropic apresenta desempenho ainda melhor. Detalhes técnicos aos quais os desenvolvedores precisam estar atentos: Independência de parâmetros: Ajustar parâmetros de amostragem, como temperatura ou top_p, não causará invalidação do cache. Isso ocorre porque o armazenamento em cache acontece durante a fase de cálculo da atenção, antes da amostragem, o que proporciona flexibilidade significativa para a depuração do aplicativo. • Tempo de vida: Devido ao custo extremamente elevado da memória H100, o cache normalmente é retido por apenas 5 a 10 minutos. Para reutilizá-lo por um longo período, é necessária uma alta frequência de solicitações para "atualizar" o tempo de vida do cache. Resumir A essência do Prompt Caching é transformar "recursos computacionais" dispendiosos em "recuperação de armazenamento" relativamente barata. Para aplicações de RAG (Ação Rápida de Resposta), análise de documentos extensos ou diálogos com múltiplas interações, essa é uma tecnologia fundamental que não só economiza dinheiro, como também melhora significativamente a experiência do usuário. Texto original de referência

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.