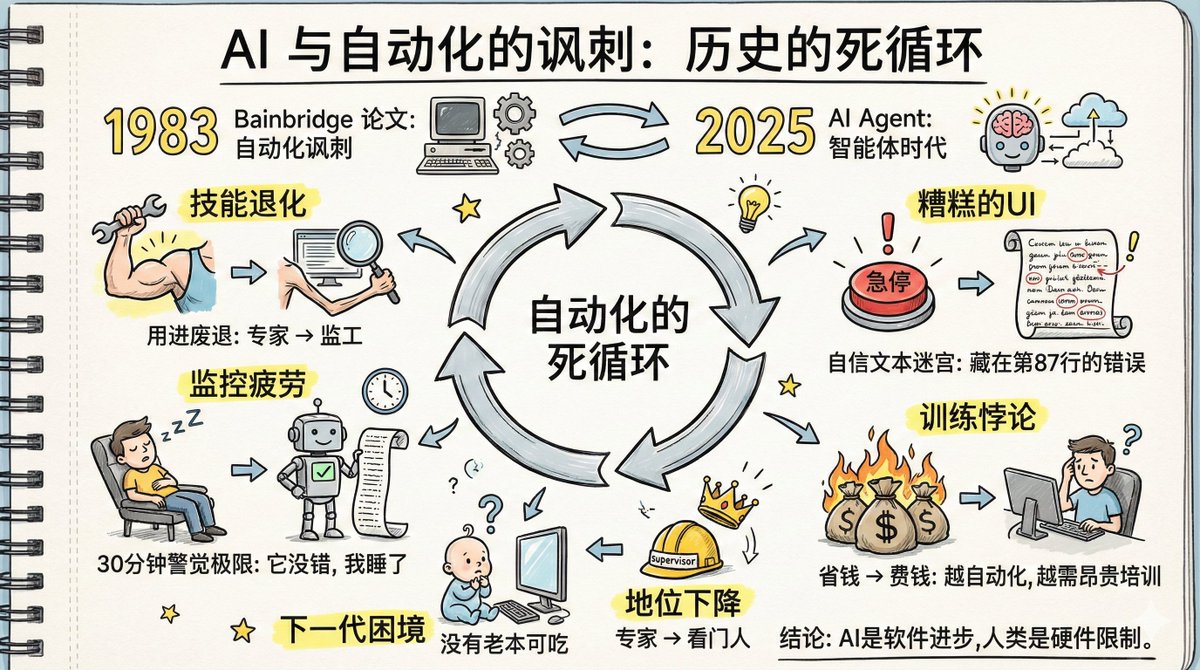

Li hoje um artigo chamado "A Ironia da IA e da Automação", e seu conteúdo é muito relevante para o desenvolvimento atual da IA. Em 1983, a psicóloga cognitiva Lisanne Bainbridge escreveu um artigo intitulado "A Ironia da Automação". Mais de quarenta anos depois, os problemas previstos nesse artigo estão se concretizando palavra por palavra no caso dos agentes de IA. Naquela época, ela pesquisava automação industrial: máquinas realizando o trabalho e humanos supervisionando. Hoje, enfrentamos a automação por agentes de IA: a IA realiza o trabalho, os humanos supervisionam. O cenário mudou, mas a lógica subjacente permanece exatamente a mesma. E os problemas que ela apontou em seu artigo estão acontecendo novamente. Quais questões foram mencionadas no artigo? 1. O Dilema da Degradação de Habilidades: Habilidades Atrofiam Quando Não Utilizadas; Habilidades de Especialistas Diminuem Quando Eles se Tornam Supervisores Todos nós entendemos o conceito de "use ou perca". Mas na era da IA, ele tem uma versão mais brutal. Antes, você era especialista em determinada área, realizando suas tarefas diariamente com facilidade. Agora, a empresa diz: "Deixe o agente de IA fazer o trabalho; você é responsável por monitorá-lo e intervir somente quando surgirem problemas." Parece ótimo, não é? Ser promovido de funcionário a supervisor, não seria mais fácil? Eis o problema: se você parar de fazer isso, suas habilidades não apenas deixarão de melhorar, como poderão até piorar. Como alguém que usa IA para escrever código diariamente, percebo que não progredi muito nos últimos dois anos e me tornei dependente da IA. Muitas linhas de código que eu costumava escrever sem esforço agora são impossíveis sem ela. É realmente um caso de "use ou perca". Tanto a OpenAI quanto a Anthropic estão alardeando o poder de seus Agentes de Codificação, alegando que seus funcionários só precisam verificar a saída da IA. No entanto, omitem deliberadamente o fato de que esses indivíduos são especialistas altamente qualificados e criteriosamente selecionados, com ampla experiência para avaliar a precisão da IA. Se, nos próximos anos, eles se concentrarem apenas em verificar o trabalho da IA, suas habilidades irão declinar gradualmente. Nós, programadores mais experientes, estamos bem, mas a próxima geração está em situação ainda pior. Os programadores veteranos de hoje, pelo menos, cresceram por meio da experiência prática. E quanto aos programadores de amanhã? Eles acompanham a IA desde o início, mas não têm muita experiência prática. Falta-lhes tanto as habilidades quanto a oportunidade de aprender. Então, como irão julgar se a IA está correta? As palavras originais do artigo eram: A atual geração de sistemas de automação depende das habilidades da geração mais antiga de operadores. É improvável que a próxima geração de operadores possua essas habilidades. Esse problema pode não ser aparente hoje, mas pode se tornar evidente em três a cinco anos. 2. Dificuldades de recuperação da memória: A recuperação de conhecimento pouco utilizado é mais lenta. Outro problema é que a memória das habilidades relacionadas também pode se deteriorar. Pense naquelas fórmulas que sabíamos de cor no ensino médio; quantas ainda conseguimos lembrar hoje? Em um cenário supervisionado por IA, à medida que a IA se torna mais poderosa, ela acerta na maioria das vezes. Isso significa que, na maior parte do tempo, seu conhecimento não será necessário. Conforme seu conhecimento for menos utilizado, suas memórias relacionadas se deteriorarão. 3. O Paradoxo da Prática: O treinamento teórico é inútil; é preciso aprender através da experiência prática. No entanto, a IA está fazendo o trabalho, e os humanos não têm a oportunidade de praticar. Neste ponto, você pode estar pensando: o treinamento é útil? No entanto, o artigo "A Ironia da Automação" conclui que o treinamento não é muito útil. As habilidades profissionais não são adquiridas por meio de aulas teóricas; elas são aprimoradas por meio da prática no mundo real. As teorias aprendidas em sala de aula são frequentemente incompreensíveis sem exercícios práticos complementares, carecendo de uma estrutura experiencial correspondente. Mesmo que você as entenda inicialmente, rapidamente as esquecerá, pois não há um caminho de recuperação da memória vinculado a tarefas do mundo real. Para manter a capacidade de supervisionar a IA, é necessário realizar o trabalho manualmente com regularidade. No entanto, se o objetivo da empresa é automatizar a IA para aumentar a eficiência, as pessoas terão poucas oportunidades de praticar. Isso é um ciclo vicioso. Conforme consta no artigo: Treinamos os operadores para seguirem instruções, depois os inserimos no sistema e esperamos que forneçam informações. Não se pode esperar que os seres humanos, que normalmente não precisam pensar ou praticar, encontrem boas soluções em momentos críticos. 4. Monitorar a fadiga: Os seres humanos não conseguem manter a vigilância sobre sistemas que "raramente cometem erros" por períodos prolongados. A pesquisa psicológica já comprovou que os seres humanos não conseguem manter-se alertas por períodos prolongados em um alvo que raramente apresenta problemas; meia hora é o limite. Isso não é uma questão de força de vontade, mas sim determinado pela estrutura fisiológica. De uma perspectiva evolutiva, isso é, na verdade, uma vantagem de sobrevivência: se você está olhando fixamente para um ponto e nada acontece, o cérebro automaticamente diminui seu estado de alerta, reservando seus recursos atencionais para lidar com ameaças reais. Mas, em um cenário de vigilância, isso se torna um problema. Os agentes de IA acertam na maioria das vezes, mas ocasionalmente cometem erros. Esse é justamente o padrão mais difícil de monitorar. Se cometem erros com frequência, você fica vigilante. Se nunca cometem erros, não é preciso monitorá-los. Mas a situação em que raramente cometem erros passa completamente despercebida pelos humanos. Pior ainda, os agentes de IA cometem erros de uma forma particularmente sutil. Em vez de dizer "Não tenho certeza", eles descrevem seu plano em um tom extremamente confiante, estendendo-o por dezenas ou até centenas de linhas. O erro pode estar escondido em uma premissa menor na linha 87, como "Como 2 é maior que 3, portanto devemos...". Envolvido por tanto conteúdo aparentemente correto e entorpecido por esse tom confiante, é difícil perceber o erro. Que tal adicionar um sistema de alarme automático? O artigo afirma: Quem monitora o sistema de alarme? Se o próprio sistema de alarme apresentar defeito, o operador não perceberá, pois o sistema vem funcionando normalmente há muito tempo. E se alguém fizer anotações? O artigo afirma que as pessoas podem copiar números mecanicamente sem prestar atenção ao que os números realmente representam. Todas as tentativas de combater a fadiga da vigilância esbarram no mesmo obstáculo: a atenção humana não pode ser mantida em um alvo que raramente causa problemas por um período prolongado. Essa é uma limitação de hardware, não um problema de software. 5. Questão de status: A despromoção de especialista para supervisor resultou em choque psicológico e declínio no status social. Antes você era um especialista; seus colegas recorriam a você com qualquer problema, você era respeitado e tinha um forte senso de identidade profissional. Agora você é o guardião da IA. A perda de habilidades é uma coisa, mas o impacto psicológico é outra. Ser rebaixado de especialista a supervisor, de criador a revisor, de indispensável a reserva — esse tipo de transformação é difícil de aceitar para muitos. O artigo afirma que pessoas rebaixadas dessa forma exibem uma variedade de mecanismos de enfrentamento complexos, alguns dos quais parecem até contraditórios. Essa parte é muito extensa para ser detalhada aqui; os interessados podem ler o artigo original. 6. Interface de usuário ruim: A interface atual do Agente de IA representa o pior design de monitoramento. O setor de automação industrial passou décadas otimizando o projeto de salas de controle: como organizar os monitores para permitir que os operadores detectem rapidamente anomalias, por que o botão de parada de emergência é vermelho, por que é tão grande e por que está localizado naquele ponto. Cada detalhe é resultado de lições aprendidas com acidentes. Agora vamos dar uma olhada na interface do Agente de IA. Uma série de textos longos e confiantes, um plano complexo após o outro, dezenas ou até centenas de linhas de explicações extensas. Você precisa encontrar o erro oculto em meio a todo esse texto. Esta é provavelmente a pior interface de detecção de anomalias já criada pela humanidade. 7. O Paradoxo do Treinamento: Quanto mais bem-sucedido for o sistema automatizado, mais investimento será necessário para treinar os humanos. O artigo discute os problemas de treinamento decorrentes da automação: Se os operadores não puderem assumir periodicamente o controle e executar tarefas pessoalmente, o treinamento em simulador torna-se necessário. No entanto, os simuladores apresentam um problema fundamental: só permitem simular falhas previsíveis. Falhas desconhecidas não podem ser simuladas, e falhas conhecidas, mas ainda não experimentadas, também são difíceis de simular com precisão. O que devemos fazer então? O treinamento pode abordar apenas estratégias gerais, não métodos específicos de resolução de problemas. Mas isso introduz um novo problema: não se pode esperar que os operadores lidem com anomalias consultando apenas o manual de operação, pois o manual não abrange todas as situações. Quanto mais bem-sucedido for um sistema automatizado, menos intervenção humana ele exigirá, mas mais significativo será o investimento necessário em treinamento de pessoal. Porque quanto menor a intervenção, mais rapidamente as habilidades de uma pessoa se deterioram, mais fraca se torna sua capacidade de lidar com anomalias raras e maior o custo de cada sessão de treinamento. Os responsáveis pela tomada de decisões querem economizar dinheiro com IA, mas a economia obtida com recursos humanos pode ter que ser duplicada em custos de treinamento. 8. Dilema da Liderança: Supervisionar IA não se resume a observar passivamente, mas sim a "liderá-la" ativamente. Supervisionar agentes de IA não se resume a observar passivamente; trata-se de direcioná-los ativamente. Dizer-lhes o que fazer, o que não fazer, quantos passos dar e como ajustar sua direção. Isso é, na verdade, uma habilidade de liderança. Por que os gerentes costumam ser os maiores entusiastas dos agentes de IA no LinkedIn? Porque estão acostumados a trabalhar indiretamente: definindo metas, atribuindo tarefas, fornecendo feedback e ajustando a direção, mas sem realizar o trabalho em si. Para eles, dirigir um agente de IA não é diferente de dirigir subordinados. Mas para quem sempre fez o trabalho sozinho, isso representa uma enorme inversão de papéis. É preciso deixar de ser alguém que faz as coisas para se tornar alguém que deixa os outros fazerem. Isso não se resolve simplesmente mudando algumas instruções; é uma reconstrução completa do conjunto de habilidades. A empresa oferece treinamento de liderança para gerentes recém-promovidos. Mas alguém já viu uma empresa oferecer treinamento de liderança para supervisores de IA? O artigo de quarenta anos atrás terminava assim: Os seres humanos podem ser solucionadores de problemas impressionantes quando não há pressão de tempo. A dificuldade reside no fato de que a eficiência cai drasticamente sob pressão de tempo. Espero que este artigo esclareça dois pontos: primeiro, a ironia é que a automação não elimina necessariamente as dificuldades; e segundo, a criatividade tecnológica necessária para resolver esses problemas pode ser maior do que a própria automação. Quarenta anos depois, estamos em um contexto diferente, mas enfrentando o mesmo conjunto de problemas. Os agentes de IA estão melhorando, mas as estruturas cognitivas humanas permanecem inalteradas. O monitoramento da fadiga ainda dura apenas meia hora, a degradação de habilidades ainda depende do uso e da falta de uso, e os pontos cegos de atenção ainda estão presentes. Essas são limitações de hardware, não problemas que atualizações de software possam resolver. Leitura recomendada: "Ironias da Automação": https://t.co/5HWoelLIkR "IA e as ironias da automação - Parte 1" https://t.co/u27fpcCOWk "Inteligência artificial e as ironias da automação - Parte 2"

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.