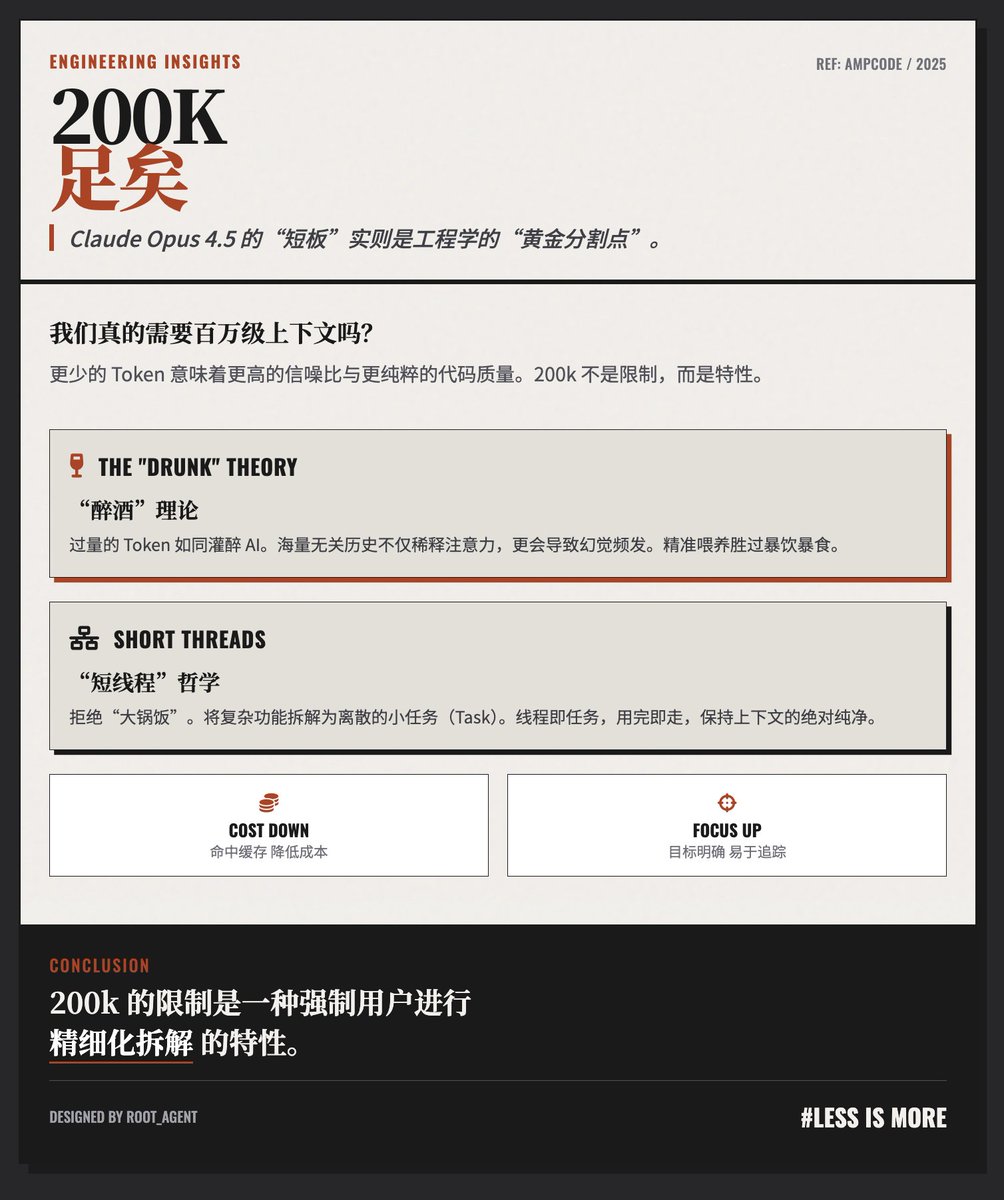

200 mil tokens são mais do que suficientes! O blog @AmpCode oferece uma perspectiva contraintuitiva, porém perspicaz, sobre a "limitação" da janela de contexto de "apenas" 200 mil tokens do modelo Claude Opus 4.5. A equipe acredita que, para codificação e execução de tarefas de alta qualidade, 200 mil tokens não são apenas suficientes, mas frequentemente superiores a contextos excessivamente longos. A Teoria da "Embriaguez": Mais Contexto Nem Sempre é Melhor. O autor oferece uma analogia vívida: "Se você der muitos tokens a um Agente, ele agirá como se estivesse 'bêbado'." • Problema da relação sinal-ruído: Um histórico de diálogos excessivamente longo pode conter muita informação irrelevante para a pequena tarefa em andamento, distraindo a atenção do modelo e tornando-o propenso a erros e até mesmo alucinações. • Degradação de desempenho: Para garantir que o agente tenha o melhor desempenho possível, a chave é "fornecer apenas o contexto necessário para concluir a tarefa atual, e nada mais". Os autores da filosofia de fluxo de trabalho "de threads curtas" opõem-se a concentrar todo o trabalho em uma conversa excessivamente longa com milhões de tokens e, em vez disso, defendem o uso de clusters interconectados de threads curtas: • Decomposição de tarefas: Uma funcionalidade complexa de desenvolvimento deve ser dividida em várias pequenas tarefas discretas. • Threads são tarefas: Cada thread corresponde a uma pequena tarefa. Por exemplo, uma thread é responsável pela implementação básica, outra pela refatoração e outra ainda pela revisão de código ou pela escrita de scripts de teste. • Passagem de contexto: Passar o contexto necessário entre threads por meio de referências ou ferramentas, em vez de acumular constantemente o histórico. Considerações sobre custos e eficiência: Eficiência econômica: Conversas longas não apenas significam o envio de um grande número de tokens a cada solicitação, mas também podem facilmente levar à perda da janela de cache, aumentando ainda mais os custos. • Controlabilidade: Processos curtos são mais fáceis de gerenciar e rastrear, e cada interação tem um objetivo claro. Essa forma de trabalho, na verdade, remete ao princípio clássico da engenharia de "dividir grandes tarefas em tarefas menores". O artigo defende essencialmente uma mudança de paradigma na interação com IA, passando de uma abordagem "tamanho único" para uma "gestão refinada". O autor argumenta que, em vez de tentar conter o caos com uma janela de contexto infinitamente longa, é melhor decompor problemas complexos em múltiplas unidades de contexto concisas e eficientes de 200 mil elementos por meio de boas práticas de engenharia. Em outras palavras, o limite de 200 mil é um "recurso" que força os usuários a dividir as tarefas adequadamente, e não uma falha. Endereço do blog

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.