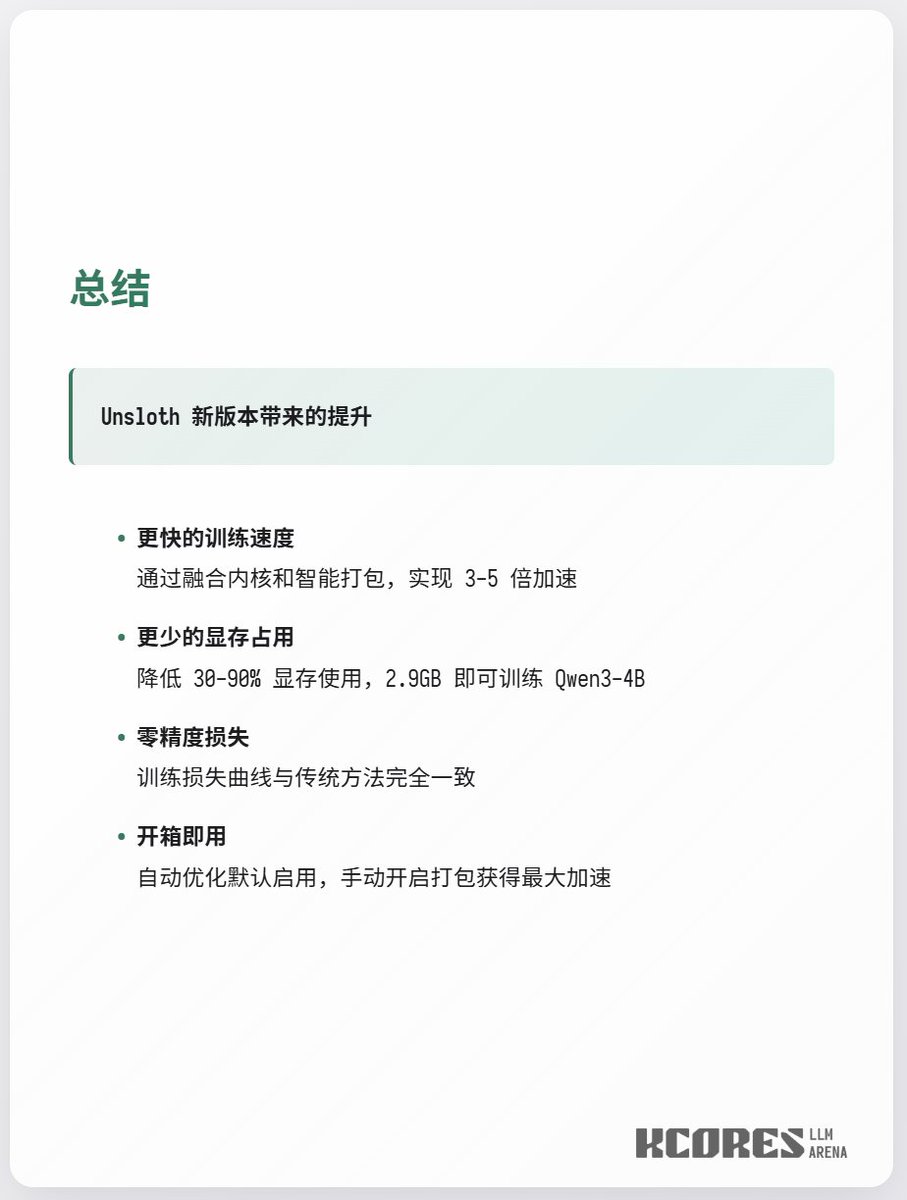

Unsloth está aprontando de novo, treinando Qwen3-4b com 3GB de VRAM. A atualização mais recente do Unsloth representa uma grande melhoria. Em resumo, eles fundiram os dois kernels Triton que eram originalmente necessários para Q e K em um só, e adicionaram suporte a RoPE de comprimento variável. Isso pode economizar muita memória da GPU e melhorar a velocidade de computação (originalmente, Q e K exigiam dois kernels Triton para computação, mas agora foram fundidos em um só), alcançando um aumento de velocidade de 2,3x no treinamento de contexto longo. Além disso, o modelo suporta índices int64 porque os índices int32 originais causariam erros de acesso fora dos limites do CUDA durante o treinamento com um contexto muito grande de 500 mil. Portanto, uma precisão maior foi utilizada para evitar esses erros, possibilitando assim o suporte a contextos maiores.

Detalhes da implementação / 1

Detalhes da implementação / 2

Como usar