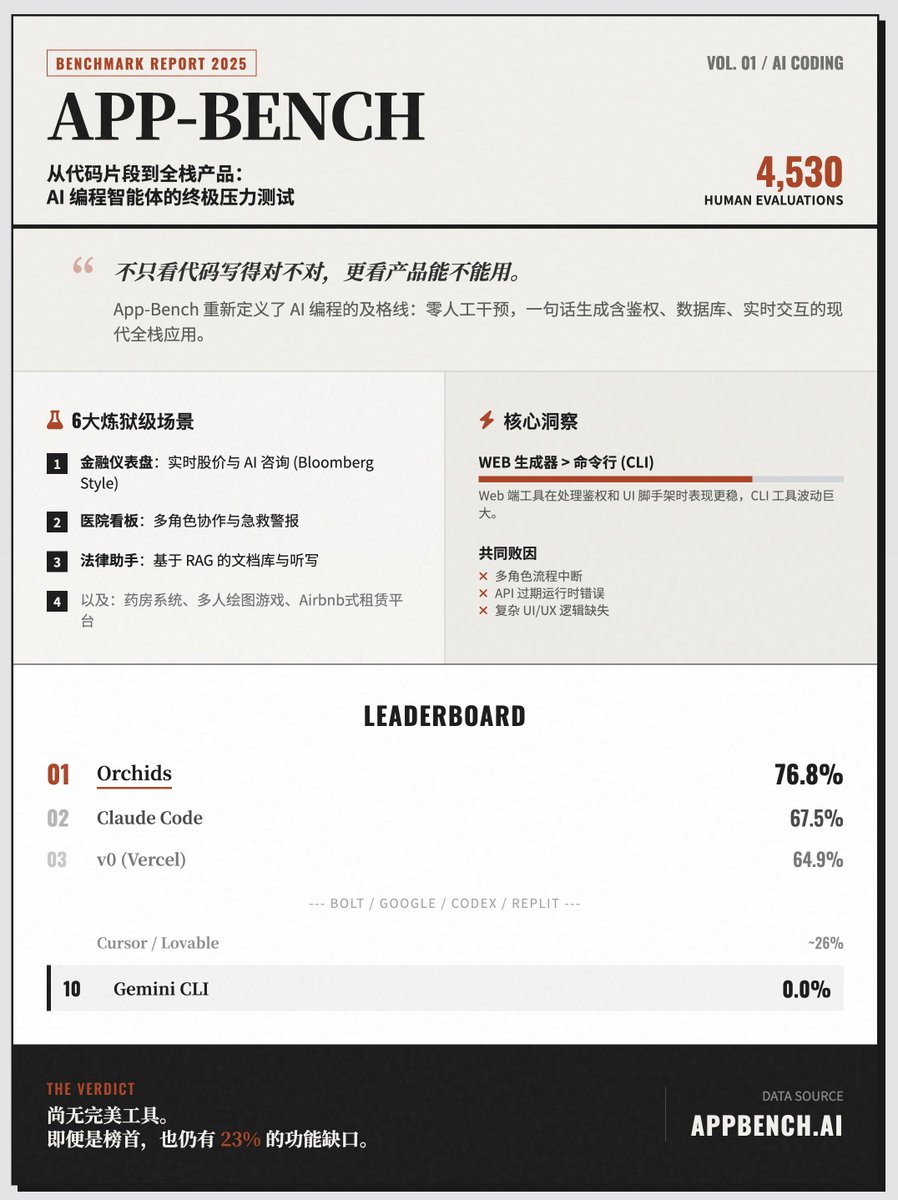

O teste definitivo da "geração com um clique" de aplicativos full-stack por IA, o "App-Bench", classifica o Orchids em primeiro lugar, o Claude Code em segundo, o Cursor em oitavo, o Lovable em nono e o Gemini CLI em zero. O App-Bench é uma estrutura de avaliação comparativa sofisticada com um objetivo central muito claro: avaliar se um agente de programação de IA tem a capacidade de gerar um aplicativo web moderno, completo e utilizável a partir de um único comando em linguagem natural, sem qualquer intervenção humana. Princípios Essenciais de Avaliação: Da "Escrever Código" à "Criar Produtos" O App-Bench não testa mais apenas a capacidade de uma IA de escrever trechos de código; ele examina sua capacidade geral de construir aplicações completas (full-stack). Essas aplicações devem conter os recursos essenciais de um software real: • Assistente de IA integrado • Sincronização de dados em tempo real • Lógica de funções multiusuário • Acionadores automatizados e processos de autenticação Para simular o valor econômico real, a App-Bench selecionou seis aplicações complexas de diferentes áreas para teste, empregando seis cenários de teste desafiadores: • Painel Financeiro: Semelhante ao Terminal Bloomberg, inclui preços de ações em tempo real, gráficos interativos, análises com inteligência artificial e fóruns ao vivo. • Painel de Gestão Hospitalar: Envolve múltiplas funções, incluindo médicos, enfermeiros e administradores, e requer o gerenciamento do status dos leitos, alarmes de emergência e comunicação em tempo real. • Assistente Jurídico: Uma biblioteca de documentos baseada no sistema RAG, com suporte para transcrição de voz e citação de documentos. • Sistema de farmácia: Conecta pacientes e farmacêuticos, gerenciando estoque, pedidos e mensagens privadas. • Jogo Pictionary: Um jogo online multijogador que exige soluções para lógica baseada em turnos, sincronização de tela em tempo real e funcionalidade de repetição. Plataforma de reservas de aluguel: Similar ao Airbnb, inclui filtros de busca, processo de pagamento e upload de mídia. Método de avaliação rigoroso: As pontuações são atribuídas manualmente por desenvolvedores full-stack seniores, e não por máquinas automatizadas. • Escala: Abrange 151 itens de pontuação, com um total de 4.530 avaliações realizadas. • Mecanismo: Cada ferramenta tem três chances, e o melhor resultado é registrado. Principais conclusões e insights: Situação atual do setor: Mesmo as ferramentas de ponta não conseguem alcançar resultados perfeitos. As ferramentas com melhor desempenho atualmente abrangem apenas cerca de 77% das funções essenciais, e a maioria apresenta lacunas significativas no processamento de tarefas complexas (como interações entre múltiplos usuários e lógica de interface do usuário complexa). • Comparação de tipos de ferramentas: Geradores baseados na Web geralmente apresentam melhor desempenho do que ferramentas de linha de comando. As ferramentas da Web são mais estáveis no gerenciamento de autenticação e estruturas básicas de interface do usuário, enquanto as ferramentas de linha de comando exibem maiores flutuações de desempenho. • Principais causas de falha: funcionalidades ausentes, interrupção de processos com múltiplas funções, erros de tempo de execução causados por APIs expiradas e problemas de UI/UX que afetam a usabilidade. Classificação de desempenho (Top 10) 1. Orquídeas 76,8% 2. Código Claude 67,5% 3. v0 (Vercel) 64,9% 4. Parafuso 53,6% 5. Google AI Studio 50,3% 6. Códice 38,4% 7. Replicado 35,1% 8. Cursor 27,8% 9. Adorável 25,8% 10. Gemini CLI 0,0% Visite o site

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.