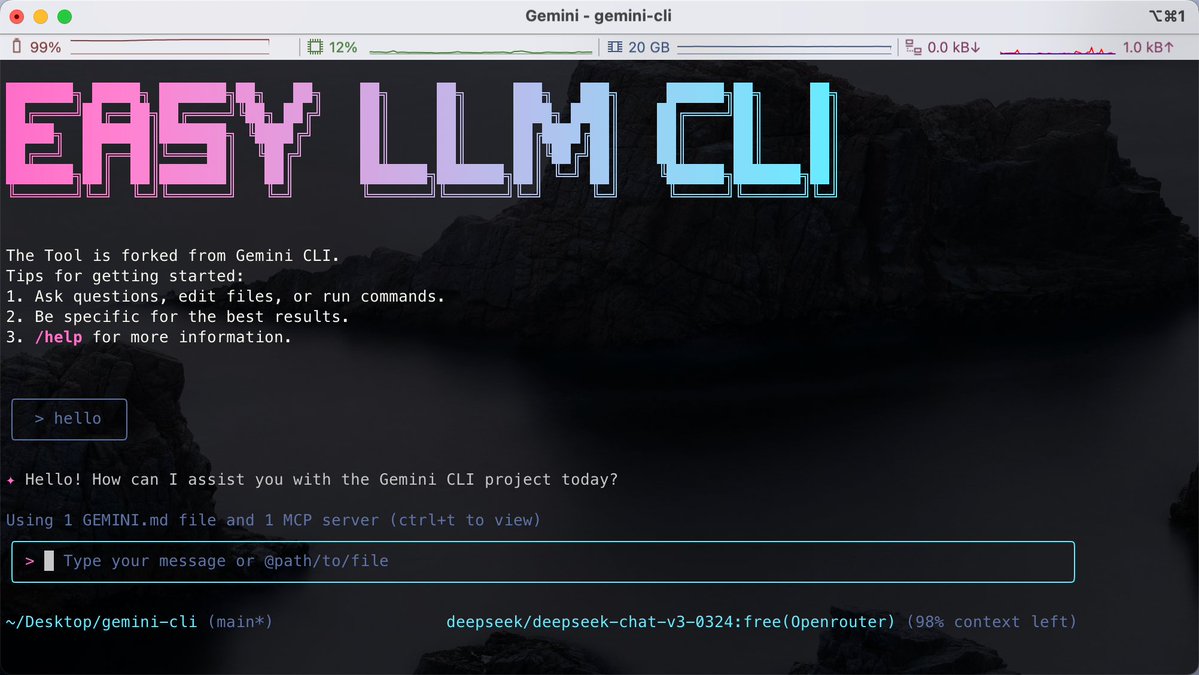

Para quem está acostumado a escrever código no terminal, o desafio geralmente reside no fato de que diferentes ferramentas de IA estão vinculadas a modelos específicos, o que dificulta a alternância flexível entre vários modelos complexos dentro da mesma linha de comando. Descobri o projeto de código aberto Easy LLM CLI no GitHub. É um desenvolvimento secundário baseado no Google Gemini CLI, mas que rompe com as limitações de um modelo único. É compatível com diversos modelos, como Gemini, OpenAI, Claude e DeepSeek, e suporta até mesmo o acesso a modelos locais através do Ollama. Ele não apenas oferece suporte ao MCP (Model Context Protocol) para ampliar as capacidades da ferramenta, mas também pode ler diretamente o contexto do repositório de código para nos ajudar a executar operações Git automaticamente, refatorar código ou gerar aplicativos. GitHub: https://t.co/MofOBwdQdw Requer um ambiente Node.js e pode ser executado diretamente usando npx sem instalação. Você pode personalizar o backend do modelo que deseja usar através de uma configuração simples de variáveis de ambiente. Esta solução é adequada para desenvolvedores que não desejam ficar vinculados a um fornecedor específico e preferem executar tarefas de forma eficiente no terminal.

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.