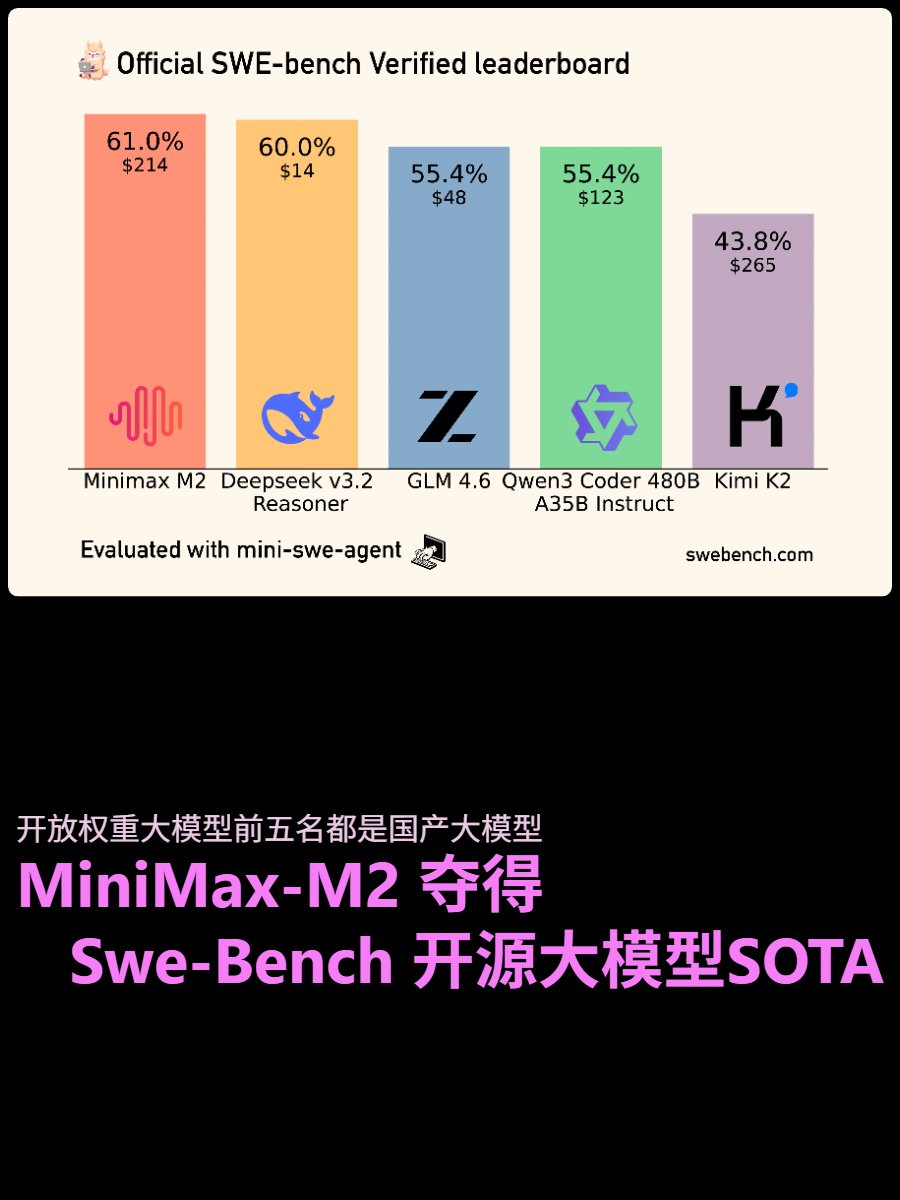

Acabei de conferir os resultados mais recentes dos testes SWE-Benchverified, e o MiniMax-M2 se tornou o modelo de peso aberto com a maior pontuação! O Minimax M2 é atualmente o modelo de código aberto mais poderoso, com excelentes capacidades de processamento. No entanto, a documentação oficial indica que os testes consumiram muitos tokens. Mesmo assim, sua capacidade de lidar com tarefas longas é realmente excepcional, mantendo a estabilidade mesmo com mais de 200 etapas. O Deepseek v3.2 Reasoning é uma excelente segunda opção, com um preço incrivelmente baixo, embora seja um pouco lento. Se você não tem pressa, sua relação custo-benefício é imbatível. Você pode obter excelentes resultados em cerca de 100 etapas. O GLM 4.6 apresenta um desempenho excelente desta vez, oferecendo alta velocidade, preço acessível e bom desempenho, tornando-se uma opção de alto nível em termos de custo-benefício. Seu desempenho é praticamente equivalente ao do qwen3 coder 480b a35b, porém com um tempo de resposta muito mais rápido. De forma geral, os modelos de código aberto estão progredindo bastante rápido. Embora ainda estejam atrás de modelos de código fechado, como o Gemini 3 Pro e o Claude 4.5 Opus, eles estão constantemente alcançando os principais modelos comerciais. #SWEBench #AvaliaçãoIA #ModeloGrande #Minimax #DeepSeek #GLM #ModeloDeCódigoAberto #DesempenhoIA #GeraçãoDeCódigo

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.