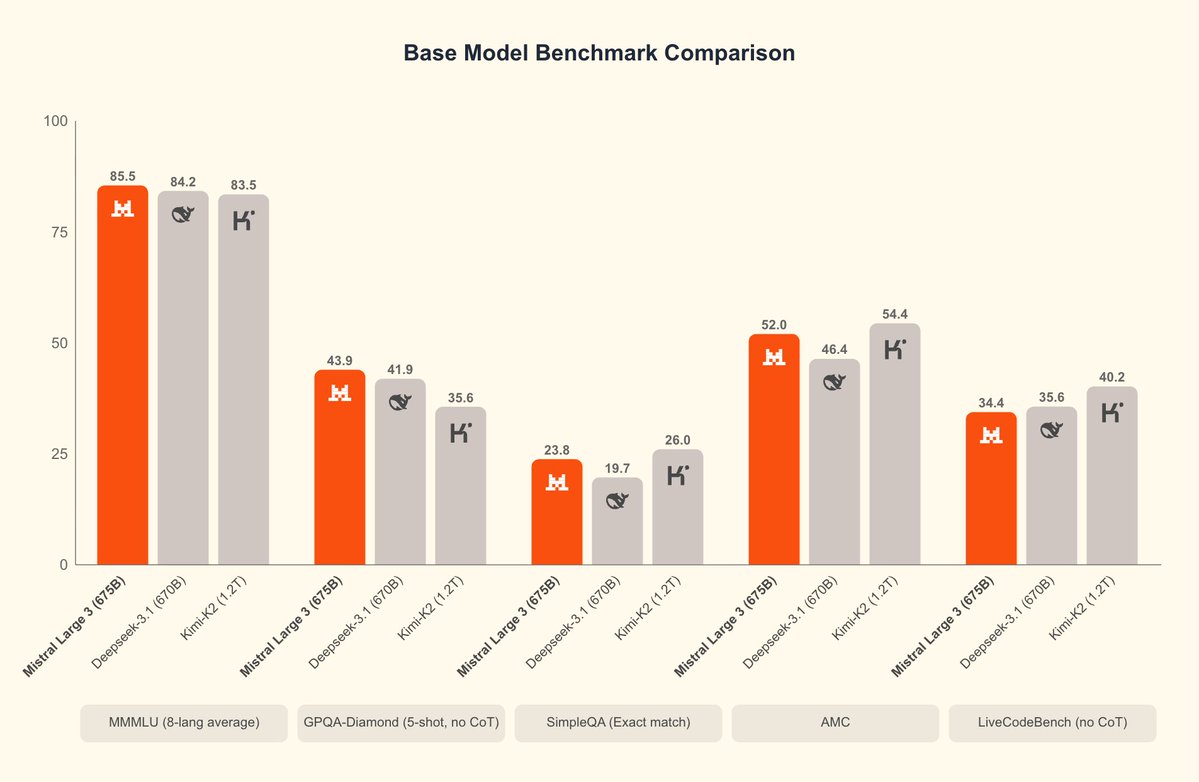

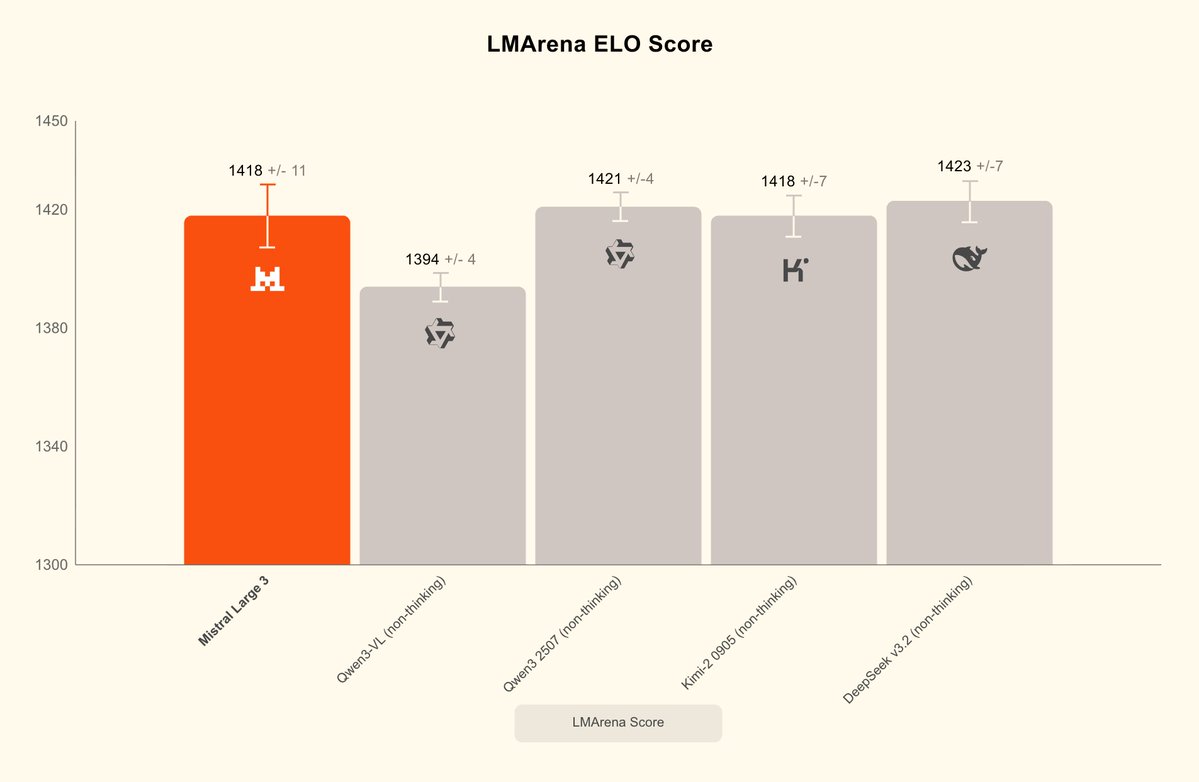

A Mistral acaba de lançar o Mistral 3 e seu MoE superdimensionado mais poderoso: o Mistral Large 3, que se destaca na compreensão de imagens e diálogos multilíngues. Mistral Large 3, total de parâmetros 675B, ativação 41B, libera simultaneamente os pesos base e instruídos; a versão de inferência será lançada posteriormente. Oferece o formato de compressão NVFP4, permitindo inferência de alta eficiência em um único nó com 8×A100/H100 ou Blackwell NVL72, e suporta TensorRT-LLM, SGLang, separação de pré-preenchimento/decodificação, decodificação especulativa, etc. A série Ministral 3 possui três modelos. Os modelos 3B, 8B e 14B oferecem três variantes cada: base, instrução e raciocínio, e todos suportam entrada de imagem. Oferece a melhor relação desempenho/preço da sua classe, igualando o desempenho de modelos semelhantes, mas gerando uma ordem de magnitude menor de tokens. A versão de raciocínio pode atingir 85% AIME '25 no 14B. #Mistral3 #MistralGrande3

Blomistral.ai/news/mistral-3TmA huggingface.co/collections/mi…KgF3J