O amor vem da França, o modelo Mistral 3 Large foi lançado! No entanto, parece que chegou atrasado? Desta vez, o Mistral 3 Large foi finalmente atualizado para a arquitetura MoE, com um total de 675 bilhões de parâmetros, 41 bilhões de parâmetros de ativação e um comprimento de contexto de 256 KB. Eles mesmos testaram e descobriram que o modelo base teve um desempenho superior ao DeepSeek-V3.1. No entanto, ainda tenho algumas dúvidas, pois a série Mistral não me impressionou muito em testes anteriores. Além disso, os modelos Ministral 14B, 8B e 3B também foram lançados simultaneamente. A equipe oficial comparou-os diretamente com os modelos Qwen3 de tamanho e parâmetros semelhantes. Se muitos alunos estiverem interessados, considerarei aplicar um teste simples a todos.

Parâmetros do modelo / 1

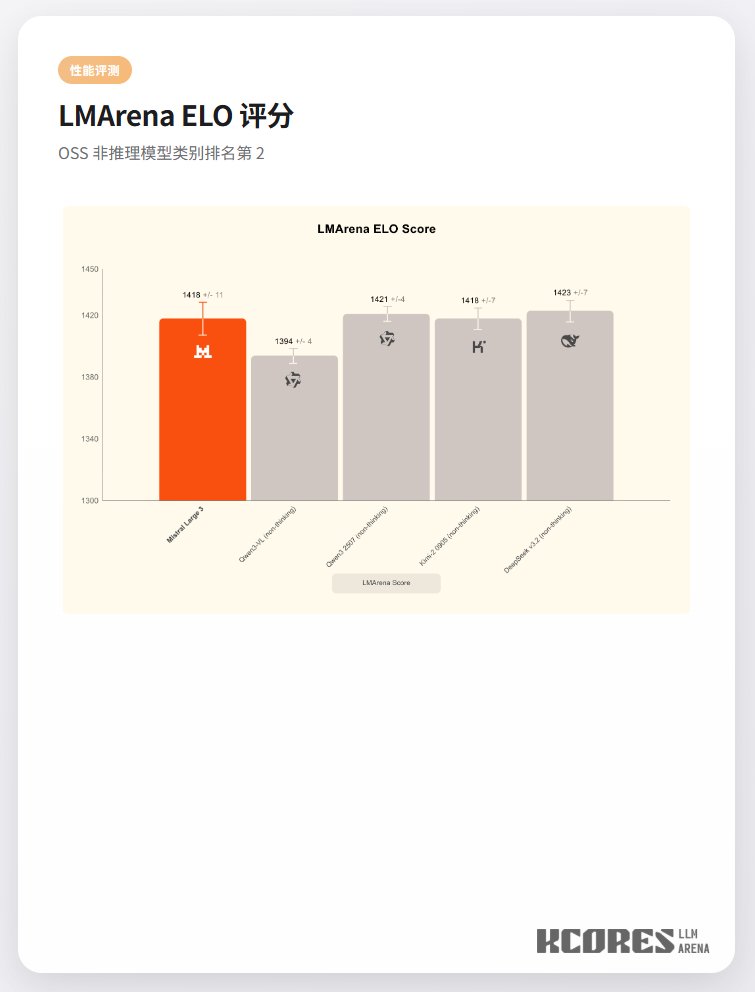

Desempenho do modelo