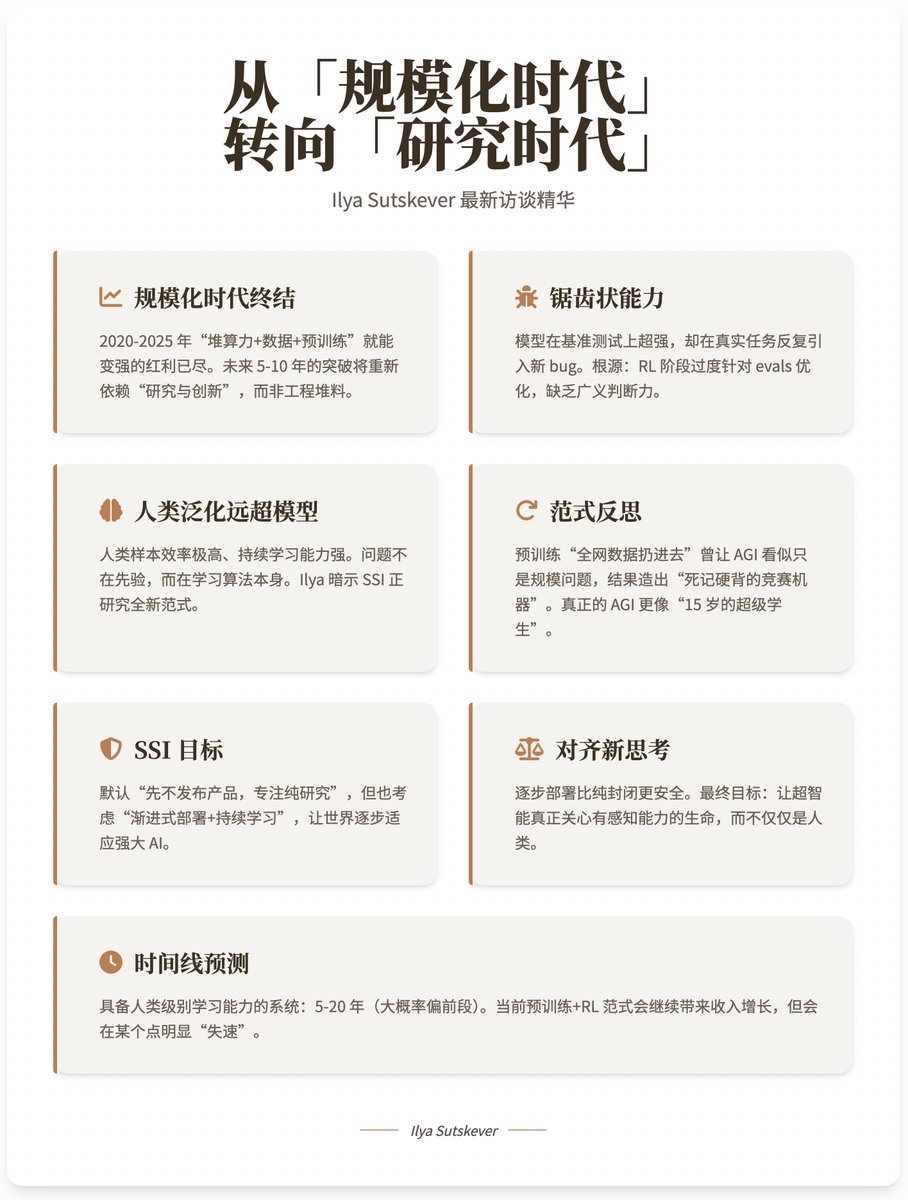

Ilya Sutskever – Estamos passando da "era da escalabilidade" para a "era da pesquisa". As entrevistas com @ilyasut e @dwarkesh_sp finalmente chegaram! Esta é a entrevista pública mais completa desde que deixaram a OpenAI, com o misterioso fundador da @ssi e ex-cientista-chefe da OpenAI. Vamos ver quais novas perspectivas eles trazem! 👁 1. A era da escalabilidade acabou. • O período de 2020 a 2025 é a "era de escalabilidade", onde você pode se fortalecer progressivamente acumulando poder computacional, dados e pré-treinamento. • Com os retornos marginais em forte declínio, simplesmente aumentar o poder computacional em 100 vezes não trará uma mudança qualitativa. Os avanços nos próximos 5 a 10 anos dependerão novamente de "pesquisa e inovação", em vez de engenharia de materiais. Ilya prevê explicitamente que, após 2025, retornaremos à "era da pesquisa" de 2012-2020, só que desta vez todos terão maior poder computacional. 2. A causa principal das capacidades "irregulares" do modelo atual estarem dessincronizadas com o desempenho no mundo real: O modelo tem um desempenho excepcional em testes de benchmark, mas em tarefas do mundo real, ele introduz repetidamente novos bugs e requer correções iterativas. Explicação de Ilya: • A otimização excessiva das avaliações durante a fase de RL (uma "estratégia de manipulação de recompensas" por pesquisadores humanos) leva à especialização excessiva. • Semelhante a "alunos que praticaram programação competitiva por apenas 10.000 horas": eles têm habilidades sólidas, mas carecem de "bom gosto" e de um senso de julgamento amplo. O verdadeiro gargalo não é o poder computacional, mas sim o fato de a capacidade de generalização ser muito inferior à dos humanos. 3. Por que os humanos generalizam muito mais do que os modelos? As amostras humanas são extremamente eficientes, possuem forte capacidade de aprendizado contínuo e demonstram notável robustez. A evolução fornece um conhecimento prévio extremamente forte (visão, movimento, função de valor intrínseco), mas os humanos ainda superam em muito os modelos em novos campos como linguagem, matemática e programação → indicando que o problema não está no conhecimento prévio, mas na superioridade do próprio algoritmo de aprendizagem. Ilya insinuou que ele e a SSI estão pesquisando um novo paradigma de aprendizado de máquina que pode atingir níveis quase humanos de aprendizado contínuo e generalização (mas os detalhes não podem ser divulgados devido à concorrência). 4. Reflexões sobre o paradigma “Pré-treinamento + RL”: O sucesso do pré-treinamento reside em “não precisar selecionar dados, basta inserir dados de toda a rede”. No entanto, isso levou as pessoas a acreditarem erroneamente que "a IAG (Inteligência Artificial Geral) é simplesmente pré-treinada para um tamanho suficientemente grande", resultando na criação de "máquinas de competição de aprendizado mecânico" em vez de uma inteligência verdadeiramente flexível. Uma verdadeira Inteligência Artificial Geral (IAG) se assemelha mais a um "superaluno de 15 anos": extremamente forte em habilidades básicas, mas conhecimentos e habilidades específicas ainda precisam ser adquiridos por meio de implantação e aprendizado contínuo. 5. O verdadeiro objetivo da SSI: Superinteligência Segura e Direta O plano padrão continua sendo "não lançar o produto primeiro, mas focar em pesquisa pura até que um sistema superinteligente inerentemente seguro seja desenvolvido antes de lançá-lo por completo". No entanto, Ilya insinuou pela primeira vez que também está considerando seriamente um caminho de "implantação gradual + aprendizado contínuo com o mundo real" porque: Permitir que o mundo se adapte gradualmente à inteligência artificial poderosa pode ser mais seguro do que desenvolvê-la em um sistema completamente fechado. É provável que a superinteligência não seja um estado final de "onisciência e onipotência únicas", mas sim um sistema capaz de aprender e evoluir continuamente em sua função, assim como um ser humano. 6. Principais atualizações para alinhar perspectivas: A maior mudança de pensamento de Ilya no último ano: **A implementação gradual e fazer com que o mundo realmente sinta o poder da IA são mais importantes do que a mera contemplação.** Ele prevê que, quando a IA realmente começar a "se sentir poderosa", todas as empresas líderes ficarão repentinamente extremamente paranoicas em relação à segurança. • O objetivo final do alinhamento: fazer com que a superinteligência realmente se importe com os seres sencientes, não apenas com os "humanos", porque a maioria dos seres sencientes no futuro serão IA. Uma solução estável a longo prazo (da qual ele não gosta, mas admite que pode ser necessária): integração profunda entre humanos e máquinas (nível Neuralink++), permitindo que os humanos participem diretamente e compreendam o processo de tomada de decisão da IA. 7. Previsão de Cronograma: Sistemas com capacidades de aprendizado em nível humano que podem levar à superinteligência: 5 a 20 anos (provavelmente o período mais curto). O paradigma atual de pré-treinamento + RL continuará impulsionando o crescimento da receita, mas claramente "estagnará" em algum momento e não conseguirá atingir uma generalização verdadeiramente em nível humano. 8. A Essência do Bom Gosto em Pesquisa: Uma boa linha de pesquisa deve satisfazer simultaneamente o seguinte: • Baseado em uma analogia válida do cérebro humano • Simples, elegante e sem qualquer traço de feiura • Uma "convicção de cima para baixo" que se mantém verdadeira sob múltiplas perspectivas Esse tipo de experiência permite que você persista na depuração em vez de desistir quando os experimentos continuam falhando e todos os dados dizem "você está errado". Link do vídeo no YouTube:

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.