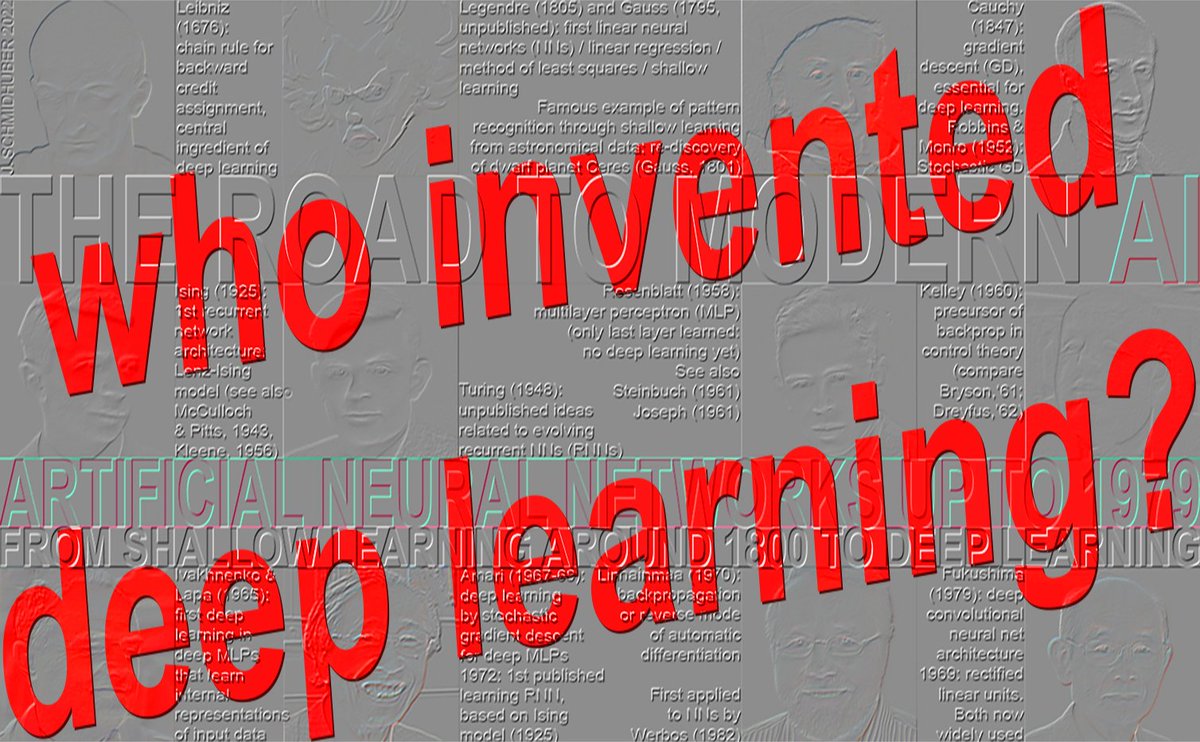

Quem inventou o aprendizado people.idsia.ch/~juergen/who-i…aJfpTfQSNk Cronologia: 1965: primeiro aprendizado profundo (Ivakhnenko e Lapa, 8 camadas em 1971) 1967-68: aprendizado profundo de ponta a ponta por descida de gradiente estocástica (Amari, 5 camadas) 1970: retropropagação (Linnainmaa, 1970) para redes neurais (Werbos, 1982): raramente >5 camadas (década de 1980) 1991-93: pré-treinamento não supervisionado para redes neurais profundas (Schmidhuber, outros, mais de 100 camadas) 1991-2015: aprendizagem residual profunda (Hochreiter, outros, mais de 100 camadas) 1996-: aprendizado profundo sem gradientes (mais de 100 camadas) ★ 1965: primeiro aprendizado profundo (Ivakhnenko e Lapa, 8 camadas em 1971) O aprendizado bem-sucedido em arquiteturas de redes feedforward profundas começou em 1965 na Ucrânia (na época URSS), quando Alexey Ivakhnenko e Valentin Lapa introduziram os primeiros algoritmos de aprendizado geral e funcional para perceptrons multicamadas profundos (MLPs) ou redes neurais feedforward (FNNs) com muitas camadas ocultas (já contendo as portas multiplicativas agora populares) [DEEP1-2][DL1-2][DLH][WHO5]. Um artigo de 1971 [DEEP2] descreveu uma rede de aprendizagem profunda com 8 camadas, treinada por seu método altamente citado que ainda era popular no novo milênio [DL2]. Dado um conjunto de treinamento de vetores de entrada com vetores de saída alvo correspondentes, as camadas são incrementalmente construídas e treinadas por análise de regressão. Em uma fase de ajuste fino, as unidades ocultas supérfluas são podadas por meio de regularização com a ajuda de um conjunto de validação separado [DEEP2][DLH]. Isso simplifica a rede e melhora sua generalização em dados de teste não vistos. O número de camadas e unidades por camada é aprendido de forma dependente do problema. Esta é uma poderosa generalização da rede neural Gauss-Legendre original de 2 camadas (1795-1805) [DLH]. Ou seja, Ivakhnenko e seus colegas já utilizavam o conexionismo com camadas ocultas adaptativas duas décadas antes de o termo "conexionismo" se popularizar na década de 1980. Assim como as redes neurais profundas posteriores, suas redes aprendiam a criar representações internas, hierárquicas e distribuídas dos dados recebidos. Ele não as chamava de redes neurais de aprendizado profundo, mas era exatamente isso que elas eram. O trabalho pioneiro de Ivakhnenko foi repetidamente plagiado por pesquisadores que posteriormente receberam o Prêmio Turing [DLP][NOB]. Por exemplo, a profundidade do treinamento camada a camada de Ivakhnenko, de 1971 [DEEP2], era comparável à profundidade do treinamento camada a camada de Hinton e Bengio, de 2006, publicado 35 anos depois [UN4][UN5], sem qualquer comparação com o trabalho original [NOB] — realizado quando o poder computacional era milhões de vezes maior. Da mesma forma, LeCun et al. [LEC89] publicaram técnicas de poda de redes neurais sem fazer referência ao trabalho original de Ivakhnenko sobre poda de redes neurais profundas. Mesmo em seus "levantamentos" muito posteriores sobre aprendizado profundo [DL3][DL3a], os premiados deixaram de mencionar as próprias origens do aprendizado profundo [DLP][NOB]. Ivakhnenko e Lapa também demonstraram que é possível aprender pesos apropriados para unidades ocultas usando apenas informações disponíveis localmente, sem exigir uma passagem reversa biologicamente implausível [BP4]. Seis décadas depois, Hinton atribuiu essa conquista a si mesmo [NOB25a]. Como as redes de Ivakhnenko se comparam às redes feedforward multicamadas ainda mais antigas, sem aprendizado profundo? Em 1958, Frank Rosenblatt estudou perceptrons multicamadas (MLPs) [R58]. Seus MLPs tinham uma primeira camada sem aprendizado, com pesos aleatórios, e uma camada de saída adaptativa. Isso ainda não era aprendizado profundo, pois apenas a última camada aprendia [DL1]. Os MLPs também foram discutidos em 1961 por Karl Steinbuch [ST61-95] e Roger David Joseph [R61]. Veja também o Pandemonium multicamadas de Oliver Selfridge [SE59] (1959). Em 1962, Rosenblatt et al. chegaram a escrever sobre "retropropagação de erros" em um MLP com uma camada oculta [R62], seguindo as ideias preliminares de Joseph de 1961 sobre o treinamento de unidades ocultas [R61], mas Joseph e Rosenblatt não tinham um algoritmo de aprendizado profundo funcional para MLPs profundos. O que agora é chamado de retropropagação é bastante diferente e foi publicado pela primeira vez em 1970 por Seppo Linnainmaa [BP1-4]. Por que o aprendizado profundo surgiu na URSS em meados da década de 1960? Naquela época, o país liderava muitos campos importantes da ciência e da tecnologia, principalmente no espaço: primeiro satélite (1957), primeiro objeto feito pelo homem em um corpo celeste (1959), primeiro homem no espaço (1961), primeira mulher no espaço (1962), primeiro robô a pousar em um corpo celeste (1965), primeiro robô em outro planeta (1970). A URSS também detonou a maior bomba atômica da história (1961) e abrigava muitos matemáticos de ponta, com financiamento suficiente para pesquisas matemáticas de vanguarda, cuja enorme importância só seria revelada décadas depois. As outras seções mencionadas acima (1967, 1970, 1991-93, 1991-2015, 1996) são abordadas por [WHO5]: Quem inventou o aprendizado profundo? Nota Técnica IDSIA-16-25, IDSIA, novembro de 2025. REFERÊNCIAS SELECIONADAS (muitas referências adicionais em [WHO5] - veja o link acima): [BP1] S. Linnainmaa. A representação do erro de arredondamento cumulativo de um algoritmo como uma expansão de Taylor dos erros de arredondamento locais. Dissertação de Mestrado (em finlandês), Univ. Helsinki, 1970. Ver capítulos 6-7 e código FORTRAN nas páginas 58-60. Ver também BIT 16, 146-160, 1976. Link. A primeira publicação sobre retropropagação "moderna", também conhecida como modo reverso de diferenciação automática. [BP4] J. Schmidhuber (2014). Quem inventou a retropropagação? [BPA] HJ Kelley. Teoria do gradiente de trajetórias de voo ótimas. ARS Journal, Vol. 30, No. 10, pp. 947-954, 1960. Precursor da retropropagação moderna [BP1-4]. [DEEP1] Ivakhnenko, AG e Lapa, VG (1965). Dispositivos de previsão cibernética. CCM Information Corporation. Primeiros Deep Learners funcionais com muitas camadas, aprendendo representações internas. [DEEP1a] Ivakhnenko, Alexey Grigorevich. O método de grupo de tratamento de dados; um rival do método de aproximação estocástica. Controle Automático Soviético 13 (1968): 43-55. [DEEP2] Ivakhnenko, AG (1971). Teoria polinomial de sistemas complexos. IEEE Transactions on Systems, Man and Cybernetics, (4):364-378. [DL1] J. Schmidhuber, 2015. Aprendizado profundo em redes neurais: uma visão geral. Redes Neurais, 61, 85-117. Recebeu o primeiro prêmio de Melhor Artigo já concedido pelo periódico Redes Neurais, fundado em 1988. [DL2] J. Schmidhuber, 2015. Aprendizagem profunda. Scholarpedia, 10(11):32832. [DL3] Y. LeCun, Y. Bengio, G. Hinton (2015). Aprendizado profundo. Nature 521, 436-444. Um "levantamento" do aprendizado profundo que não menciona os trabalhos pioneiros do aprendizado profundo [DLP][NOB]. [DL3a] Y. Bengio, Y. LeCun, G. Hinton (2021). Turing Lecture: Deep Learning for AI. Communications of the ACM, julho de 2021. Outro "levantamento" sobre aprendizado profundo que não menciona os trabalhos pioneiros de aprendizado profundo [DLP][NOB]. [DLH] J. Schmidhuber. História anotada da IA moderna e do aprendizado profundo. Relatório técnico IDSIA-22-22, IDSIA, Lugano, Suíça, 2022. Preprint arXiv:2212.11279. [DLP] J. Schmidhuber. Como 3 laureados com o Prêmio Turing republicaram métodos e ideias importantes cujos criadores eles não creditaram. Relatório Técnico IDSIA-23-23, Swiss AI Lab IDSIA, 2023. [GD'] C. Lemarechal. Cauchy e o Método do Gradiente. Doc Math Extra, pp. 251-254, 2012. [GD''] J. Hadamard. Memória sobre o problema de análise relativo ao equilíbrio das placas elásticas encastradas. Memórias apresentadas por diversos sábios estranhos à Academia de Ciências do Instituto de França, 33, 1908. [GDa] YZ Tsypkin (1966). Adaptação, treinamento e auto-organização de sistemas de controle automático, Avtomatika I Telemekhanika, 27, 23-61. Sobre aprendizagem online baseada em gradiente descendente para sistemas não lineares. [GDb] YZ Tsypkin (1971). Adaptação e Aprendizagem em Sistemas Automáticos, Academic Press, 1971. Sobre aprendizagem online baseada em descida de gradiente para sistemas não lineares. [GD1] SI Amari (1967). Uma teoria de classificador de padrões adaptativo, IEEE Trans, EC-16, 279-307 (versão japonesa publicada em 1965). Provavelmente o primeiro artigo sobre o uso de descida de gradiente estocástica [STO51-52] para aprendizado em redes neurais multicamadas (sem especificar o método de descida de gradiente específico agora conhecido como modo reverso de diferenciação automática ou retropropagação [BP1]). [GD2] SI Amari (1968). Teoria da Informação—Teoria Geométrica da Informação, Kyoritsu Publ., 1968 (em japonês, ver páginas 119-120). Contém resultados de simulação computacional para uma rede de cinco camadas (com 2 camadas modificáveis) que aprende representações internas para classificar classes de padrões não linearmente separáveis. [GD2a] S. Saito (1967). Dissertação de mestrado, Escola de Engenharia, Universidade de Kyushu, Japão. Implementação do método de descida de gradiente estocástico de Amari de 1967 para perceptrons multicamadas [GD1]. (S. Amari, comunicação pessoal, 2021.) [NOB] J. Schmidhuber. Um Prêmio Nobel para o Plágio. Relatório Técnico IDSIA-24-24 (7 de dezembro de 2024, atualizado em outubro de 2025). [NOB25a] G. Hinton. Palestra Nobel: Máquinas de Boltzmann. Rev. Mod. Phys. 97, 030502, 25 de agosto de 2025. Uma das muitas afirmações problemáticas nesta palestra é a seguinte: "As máquinas de Boltzmann não são mais usadas, mas foram historicamente importantes [...] Na década de 1980, elas demonstraram que era possível aprender pesos apropriados para neurônios ocultos usando apenas informações disponíveis localmente, sem exigir uma passagem reversa biologicamente implausível." Novamente, Hinton omite Ivakhnenko, que havia demonstrado isso duas décadas antes, na década de 1960 [DEEP1-2]. [WHO5] J. Schmidhuber (Blog de IA, 2025). Quem inventou o aprendizado profundo? Nota Técnica IDSIA-16-25, IDSIA, novembro de 2025. Veja o link acima.

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.