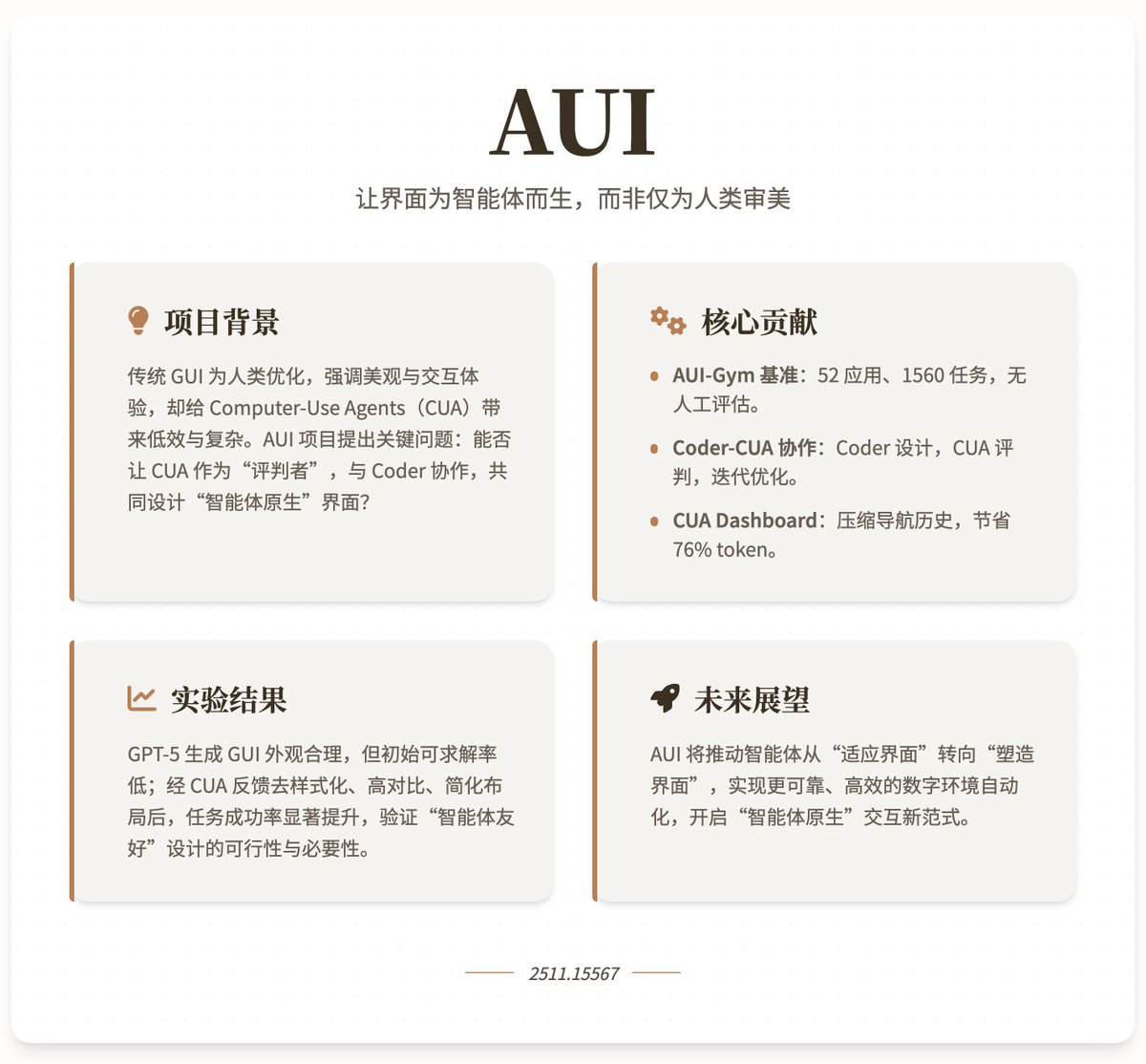

Com o Gemini 3.0 Pro e o Claude Opus 4.5 continuando a aprimorar seus recursos de geração de interface do usuário, ainda existe futuro para desenvolvedores front-end? 😂 Brincadeirinha 😄 Os modelos de IA são tão bons em gerar interfaces de usuário que são muito fáceis de usar, mas será que as interfaces que eles geram são fáceis de usar para os agentes de IA? A pesquisa mais recente, "AUI", da Universidade de Oxford, da Universidade Nacional de Singapura e da Microsoft, explora como usar Agentes de Uso de Computador (CUA) e modelos de linguagem de programação para gerar e otimizar automaticamente GUIs (Interfaces Gráficas do Usuário), tornando a interface mais adequada para agentes inteligentes do que para humanos. Contexto e Motivação do Projeto: As GUIs tradicionais são otimizadas principalmente para humanos, enfatizando a estética, a usabilidade e o apelo visual (como animações e layouts coloridos). Isso força os agentes automatizados a imitarem o comportamento humano durante a operação, aumentando a complexidade e a ineficiência. Com os avanços nos modelos de linguagem de programação para geração automática de websites funcionais, o projeto AUI levanta uma questão fundamental: os agentes automatizados podem atuar como "juízes" para auxiliar os programadores no design automático de GUIs? Esta colaboração visa criar interfaces "nativas para agentes", priorizando a eficiência da tarefa em detrimento da estética humana. Por meio do feedback dos agentes, o projeto espera alcançar uma automação mais confiável e eficiente de ambientes digitais, impulsionando uma mudança no comportamento dos agentes, de uma adaptação passiva para uma atuação ativa na criação de seus ambientes. Principais contribuições 1. Plataforma de Benchmark AUI-Gym: Este é um benchmark projetado especificamente para desenvolvimento e teste automatizado de GUIs, abrangendo 52 aplicações em 6 domínios (Aplicativo, Página Inicial, Jogo, Interativo, Ferramenta e Utilitário). O projeto utiliza o GPT-5 para gerar 1560 tarefas que simulam cenários do mundo real (30 por aplicação) e garante a qualidade por meio de verificação humana. Essas tarefas enfatizam a completude funcional e a interatividade, como a criação de hábitos e a visualização de gráficos no aplicativo "Micro Habit Tracker". Cada tarefa é equipada com um validador baseado em regras que verifica, via JavaScript, se a tarefa é executável em uma determinada interface, permitindo uma avaliação confiável sem intervenção humana. As métricas do benchmark incluem: • Completude Funcional (CF): Avaliar se a interface suporta a tarefa (ou seja, se existe um verificador de funções), como uma medida básica de usabilidade. • Taxa de Sucesso do CUA (SR): Avalia a taxa média de conclusão do CUA durante as tarefas de navegação, refletindo a eficiência real da execução. 2. Framework de Colaboração Coder-CUA: O framework posiciona o Coder (modelo de linguagem de programação) como o "designer", responsável por inicializar e revisar iterativamente a GUI; o CUA atua como o "juiz", fornecendo orientação por meio da resolução de tarefas e feedback de navegação. Fluxo de trabalho específico: O programa gera um site HTML inicial a partir das consultas do usuário (incluindo nome, objetivo, função e tema). • Site de teste CUA: Primeiro, verifique a solucionabilidade da tarefa (colete tarefas inviáveis como feedback funcional) e, em seguida, execute a navegação (por meio de ações atômicas, como cliques e entrada de dados). • Ciclo de feedback: Tarefas insolúveis são resumidas em um resumo da linguagem para que os programadores aprimorem a funcionalidade; trajetórias de navegação são condensadas em feedback visual por meio do Painel CUA para ajudar os programadores a otimizar o layout. 3. Painel de Controle do CUA: Utilizado para condensar o histórico de navegação em várias etapas do CUA (incluindo capturas de tela, ações e resultados) em uma única imagem de 1920×1080. Ao recortar adaptativamente as principais áreas de interação, reduz os elementos visuais em uma média de 76,2%, mantendo as informações necessárias (como objetivos da tarefa, etapas e pontos de falha). Isso torna o feedback mais interpretável, permitindo que os programadores identifiquem problemas (como baixo contraste ou layouts complexos) e façam revisões direcionadas, como remover estilos, aumentar o contraste ou simplificar a estrutura. Resultados experimentais mostram que programadores avançados (como o GPT-5) conseguem gerar GUIs visualmente atraentes, mas sua completude funcional inicial é baixa (muitas tarefas são insolúveis). Isso pode ser rapidamente melhorado por meio de feedback de falhas. A navegação do agente é o principal gargalo; mesmo com funcionalidade completa, a taxa de sucesso inicial é baixa. No entanto, por meio de iteração colaborativa (como desestilização, alto contraste e layout simplificado), a taxa de sucesso melhora significativamente, demonstrando que o feedback do agente aumenta a robustez e a eficiência da GUI. O projeto enfatiza que os agentes preferem interfaces simples e orientadas a funções em vez de complexidade visual semelhante à humana. Endereço do projeto de pesquisa

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.