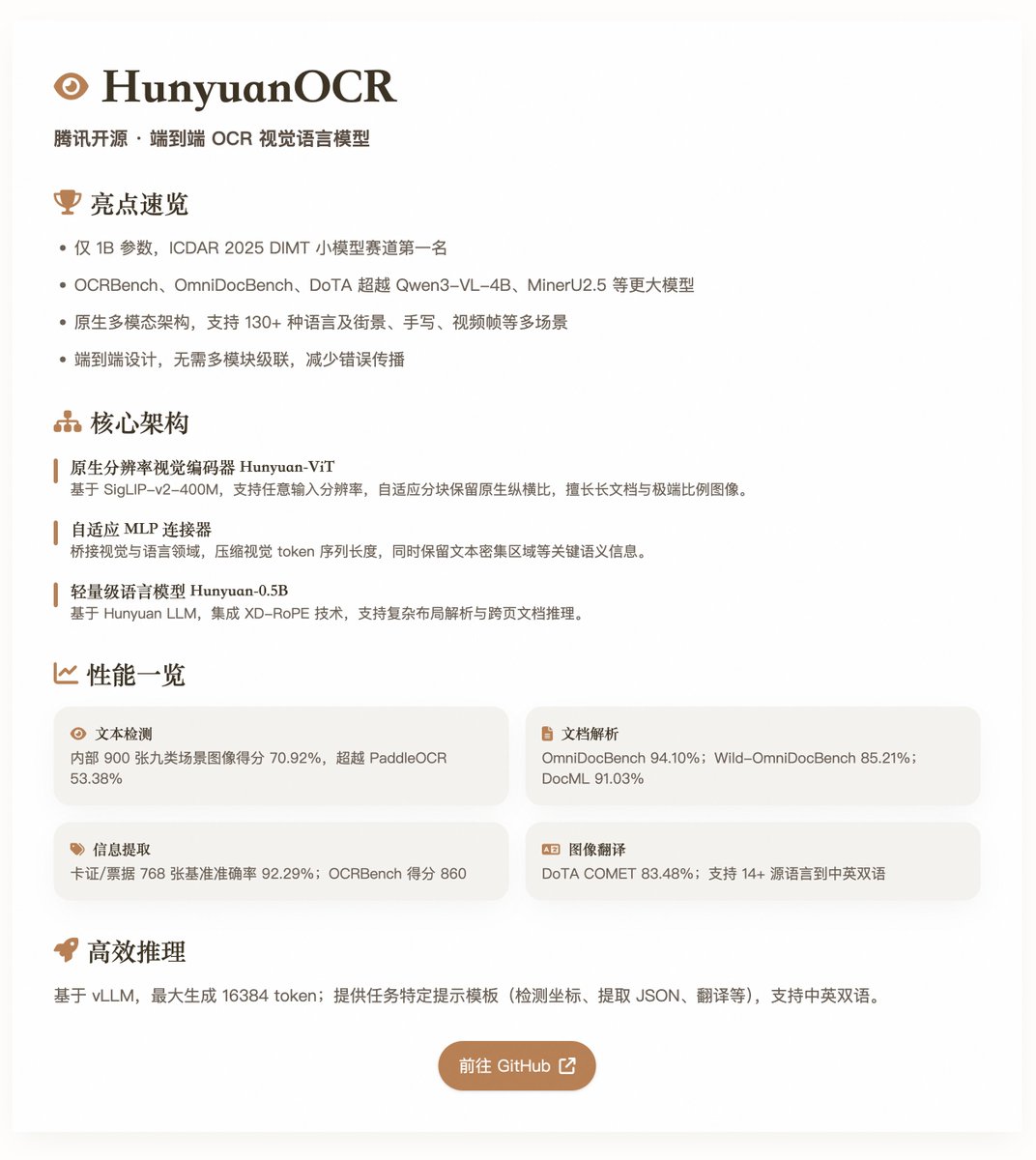

HunyuanOCR: Modelo de linguagem visual OCR de código aberto e completo da Tencent O HunyuanOCR, com um tamanho de parâmetro de apenas 1 bilhão, alcançou desempenho líder em múltiplos testes de benchmark de OCR. Baseado em uma arquitetura multimodal nativa, ele é otimizado para tarefas de OCR e adequado para cenários como detecção de texto, análise sintática de documentos, extração de informações, resposta a perguntas visuais e tradução de texto para imagem. O modelo conquistou o primeiro lugar no Desafio ICDAR 2025 DIMT (categoria de modelos pequenos) e superou muitos modelos de maior escala, como o Qwen3-VL-4B e o MinerU2.5, em benchmarks como OCRbench, OmniDocBench e DoTA. Principais características e arquitetura O HunyuanOCR emprega um design de modelo de linguagem visual puro de ponta a ponta, evitando o encadeamento de múltiplos módulos dos sistemas OCR tradicionais, reduzindo assim a propagação de erros e os custos de manutenção. Sua arquitetura compreende três componentes principais: • Codificador Visual de Resolução Nativa (Hunyuan-ViT): Baseado no modelo pré-treinado SigLIP-v2-400M com aproximadamente 0,4 bilhão de parâmetros, ele suporta resoluções de entrada arbitrárias. Preserva a proporção original das imagens por meio de um mecanismo adaptativo de divisão de blocos e se destaca no processamento de documentos longos, imagens com proporções extremas e documentos digitalizados de baixa qualidade. • Conector MLP adaptativo: Servindo como uma ponte entre os domínios da visão e da linguagem, ele realiza a compressão de conteúdo espacial, reduz o comprimento das sequências de tokens visuais e preserva informações semânticas importantes, como regiões de texto densas. • Modelo de Linguagem Leve (Hunyuan-0.5B): Baseado no Hunyuan LLM, com aproximadamente 0,5 bilhão de parâmetros, integra a tecnologia XD-RoPE, decompondo o RoPE em quatro subespaços: texto, altura, largura e tempo, suportando análise de layouts complexos e raciocínio sobre documentos entre páginas. O modelo suporta a modelagem unificada em múltiplas tarefas, executando tarefas desde a percepção até a semântica por meio de instruções em linguagem natural (como "detectar e reconhecer texto em uma imagem") sem a necessidade de módulos adicionais de pré-processamento. Ele abrange vários idiomas (mais de 130, incluindo idiomas com poucos recursos) e múltiplos cenários (como Street View, escrita à mão e quadros de vídeo), e enfatiza dados de alta qualidade alinhados à aplicação e otimização por aprendizado por reforço (RL) durante o treinamento para melhorar a robustez em cenários complexos. Treinamento e construção de dados (2 minutos) • Fase de pré-treinamento: Esta fase consiste em quatro etapas, totalizando aproximadamente 454 bilhões de tokens. Inclui alinhamento visual-linguístico, pré-treinamento multimodal, expansão de contexto longo (até 32 mil tokens) e ajuste fino supervisionado orientado à aplicação. Os dados combinam conjuntos de dados de código aberto, dados sintéticos em nível de elemento e dados de aplicação de ponta a ponta, totalizando aproximadamente 200 milhões de amostras de alta qualidade, abrangendo nove cenários, incluindo Street View, documentos e escrita à mão. • Fase pós-treinamento: O algoritmo de aprendizado por reforço online GRPO é utilizado, combinado com mecanismos de recompensa específicos para a tarefa (como os baseados em regras e o LLM como juiz). Isso melhora significativamente a precisão e a estabilidade do modelo em tarefas desafiadoras, como análise e tradução de documentos. O pipeline de dados enfatiza a composição e o aprimoramento: estendendo a estrutura SynthDog para gerar documentos longos e multilíngues, com suporte a layouts RTL e fontes complexas; introduzindo um pipeline de composição de distorção para simular defeitos do mundo real (como desfoque, distorção e alterações de iluminação); e um pipeline automatizado de geração de controle de qualidade que reutiliza amostras de diferentes tarefas para garantir diversidade e qualidade. Avaliação de desempenho - Detecção de texto (Spotting): Pontuação de 70,92% em um benchmark interno de 900 imagens (nove categorias de cena), superando o PaddleOCR (53,38%) e o Qwen3-VL-235B (53,62%). • Análise de documentos: Pontuação geral de 94,10% no OmniDocBench, com uma distância de edição de texto de 0,042; pontuação de 85,21% no Wild-OmniDocBench (captura de cena realista); pontuação de 91,03% no DocML (multilíngue). • Extração de informações e VQA: 92,29% de precisão em um benchmark de 768 cartões/bilhetes; 92,87% de extração de legendas de vídeo; pontuação de 860 no OCR Bench. • Tradução de texto e imagem: Suporta mais de 14 idiomas de origem para chinês/inglês, com uma pontuação COMET de 83,48% em DoTA e 73,38% (outros para inglês)/73,62% (outros para chinês) em DocML. Esses resultados destacam a eficiência do modelo em um nível leve, especialmente em cenários do mundo real, onde ele supera os VLMs modulares e os pipelines tradicionais. O @vllm_project oferece suporte à inferência eficiente, gerando um máximo de 16.384 tokens. O relatório fornece modelos de dicas específicos para cada tarefa, como detecção de coordenadas, extração de JSON ou tradução, e é compatível com chinês e inglês. Modelo de código aberto:

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.